この記事のポイント

データの偏りとブラックボックス問題の存在

ディープフェイクによる偽情報拡散とプライバシー侵害リスク

AI創作物の著作権に関する新たな法的課題

労働市場の変化と社会的格差拡大の懸念

多様なデータ活用、XAI導入、倫理的ガイドライン策定の必要性

Microsoft MVP・AIパートナー。LinkX Japan株式会社 代表取締役。東京工業大学大学院にて自然言語処理・金融工学を研究。NHK放送技術研究所でAI・ブロックチェーンの研究開発に従事し、国際学会・ジャーナルでの発表多数。経営情報学会 優秀賞受賞。シンガポールでWeb3企業を創業後、現在は企業向けAI導入・DX推進を支援。

生成AIは、画像、音声、テキストなどのコンテンツ生成に革命をもたらしていますが、同時に多くの問題点も浮上しています。

本記事では、生成AIが抱える技術的、倫理的、社会的な課題を詳細に解説します。

データバイアスやブラックボックス問題、ディープフェイクによる偽情報拡散、プライバシー侵害、著作権問題、さらには労働市場への影響や社会格差の拡大など、多岐にわたる問題を探ります。

また、これらの課題に対する解決策や、生成AIと共存する未来に向けた展望についても考察します。

目次

生成AIの問題点とは

生成AI(Generative AI)は、画像、音声、テキストなどの多様なコンテンツを創出し、様々な産業に革新をもたらしています。しかし、この技術の急速な発展に伴い、多くの問題点も浮上しています。

生成AIの主な問題点は、主に以下の三つのカテゴリーに分類されます。

- 技術的な問題点

データの偏りやブラックボックス問題など、AIシステムの内部構造に関連する課題。 - 倫理的な問題点

ディープフェイクによる偽情報の拡散、プライバシーの侵害、著作権の問題など、AIの使用が社会の倫理観に与える影響。 - 社会的な問題点

労働市場への影響や社会的格差の拡大など、AIの普及が社会構造に及ぼす変化。

これらの問題点は、生成AIの健全な発展と社会への適切な統合を考える上で非常に重要です。

以下のセクションでは、各カテゴリーの問題点について詳細に解説し、その対策についても探っていきます。

生成AIの技術的な問題点

生成AIは革新的な技術ですが、その実装と運用には重要な技術的課題が存在します。

ここでは、データの偏りとブラックボックス問題という二つの主要な技術的問題点について詳しく解説します。

データの偏り

生成AIの性能は、学習データの質と量に大きく依存します。

しかし、このデータに偏りがあると、AIの出力にもその偏りが反映されてしまいます。

例えば、特定の文化や性別に偏ったデータで学習したAIは、その偏りを含んだ文章や画像を生成する可能性があります。

これは単なる技術的な問題だけでなく、社会的公平性にも影響を及ぼす重大な問題です。

例えば、採用AIが無意識のうちに特定の性別や人種を優遇してしまうケースが報告されています。

このような偏りは、社会の不平等を助長する恐れがあり、AIの公平性と信頼性を損なう可能性があります。

ブラックボックス問題

生成AIモデル、特に深層学習を用いたモデルは、しばしば「ブラックボックス」と呼ばれます。

これは、モデルがどのようにして結果を導き出したのかが、人間には理解しづらいことを指します。

例えば、医療診断に使用されるAIモデルが、なぜその診断結果に至ったのかを明確に説明できない場合、医師や患者はその結果を完全に信頼することが難しくなります。

この透明性の欠如は、AIの判断に対する信頼性や説明責任に大きな影響を与えます。

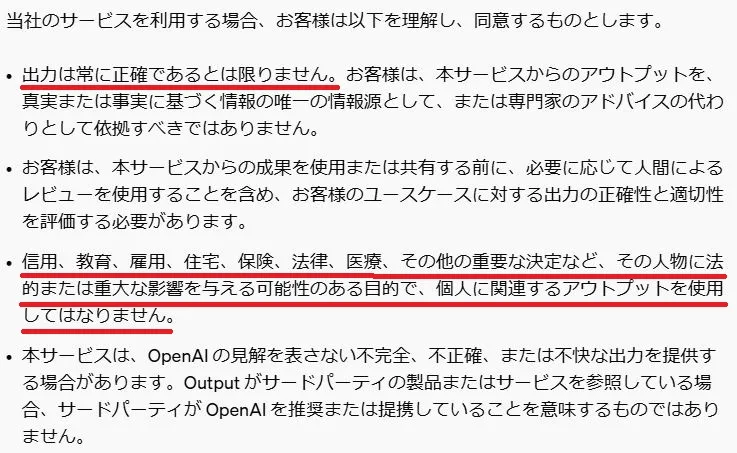

実際、OpenAIはChatGPTの利用規約において、専門性が高く重要な分野である医療や金融分野での利用を推奨していないと明記しています。

*利用規約の該当部分 参考:OpenAI利用規約

これらの分野での利用はユーザー自身で責任を負う必要があるため、注意が必要です。

生成AIの倫理的な問題点

生成AIの発展に伴い、様々な倫理的問題が浮上しています。

ここでは、ディープフェイクの悪用や偽情報の拡散、プライバシーの侵害、そして著作権の問題という三つの主要な倫理的課題について詳しく解説します。

ディープフェイク・偽情報拡散のリスク

生成AIの発展により、リアルな偽情報を生成することが可能になりました。

特に「ディープフェイク」と呼ばれる技術は、人物の顔や声を高度に模倣し、「実在の人物が言動していないことを、いかにも言動しているかのように見せること」ができます。

この技術は、娯楽や教育などの分野で革新的な応用が期待される一方で、悪用されれば社会に深刻な混乱をもたらす可能性があります。

例えば、政治家の偽の発言動画が拡散されることで、選挙結果に影響を与えたり、社会の分断を助長したりする恐れがあります。

実際に日本でも岸田首相のディープフェイク動画が拡散され、混乱が起きました。

この事例では、動画作成に要した時間はわずか1時間程度で、作成者は「中学生でも作成できると思う」と述べており、その手軽さと潜在的な危険性が浮き彫りになりました。

作成が容易なだけではなく、自由度が高いことも大きな問題といえます。

プライバシーの侵害

生成AIの利用には、ユーザーの個人情報や機密情報が不正に利用されるリスクが伴います。

例えば、AIチャットボットに入力された個人情報が、意図せず第三者に漏洩する可能性があります。

また、企業が機密情報を含むデータをAIに入力した場合、その情報が外部に流出するリスクもあります。

これは単なるデータ漏洩の問題だけでなく、AIが学習したデータを基に個人の行動パターンや嗜好を予測し、プライバシーを侵害する可能性もあります。

プライバシーの侵害は個人の権利を脅かす重大な問題であり、生成AIの利用においては、データの取り扱いに十分な注意が必要です。

著作権の問題

生成AIが既存の作品を元に新たな作品を生成する際、著作権侵害の可能性を考える必要があります。

例えば、音楽生成AIが既存の楽曲の一部を参考にして新しい楽曲を作成した場合、元の楽曲の著作権を持つ人の権利が侵害されることがあります。

また、絵画生成AIが著名なアーティストのスタイルをコピーして新しい作品を生成する場合も、同様の問題が発生する可能性があります。

この問題は特に音楽やアートの分野で顕著ですが、文章や映像など、他の創作物でも同様のリスクがあります。著作権侵害の問題を避けるためには、生成AIの利用において*適切なデータの使用と、生成AIの利用規約の確認が重要です。

AIで生成した作品の著作権問題については以下の記事でも詳しく解説していますので、参考にしてください。

【関連記事】

AIで生成した作品の著作権はどうなる?注意点や実際の事例を徹底解説 | AI総合研究所

AI生成コンテンツの商用利用に関する概要と法的見解を解説し、適切な利用のための指針を提供します。

https://www.ai-souken.com/article/ai-generated-copyright-explanation

生成AIが引き起こす社会的な問題

生成AIの急速な発展は、私たちの社会に大きな変革をもたらすと同時に、新たな社会的問題を引き起こす可能性があります。

ここでは、労働市場への影響と社会的格差の拡大という二つの主要な社会的問題について詳しく解説します。

労働市場への影響

生成AIの進化により、多くの職業が自動化されるリスクが高まっています。特に、定型的な業務や創造的な作業の一部がAIに代替される可能性が指摘されています。

例えば、カスタマーサービス分野では、AIチャットボットが人間のオペレーターに取って代わるケースが増加しています。

また、文章作成やデザインの分野でも、AIがライターやデザイナーの仕事の一部を代替する動きが見られます。

実際に、コピーライターの仕事をしていた人が、ChatGPT4の登場からわずか2週間で職を失ってしまった事例が報告されています。

参考:NHK「AIで仕事失いました」あなたの働き方が変わる?

社会的格差の拡大

生成AIの普及は、新たな形の社会的格差を生み出す可能性があります。

この格差は主に以下の3つの側面に生じると考えられます。

企業間の格差

高度な技術力と資金力を持つ大企業は、生成AIを活用して効率を上げたり、新しいビジネスモデルを創出したりできます。

一方、中小企業や個人事業者は、リソースの制約からAI導入が遅れ、競争力に差が生じる可能性があります。

教育格差

AIリテラシーの差が新たな教育格差を生み出す可能性があります。

都市部の教育機関や富裕層の家庭では、最新の技術教育を受ける機会が多い一方、地方や低所得層ではそのような機会が限られる傾向があります。

所得格差

AIの開発や運用に関する高度なスキルを持つ人材は高い需要があり、高収入を得られる一方、AIに代替される可能性が高い職種の労働者は、所得の低下や失業のリスクに直面する可能性があります。

これらの社会的問題は、生成AIの発展がもたらす恩恵と同時に考慮すべき重要な課題です。

次のセクションでは、これらの問題に対する具体的な対策と解決策について探っていきます。

生成AIの問題点への対策と解決策

生成AIがもたらす様々な問題に対して、技術的、倫理的、社会的な観点から多角的なアプローチが必要です。

ここでは、主要な3つの解決策について詳しく解説します。

多種多様なデータを学習させる

データバイアスの問題を解消するためには、多様なデータセットを使用することが重要です。

具体的には以下のような取り組みが考えられます。

- 多様性を考慮したデータ収集

異なる人種、性別、年齢層、文化背景を持つデータをバランスよく収集し、学習に使用することでバイアスを減らすことができます。

- バイアス検出技術の活用

Amazon SageMaker Clarifyのような、データバイアスを検出し修正するための技術を活用することが有効です。

Amazon SageMaker Clarify (参考:Amazon SageMaker Clarify)

- 継続的なモニタリングと更新

AIモデルのパフォーマンスと出力を定期的に監視し、新たなバイアスが生じていないか確認することが重要です。

社会の変化に合わせてデータセットを更新し、モデルを再学習させることで、長期的なバイアス軽減が可能になります。

これらの取り組みにより、より公平で信頼性の高い生成AIの開発が期待できます。

モデルの透明性を高める(XAI)

日立のXAI 参考:HITACHI

生成AIの決定プロセスを明確にするためには、**説明可能なAI(XAI)**の導入が有効です。

XAIは、AIモデルの判断基準を理解しやすく説明する技術です。

XAIの導入により、以下のような利点が期待できます:

- 思決定プロセスの可視化

例えば、医療診断AIでは、診断結果に至るプロセスを詳細に説明する機能を追加することで、医師や患者が結果を理解しやすくなります。

- 信頼性の向上

AIの判断根拠が明確になることで、ユーザーがAIの決定を信頼しやすくなります。

これは特に、金融や法律など、重要な決定を伴う分野で重要です。

- 改善点の特定

モデルの判断プロセスが明確になることで、バイアスや誤りの原因を特定しやすくなり、モデルの改善につながります。

XAIの実現には、モデルの設計段階から透明性を重視し、結果の解釈を可能にする仕組みを構築することが重要です。

倫理的ガイドラインの策定と遵守

生成AIの開発と利用には、倫理的ガイドラインを作り、それを遵守することが不可欠です。

具体的には、以下のような取り組みが考えられます。

- 倫理的ガイドラインの策定と遵守

生成AIの開発と利用には、倫理的ガイドラインの策定と遵守が不可欠です。具体的な取り組みとして、以下が挙げられます:

- AI倫理委員会の設置技術者、倫理学者、社会学者など多様な専門家を含む委員会を組織し、開発や運用を倫理的観点から評価します。

包括的なガイドラインの策定

データの透明性、個人情報保護、公正なAI利用、説明責任、環境配慮などの要素を含めます。

- 定期的な監査と評価

ガイドラインの遵守状況を確認し、問題を未然に防ぎます。

- 教育とトレーニング

開発者やユーザーに倫理的なAI利用に関する教育を提供し、組織全体で問題意識を共有します。

これらの対策により、生成AIの問題点を最小限に抑えつつ、その潜在的利点を最大化することが可能になります。

まとめ

本記事では、生成AIがもたらす技術的、倫理的、社会的な問題点について詳しく解説しました。

データの偏り、ブラックボックス問題、ディープフェイクによる偽情報拡散、プライバシー侵害、著作権問題、労働市場への影響、社会的格差の拡大などの課題を取り上げました。

これらの問題に対する解決策として、多様なデータの活用、XAIの導入、倫理的ガイドラインの策定と遵守などを提案しました。

生成AIの健全な発展には、技術開発と社会的枠組みの両面からのアプローチが不可欠であり、私たち一人一人のAIリテラシー向上も重要です。

今後は、技術の進歩と人間の価値観のバランスを取りながら、生成AIとの調和のとれた未来を築いていくことが課題となるでしょう。