この記事のポイント

この記事は、ディープラーニングに関する総合的な解説を提供しています。

ディープラーニングは複雑なパターンを学習するための技術であり、多層のニューラルネットワークが特徴です。

多様な分野での応用例があり、画像認識や自然言語処理などで顕著な成果を上げています。

初級者向けの学習方法として、CourseraやFast.aiなどのオンラインリソースを利用することが推奨されます。

ディープラーニングの実用化にはまだ解決すべき課題がありますが、今後の展望は明るいとされています。

Microsoft MVP・AIパートナー。LinkX Japan株式会社 代表取締役。東京工業大学大学院にて自然言語処理・金融工学を研究。NHK放送技術研究所でAI・ブロックチェーンの研究開発に従事し、国際学会・ジャーナルでの発表多数。経営情報学会 優秀賞受賞。シンガポールでWeb3企業を創業後、現在は企業向けAI導入・DX推進を支援。

ディープラーニングは、私たちの生活に革新をもたらす可能性を秘めた技術です。

この記事では、その基本から始まり、ニューラルネットワークの仕組み、さまざまなタイプのネットワークモデル、そして実際の応用例について解説しています。

また、機械学習とディープラーニングの違い、初級者が学ぶための方法、そして技術の高速化やプラットフォーム、課題と今後の展望に触れています。

この記事を通じて、ディープラーニングの深い理解を得られるように構成されていますので、ディープラーニングに興味がある方、学び直しを望む方にとって、理想的な内容になっています。

ディープラーニングとは

ディープラーニングとは、機械学習の一分野 であり、データから複雑なパターンを学習するための技術のことを指します。

この技術は、脳内のニューロンが情報を処理する様子に触発されており、特に多層の人工ニューラルネットワークが用いられることが特徴です。画像、自然言語処理、音声認識など、さまざまな分野での問題解決に応用されています。

基本概念としては、「深い」学習を示す「ディープ」が重要で、データからの特徴抽出やパターン識別を自動的に行い、従来の手法では捉えきれない複雑な関係性をモデル化する能力 を持っています。

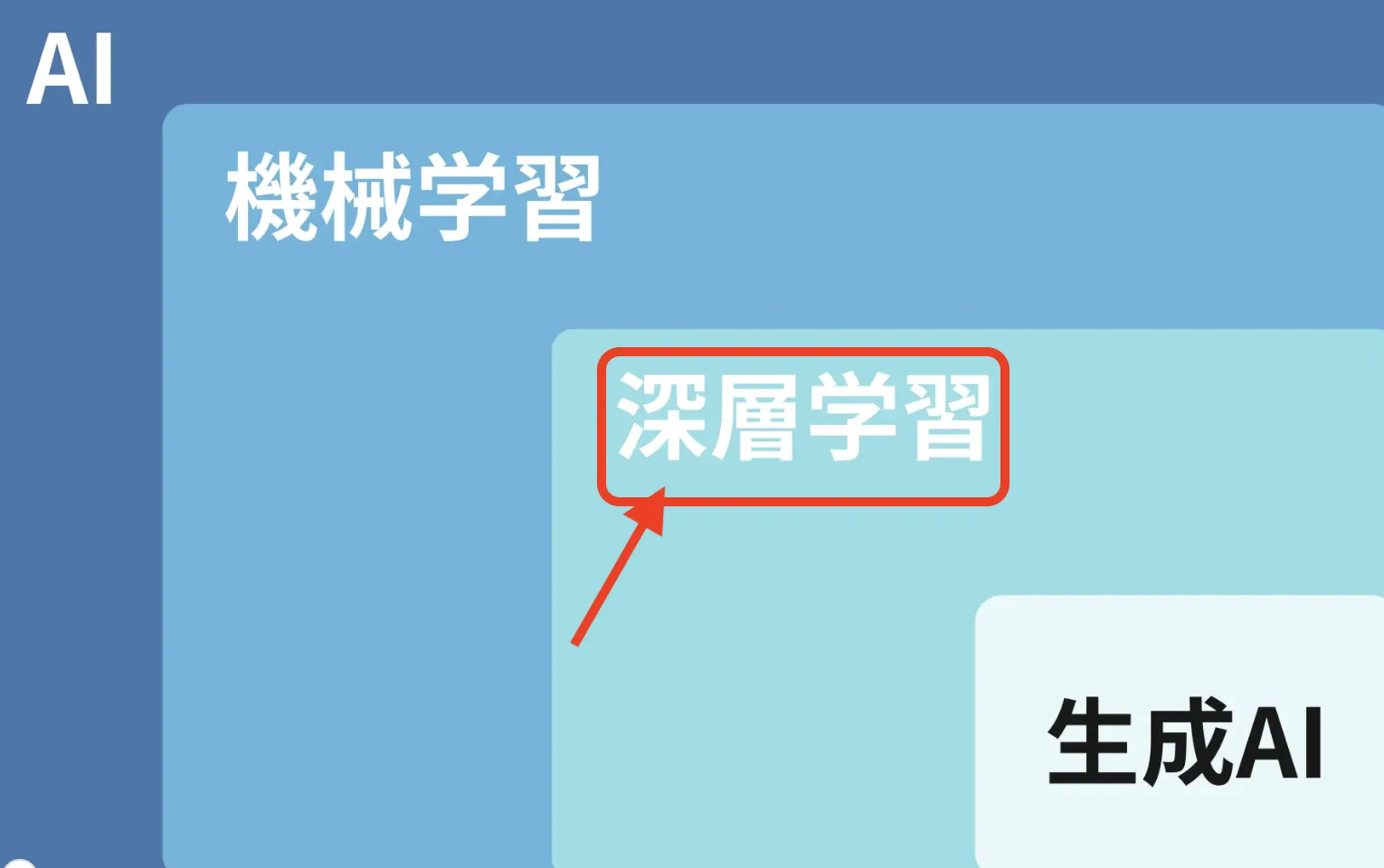

生成AIとディープラーニングの関係

生成AI(Generative AI)は、テキスト、画像、音声、動画などを生成するAI技術です。主に、データからパターンを学び、それを基に新しいコンテンツを作成します。

例としては、ChatGPTのようなテキスト生成モデルやDALL-Eのような画像生成モデルが挙げられます。

そのため、深層学習は生成AIで使用されるモデルであり、その種類は様々です。

代表的なモデルには以下のようなものがあります。

各モデルの詳細についてはリンク先で丁寧に紹介していますのでぜひご参考にしてみてください。

-

生成モデル:確率的に新しいデータを生成するためのモデル

GAN(Generative Adversarial Networks):画像や動画の生成で広く使われる

VAE(Variational Autoencoders):生成モデルの一種で、画像やデータの圧縮にも使用

-

トランスフォーマーモデル:自然言語処理や画像生成で活用

GPT(Generative Pre-trained Transformer):テキスト生成

DALL-E:画像生成

Codex:プログラムコード生成

【関連記事】

生成AIとは?その種類や従来のAIとの違い、メリット・問題点を解説!

ディープラーニングの仕組み

では、本題のディープラーニングの仕組みに戻ります。

ディープラーニングの仕組みは、主にニューラルネットワークに基づいています。

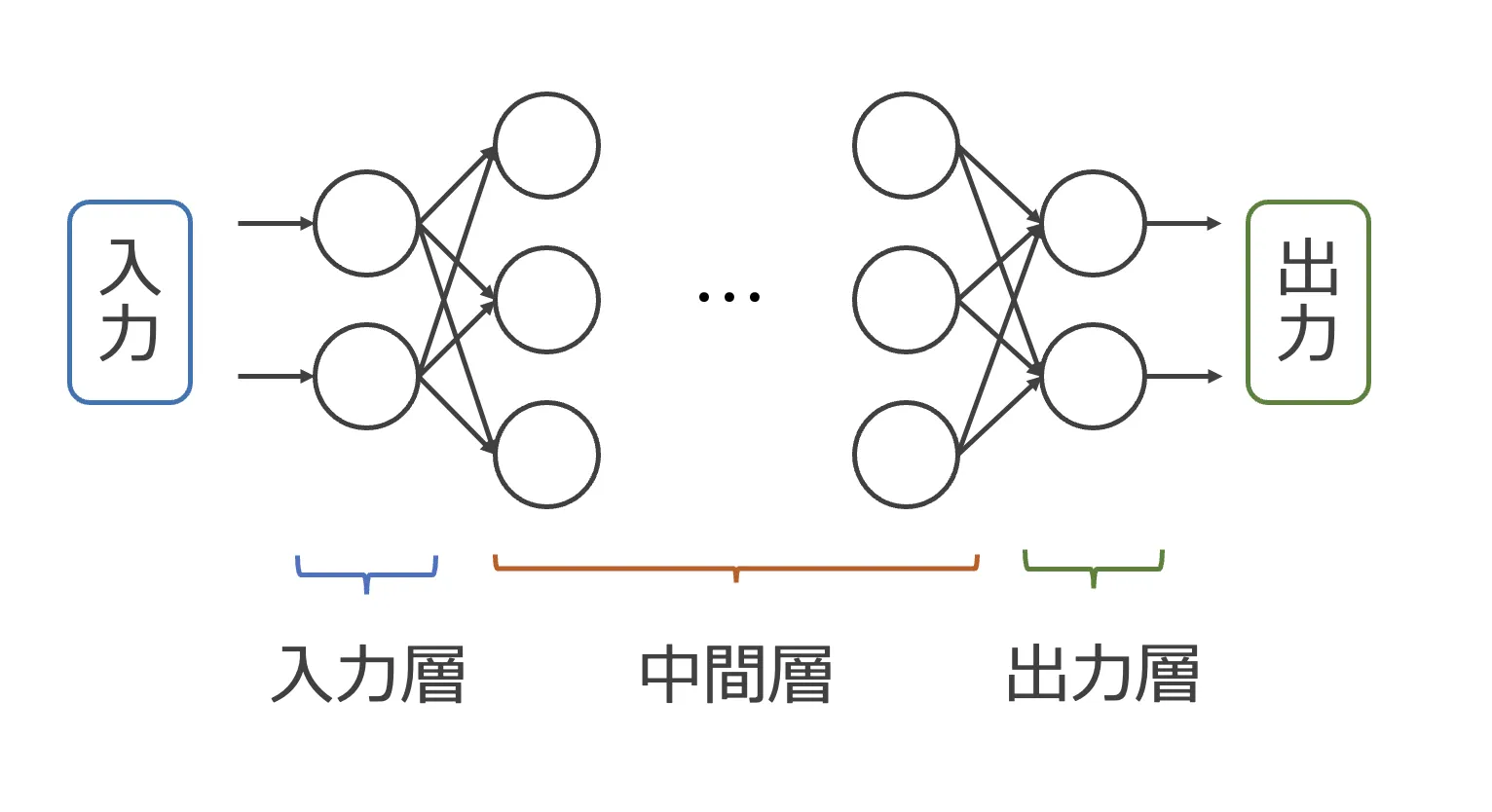

ニューラルネットワークの概要図

一般的なニューラルネットワークは、入力層、中間層(隠れ層)、出力層から構成され、それぞれの層はノード(人工ニューロン)と呼ばれる単位から成ります。

ノードは前の層から複数の入力を受け取り、線形結合と非線形の活性化関数の処理を通じて、次の層へ1つの出力を生成します(後ほど詳しく説明します)。

ディープラーニングでは、特に隠れ層が多層にわたって存在することから、データに内在する複雑なパターンを捉えることが可能となります。

線形結合とは

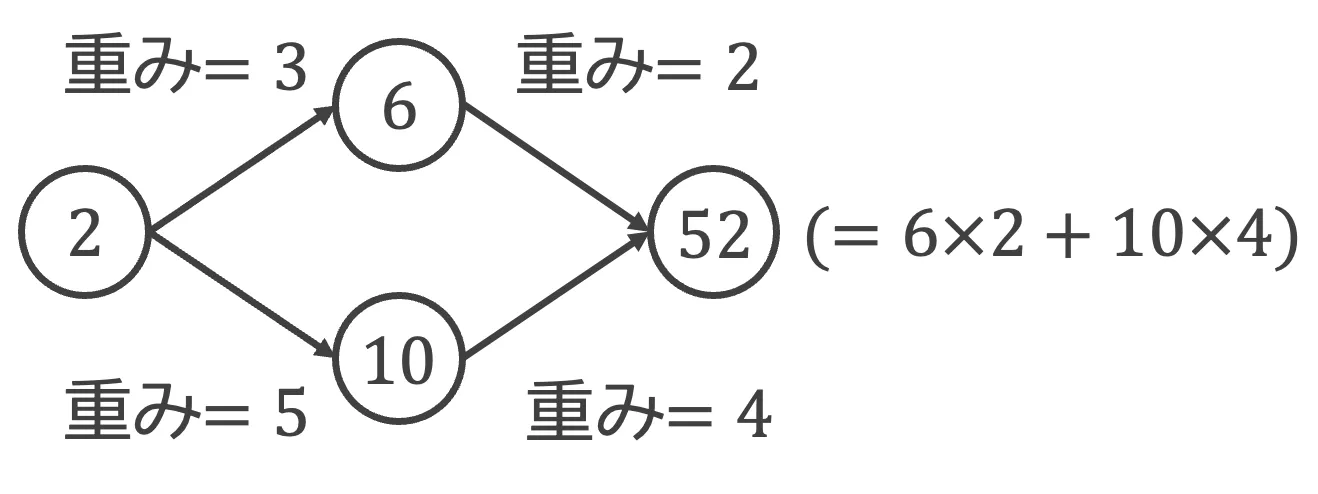

線型結合(一次結合)とは、ベクトルを定数倍したものを足し合わせることです。以下の、簡単なニューラルネットワークの例を用いて解説します。

簡単なニューラルネットワークの例

まず、入力層のノードは「2」という値のベクトルであるとします。このノードは、中間層の2つのノードに、それぞれ違う重みをかけて出力します。

ここではそれぞれ、「2x3 = 6」, 「2x5 = 10」となります。最後に、中間層のノードからそれぞれ違う重みをかけて足し合わせたものを出力層のノードに出力します。

すると「6x2 + 10x4 = 52」となります。

以上のように、ベクトルを定数倍したものを足し合わせることを線型結合と呼びます。

活性化関数とは

活性化関数とは、出力を変換するために、ニューラルネットワークの各層に適用する関数のことです。活性化関数を適用することで、出力を変換できます。

また、活性化関数を適用するまでは線型変換のみでしたが、非線形変換である活性化関数を適用することで、出力を非線形に変換できます。

活性化関数にはいくつかの種類があり、代表的なものとしてはシグモイド関数、ハイパボリックタンジェント、ReLUなどがあります。

例えばシグモイド関数を適用すると、出力を二値(0もしくは1)に変換でき、ニューロンの1つ1つが二値分類器として振る舞えるようになります。

機械学習とディープラーニングの違い

機械学習とディープラーニングの違い

機械学習は、データから学習して予測や判断を行う技術の総称で、その中にディープラーニングが含まれています。しかし、機械学習とディープラーニングはいくつかの点で異なります。

一つの大きな違いは、データの特徴抽出において機械学習では人の手で特徴量を与える必要があるのに対し、ディープラーニングは特徴を自動的に学習していく能力を持っており、手作業による前処理が少なくて済むという点です。

また、ディープラーニングは隠れ層が多数存在するため、より抽象的で複雑なデータの表現を捉えることができ、これにより画像認識や自然言語処理などの分野で顕著な成果を上げています。

ディープラーニングの種類

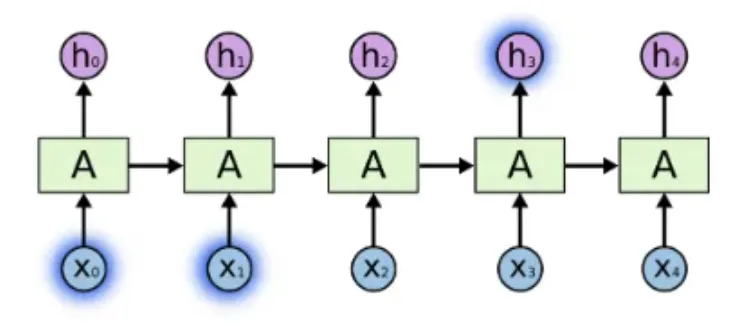

ディープラーニングには、RNN, LSTM, CNNといった様々な種類のニューラルネットワークが用いられます。

ここでは、それぞれのニューラルネットワークの特徴について解説していきます。

【関連記事】

LSTMとは?その仕組みや使用例をわかりやすく解説! RNNとの違いもご紹介

RNN(再帰型ニューラルネットワーク)

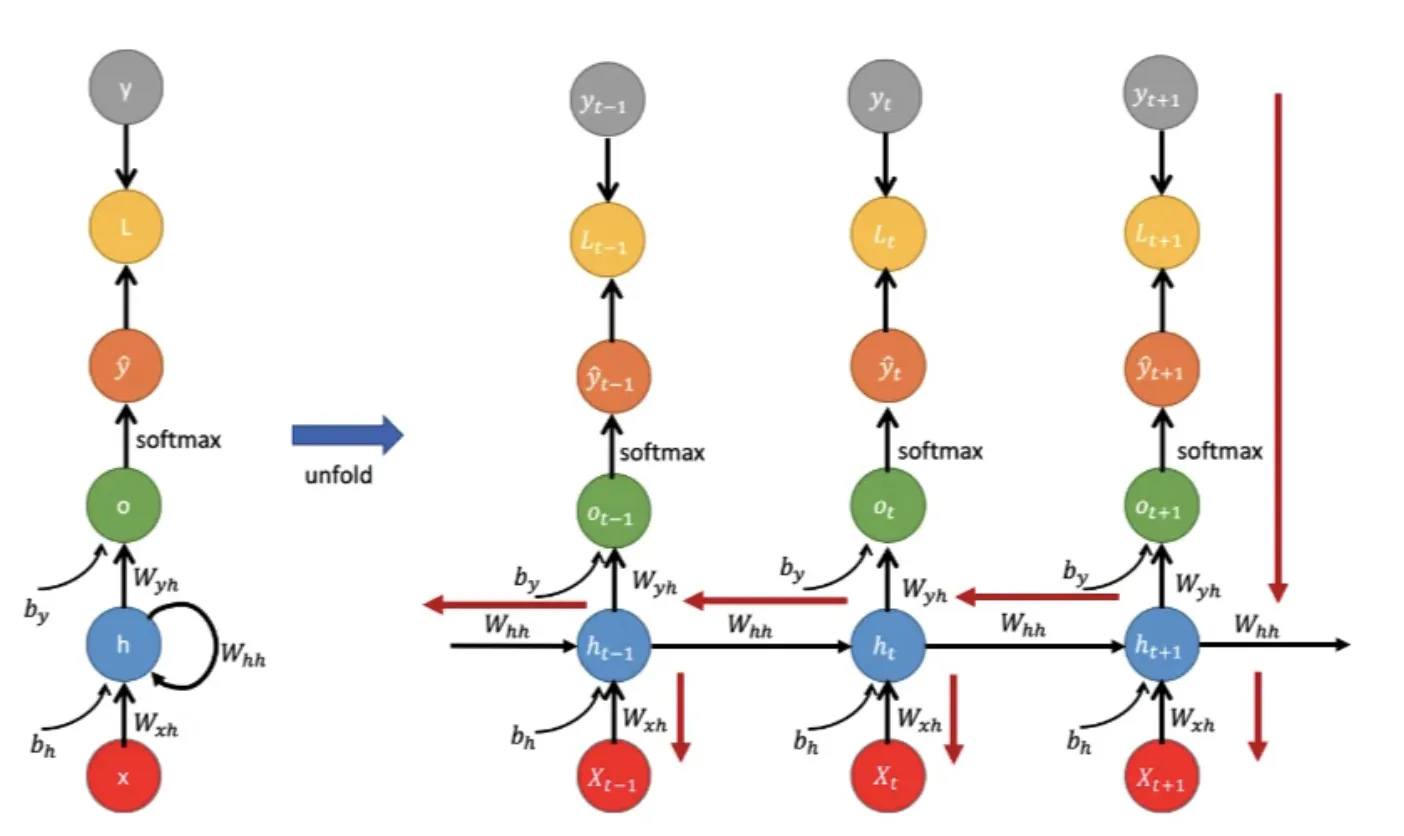

RNNはRecurrent Neural Networkの略で、再帰型ニューラルネットワークと呼ばれています。

RNNの最大の特徴は、時系列データを扱えることです。

RNNの処理について

次に、RNNの処理について説明します。

ここでは、RNNに文を与える場合について考えます。この場合RNNは、与えられた文を時系列順に、つまり単語ごとに処理していくことになります。

単語を先頭から末尾まで順番に入力していきますが、その際に毎回(毎時刻)以下の処理をしています。

1. 現在の入力ベクトルと過去(先頭〜直前)の入力からなるベクトル(隠れ状態ベクトル)を合成する

2. 合成して得た新たなベクトルを次の入力ベクトルとともに入力する

という処理をします。前述の処理を繰り返しすることから、再帰型ニューラルネットワークと呼ばれています。

以上のような処理によって、RNNは次に来るべき単語を予測する能力を獲得します。

この能力を用いて対話や言い換えなどの生成タスクに利用したり、全ての入力に対して得られた出力(末尾の出力ベクトル=文ベクトル)を用いてカテゴリ分類などのタスクに用いたりと、RNNは幅広いタスクを処理可能なニューラルネットワークとなっています。

しかし、RNNは入力を先頭から順番に処理していくという性質上、最初の方の入力を忘れてしまう(先頭に近いほど末尾の出力ベクトルに与える影響が小さくなってしまう)という問題 があります。

RNNの長文に対する解決策について

この問題に対する解決策を2つ紹介します。

まず1つ目は、末尾の出力ベクトルだけを用いるのではなく、全ての時刻のベクトルを用いる手法です。例えば、全ての自国のベクトルの平均を求める平均値プーリングや、ベクトルの要素ごとの最大値を利用する最大値プーリングなどがあります。

2つ目は、ベクトルの合成向きを逆にする手法です。先ほどの説明では順方向(文を先頭から末尾にかけて)の処理をすると説明しましたが、この手法では逆方向(末尾から先頭にかけて)の処理をします。このようにすることで、ある時刻の入力に対して、その位置よりも後ろの単語の情報を用いることが可能となります。また、順方向の処理をするRNNと逆方向の処理をするRNNを組み合わせた、双方向RNNと呼ばれるものも存在します。

以上でRNNでの文ベクトルの求め方や、タスクの解き方、および学習方法について説明しました。

しかし、RNNで学習をする際には、「勾配消失問題」や「勾配爆発問題」と呼ばれる問題が発生することがあります。勾配消失というのは、ニューラルネットワークを学習する際に、出力から遠くなるにつれて勾配が小さくなり、それによってパラメータの値が更新しにくく(学習がしにくく)なってしまうという問題があります。一方勾配爆発というのはその逆で、勾配が大きくなりすぎることによって急激にパラメータの更新がされたり、オーバーフローしてしまったりという問題があります。

この問題に対して提案されたニューラルネットワークアーキテクチャが長期短期記憶(LSTM)というものです。このLSTMについては次項で説明します。

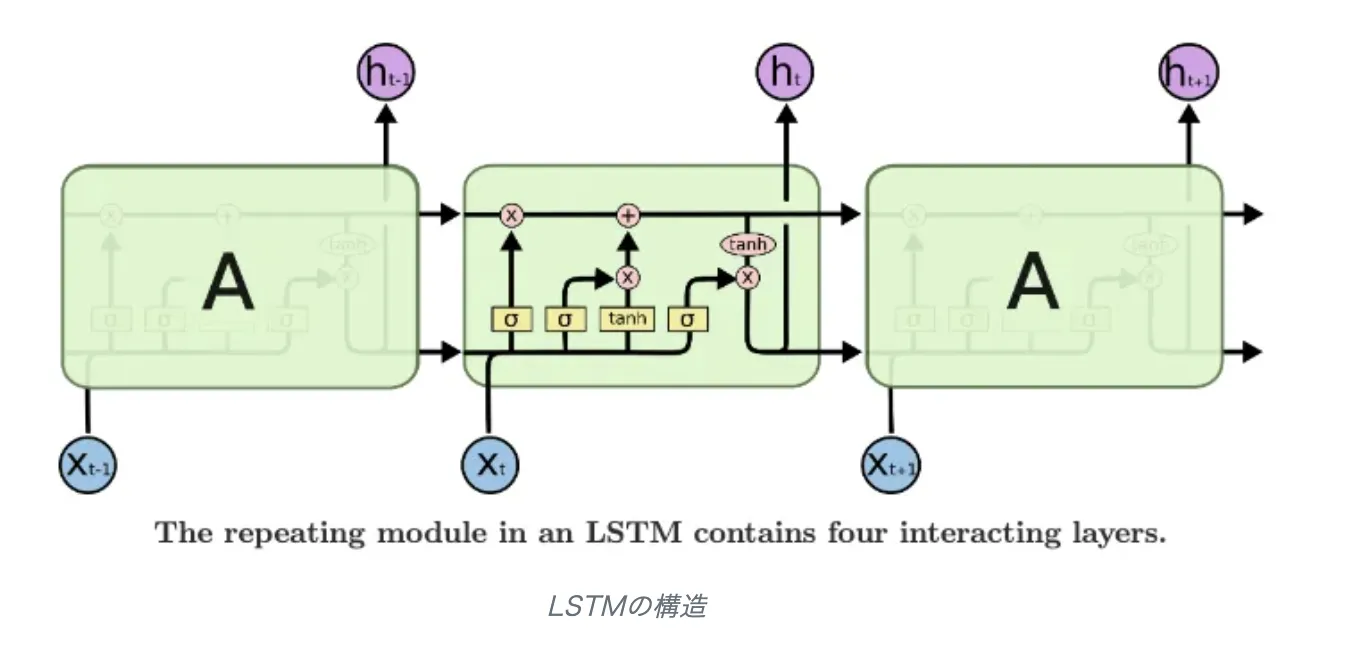

LSTM(長期短期記憶)

LSTMはLong Short-Term Memoryの略で、RNNで発生する勾配消失問題や、勾配爆発問題に対して提案されたニューラルネットワークアーキテクチャです。

RNNと異なるのは、LSTMにはいくつかの「ゲート」と呼ばれる機構と、「メモリセル」と呼ばれる記憶機構が追加されたことです。

まず、ゲート機構について説明します。LSTMには4つのゲートがあり、それぞれ「セルゲート」, 「入力ゲート」, 「出力ゲート」, 「忘却ゲート」と呼ばれています。

セルゲート

セルゲートとは、現時刻の入力ベクトルと直前の隠れ状態ベクトルから合成され、各要素が-1~1の範囲に収まるよう正規化したものです。

入力ゲート

入力ゲートは、セルゲートをどのくらい現時刻のメモリセルに読み込むかを調節する役割があります。入力ゲートは現時刻の入力ベクトルと隠れ状態ベクトルを合成し、シグモイド関数を適用したものなので、値は0~1の範囲を取ります。

出力ゲート

出力ゲートは、現時刻のメモリセル(入力ゲートから読み込まれたセルゲート)を、どれくらい現時刻の隠れ状態ベクトルとして出力するかを制御する役割があります。

出力ゲートも入力ゲート同様、現時刻の入力ベクトルと隠れ状態ベクトルを合成し、シグモイド関数を適用したものなので、値は0~1の範囲を取ります。

この出力ゲートの値が0に近ければ、現時刻のメモリセルは現時刻の隠れ状態ベクトルとして出力されにくくなり、反対に1に近ければ出力されるようになります。

忘却ゲート

忘却ゲートは、直前のメモリセルの情報を現時刻のメモリセルに用いるかどうかを決定する役割があります。直前のメモリセルの情報を用いるかどうかは、忘却ゲートと直前のメモリセルとの要素積(行列の積)を計算した結果を用います。

忘却ゲートも入力ゲートや出力ゲートと同様、現時刻の入力ベクトルと隠れ状態ベクトルを合成し、シグモイド関数を適用したものなので、値は0~1の範囲を取ります。以上のことから、忘却ゲートの値が0に近ければ直前のメモリセルの情報を捨て、1に近ければ現時刻のメモリセルに受け継がれます。

CNN(畳み込みニューラルネットワーク)

CNN(Convolutional Neural Network)は、主に画像分野で使用される深層学習モデルであり、特に物体認識などで高い性能を発揮します。また、CNNは自然言語処理の分野でも応用され、分類タスクや特徴抽出に利用されています。

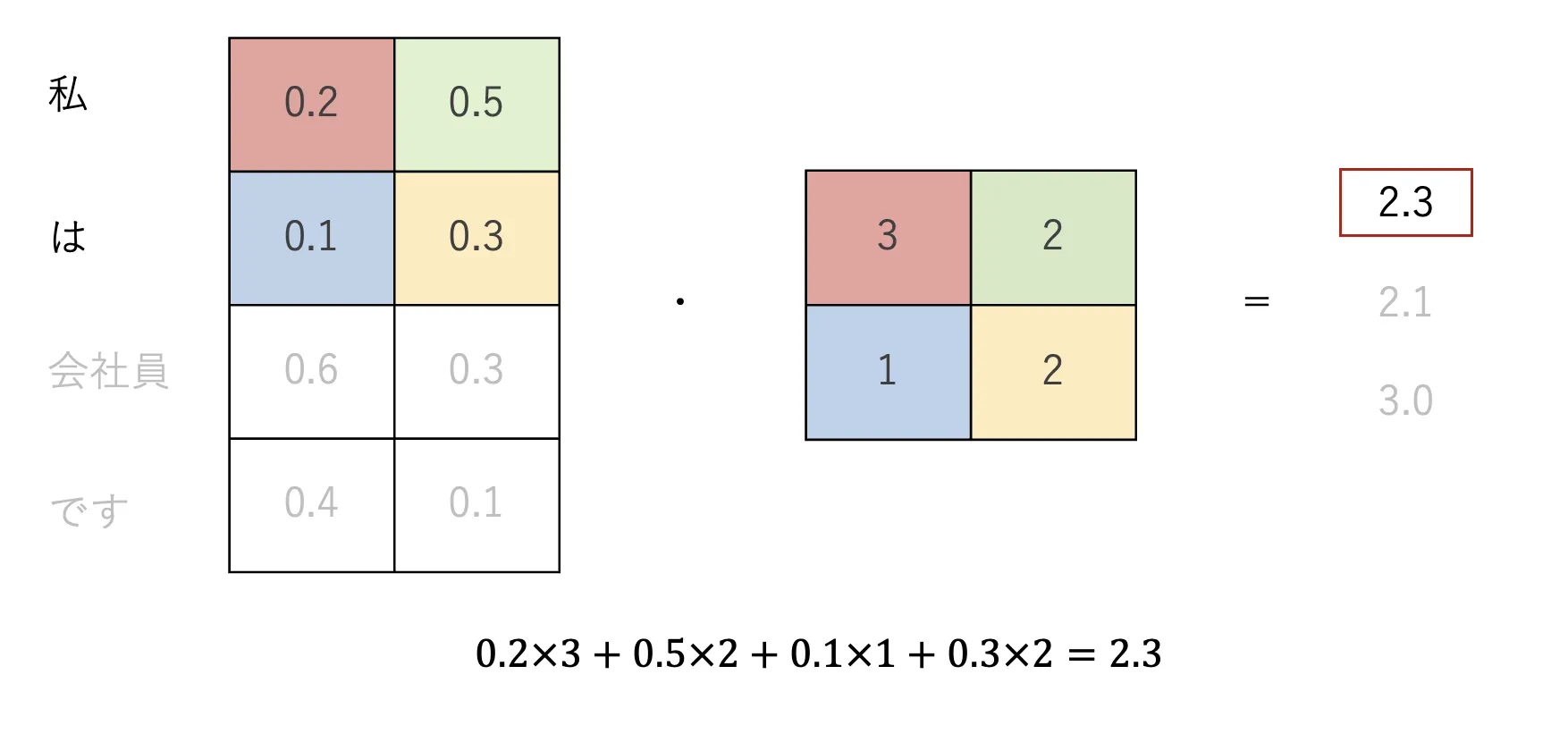

CNNの特徴的な要素として、「畳み込み演算」が挙げられます。畳み込み演算とは、周辺の情報を効率的にまとめて新しいデータを作成する計算方法のことで、以下の図を用いて説明します。

畳み込みの計算方法

畳み込み演算のステップ

-

入力データの準備

入力データは画像のような2次元(縦×横)または3次元(縦×横×チャンネル数)の配列です。たとえば、グレースケール画像は2次元配列、RGB画像は3次元配列で表されます。

-

フィルタ(カーネル)の準備

フィルタは小さな行列(例:3×3や5×5)で、特徴を抽出する役割を持ちます。このフィルタは、畳み込み演算の過程で学習され、タスクに応じたパターンを検出できるようになります。

-

畳み込み演算の実行

フィルタを入力データの左上から右下にスライドさせながら、以下の処理を行います:- フィルタと入力データの該当部分の要素ごとに掛け算します。

- 掛け算の結果を合計し、1つの値を算出します。

- この値を特徴マップ(出力データ)の対応する位置に格納します。

-

ストライド(移動量)とパディング

- ストライド:フィルタをスライドさせる間隔(例:ストライド1は1ピクセルずつ移動)。

- パディング:入力データの端を処理するために外側にゼロなどを追加する操作です。

計算例:3×3フィルタでの畳み込み

入力データ(例:5×5の行列)

1 2 3 0 1

0 1 2 3 4

1 0 1 2 3

2 1 0 1 0

0 1 2 3 4

フィルタ(例:3×3の行列)

1 0 -1

1 0 -1

1 0 -1

演算手順

-

フィルタを入力データの左上に重ねます。

- 該当部分の入力データ:

1 2 3 0 1 2 1 0 1 - フィルタとの掛け算の結果:

(1×1) + (2×0) + (3×-1) + (0×1) + (1×0) + (2×-1) + (1×1) + (0×0) + (1×-1) = -2 - この結果(-2)を特徴マップの対応する位置に記録します。

- 該当部分の入力データ:

-

フィルタを1ピクセル(ストライド1の場合)右にスライドし、同様の演算を繰り返します。

以上のように、畳み込み演算により、CNNは入力データから局所的な特徴(エッジやパターンなど)を効率的に抽出します。

この操作を繰り返すことで、低レベルな特徴から高レベルな特徴を段階的に学習し、画像認識や分類などの多様なタスクに適用できます。

ディープラーニングの応用例

ディープラーニングは、その汎用性と高度なパターン認識能力により、多くの分野で革新をもたらしています。

画像認識においては、顔認証システムや自動運転車のオブジェクト検出などに利用され、精度の高い識別が可能になりました。

自然言語処理では、機械翻訳やチャットボット、音声アシスタントといった技術に活用され、人間に近い自然な対話を可能にしています。

その他にも、医療診断での画像解析、株式市場の予測分析、創薬など、ディープラーニングの応用は広がりを見せており、インパクトを与える象徴的な事例が数多く存在しています。

代表的なサービスには以下のようなものがあります。

| 分野 | 応用例 | 代表的なサービス・技術 |

|---|---|---|

| 画像認識 | 顔認証システム、自動運転車のオブジェクト検出 | Google Photos、Tesla Autopilot |

| 自然言語処理 | 機械翻訳、チャットボット、音声アシスタント | Google Translate、ChatGPT |

| 医療 | 医療画像解析、がん診断、病変部位の自動検出 | IBM Watson Health、DeepMind Health |

| 金融 | 株式市場の予測、リスク分析、不正検出 | Kensho、Darktrace |

| 創薬 | 新薬候補物質の探索、分子設計 | Atomwise、Insilico Medicine |

| 生成AI | テキスト生成、画像生成、音声生成、動画生成 | ChatGPT、DALL-E、DeepFake |

| エンターテインメント | 映像編集、コンテンツ生成、音楽作成 | Adobe Sensei、Amper Music |

| ロボティクス | ロボットの視覚認識、動作制御 | Boston Dynamics、NVIDIA Isaac |

ディープラーニングは、さまざまな分野で人間の作業を支援し、自動化を進めるための基盤技術として重要な役割を果たしています。

ディープラーニングを初学者でも学ぶ学習方法5選

ディープラーニングを学び始める初級者にとって、入門書やオンラインコースの利用は学習の第一歩となります。

これらのリソースは、基本的な理論から実際の実装テクニックまで、段階的に理解を深めていくことができるように設計されています。以下におすすめの学習方法をご紹介します。

1. Coursera

Couseraは、275以上の主要な大学や企業と連携し、世界中の個人や組織に取り組みやすい価格で仕事に関連したオンライン学習を提供しているサービスです。

実践的なプロジェクトコースはもちろん、就職に向けた証明書や学位プログラムを取得することも可能です。

例として、Cousera(ディープラーニングコース)を紹介します。

こちらのコースはディープラーニングの基礎を学べるコースとなっています。具体的には、ディープニューラルネットワークの構築と学習、パラメータの設定、CNNやRNNの構築や、タスクへの適用方法などを学習できます。

事前知識としては、Pythonの中級スキル(基本的なプログラミング、forループ、if/else文、データ構造の理解)と、線形代数とMLの基本的な理解が必要となっています。ま

た、英語で指導されていますが、日本語を含む22言語を利用することも可能です。

習得に必要な期間は、週に10時間で3ヶ月となっており、自分のペースで学習することが可能です。

また、こちらの講座を修了すると、特定のオンライン学位プログラムのうちいずれかを受ける権利が得られ、登録をすると大学の単位を取得できます。

7日間の無料トライアルを行っており、期間中は専門講座内のすべてのコースへ無制限のアクセスが可能です。トライアルが終了した場合は、月額費用を払うことで学習を継続することが可能です。

2. Fast.ai

Fast.aiは、プログラマー向けの無料コースやソフトウェアライブラリ、最先端の研究、コミュニティを通して、ディープラーニングを使いやすく、そしてより多くの人が参入できるようにしています。

例えばPractical Deep Learningというコースでは、全9回(各90分)の無料講座を通して、ディープラーニングモデルの構築と学習や、ランダムフォレストと回帰モデルの作成、PyTorch, fastai, Hugging Faceなどの人気ライブラリなどについて学習できます。

ある程度のコーディング経験があり、ディープラーニングと機械学習を実際のタスクに適用したい人向けの講座となっています。

3. TensorFlowやPyTorchなどの機械学習フレームワーク

それぞれチュートリアルが提供されていますので、これらを通して実践的に使い方を学ぶことが可能です。

TensorFlow チュートリアル

4. Preferred Networksが提供している「ディープラーニング入門:Chainer チュートリアル」

Pythonや微分、機械学習の基礎からディープラーニングに至るまでを幅広く学ぶことができます。

チュートリアルは日本語で書かれているので、今まで紹介したチュートリアルではハードルが高いと感じた方にもおすすめです。

5. 言語処理100本ノック2020(Rev2)

自然言語処理におけるPythonを使いこなせるようになりたい方に関しては言語処理100本ノック2020(Rev2)がおすすめです。

この100本ノックを全てこなせば、Pythonの基本的な記法からはじめ、文や単語の解析、機械学習、ディープラーニング、機械翻訳など、自然言語処理をするにあたっての基本的なコーディングスキルを身につけることができます。

解説記事もたくさん出ているので、初心者の方に特におすすめです。

ディープラーニングの課題と未来

さいごに、ディープラーニングの課題と未来について解説します。

実用化の課題

ディープラーニングの実用化には多くの課題が存在します。

大量のデータと計算リソースの必要性

ディープラーニングモデルは精度を高めるために膨大なトレーニングデータを必要とし、そのデータを処理するためには強力なハードウェア(GPUやTPUなど)が求められます。

これにより、データ収集やハードウェアのコストが高くなり、中小企業や研究機関にとって大きな障壁となります。

モデルの解釈性と透明性の欠如

ディープラーニングモデルは**「ブラックボックス」**として知られ、その内部の動作や決定プロセスが直感的に理解しにくいです。

この解釈性の欠如は、特に医療や金融などの高リスクな分野での導入を妨げる要因となります。研究者たちはモデルの可視化や説明可能なAI(Explainable AI)技術を用いてこの課題に取り組んでいますが、完全な解決には至っていません。

セキュリティとプライバシーの問題

ディープラーニングモデルはサイバー攻撃やデータ漏洩のリスクにも直面しています。攻撃者がモデルの脆弱性を悪用して誤った予測を引き起こす「対向的攻撃」や、トレーニングデータから個人情報を抽出する「プライバシー侵害」などが懸念されています。

これらのリスクを軽減するためには、モデルのセキュリティ強化やプライバシー保護技術の導入が不可欠です。

ディープラーニングの実用化にはこれらの課題を克服する必要がありますが、技術の進展とともにこれらの問題への対応も進んでおり、今後さらなる改善が期待されます。

まとめ

この記事ではディープラーニングについて、基本から応用、技術、課題と未来まで一通り解説しました。

ディープラーニングは、膨大なデータと計算リソースを必要とする一方で、その強力なパターン認識能力により、多くの分野で革新をもたらしています。画像認識や自然言語処理などの応用例を通じて、その実用性と可能性を感じていただけたのではないでしょうか。

AI総合研究所では企業のAI導入をサポートしています。

AIについてお悩みの担当者の方はお気軽にご相談ください。

この記事が、ディープラーニングの理解を深める一助となれば幸いです。