この記事のポイント

LSTMはRNNの問題点を解決し、長期的な依存関係を持つデータの処理に適している

忘却ゲート、インプットゲート、アウトプットゲートを用いて情報の流れを制御する

自然言語処理、音声認識、時系列予測など、幅広い分野で応用されている

PythonとTensorFlowを使用したLSTMの実装例を提供

Transformerなどの新技術が台頭する中でも、LSTMは依然として重要な役割を果たす

Microsoft MVP・AIパートナー。LinkX Japan株式会社 代表取締役。東京工業大学大学院にて自然言語処理・金融工学を研究。NHK放送技術研究所でAI・ブロックチェーンの研究開発に従事し、国際学会・ジャーナルでの発表多数。経営情報学会 優秀賞受賞。シンガポールでWeb3企業を創業後、現在は企業向けAI導入・DX推進を支援。

時系列データや言語処理など、シーケンシャルな情報を扱うのに適したニューラルネットワーク構造、LSTM(Long Short-Term Memory)の概念とその機能について詳しく解説します。

LSTMは、RNN(Recurrent Neural Network)が抱える、「短期的な依存関係に対する限界」を克服し、より長期間の文脈を捉えることが可能です。

この記事では、LSTMの基本的な動作原理から、Transformerなどの次に台頭した技術、現状まで網羅し、複雑なデータのパターンを学習するLSTMの仕組みと重要性を紹介します。

LSTMとは

LSTM(Long Short-Term Memory)は、RNN(Reccurent Neural Network)と同様ニューラルネットワークの一種で、特に時系列データの処理に適した構造を持っています。

ディープラーニングが流行る前からこの手法は存在しており、1997年に原著論文が発表されました。

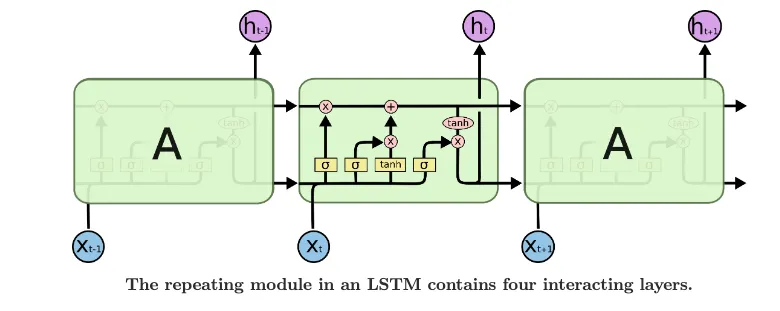

LSTMの仕組み

LSTM(Long Short-Term Memory)は、リカレントニューラルネットワーク(RNN)の一種で、特に長期間にわたる依存関係を持つデータの学習に適していることで知られています。

従来のRNNが直面していた勾配消失問題の解決策として導入されたLSTMは、「ゲート」と呼ばれる機構を用いて情報流の調節を行い、重要な情報を長期間保持し、不要な情報を「忘れる」ことができるように設計されています。

これにより、自然言語処理(NLP)や時系列データ予測といった分野で高い効果を発揮するようになりました。

LSTMの構造

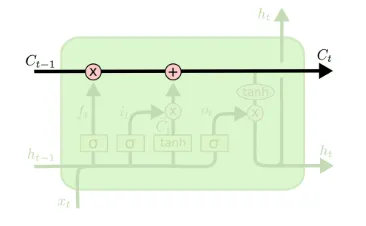

cell state

cell state (出典:Understanding LSTM Networks)

図の上部を通る黒い線をcell stateと言います。前の状態から、次の状態へと情報を伝える役割がありますが、LSTMはこのcell stateに対して情報を削除したり、追加したりすることができます。

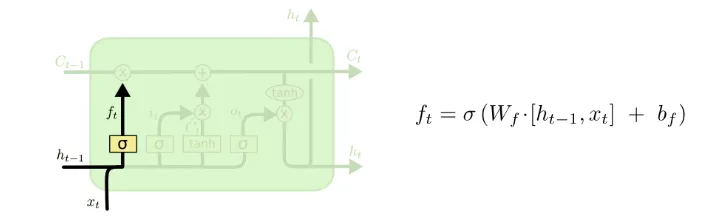

忘却ゲート

忘却ゲート(出典:Understanding LSTM Networks)

LSTMで一番初めに行うことは、cell stateからどの情報を削除するかを決めることです。現在の入力値である

0をかけると完全に情報を捨てることになり、1をかけると完全に情報を維持することになります。

具体的な式は以下です。

f_{t} = \sigma(W_{f}[h_{t-1}, x_{t}] + b_{f})

前のすべての単語に基づいて次の単語を予測しようとする言語モデルの例に戻ると、例えばcell stateには現在の主語の性別が含まれるかもしれません。

そこで、もし新しい主語が現れたら、さっきまでの性別を忘れて、新しい主語の性別を見ることになります。

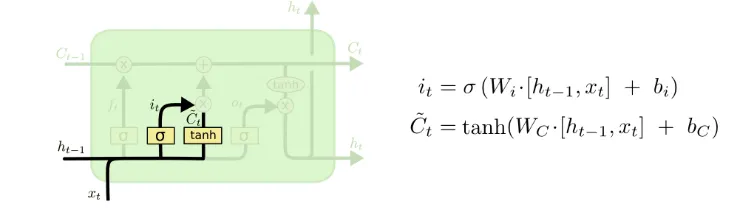

インプットゲート

インプットゲート (出典:Understanding LSTM Networks)

次に行うことは、どの新しい情報をcell stateに追加するかを決めることです。

まず、図のシグモイド層が、入力のうち、どの値を更新するかを決めます。

具体的な式は以下のようになります。

i_{t} = \sigma(W_{i}[h_{t-1}, x_{t}] + b_{i})

次に、tanh関数により、新しい値の候補を出力します。

\tilde{C_{t}} = tanh(W_{C}[h_{t-1}, x_{t}] + b_{C})

それぞれのイメージとしては、

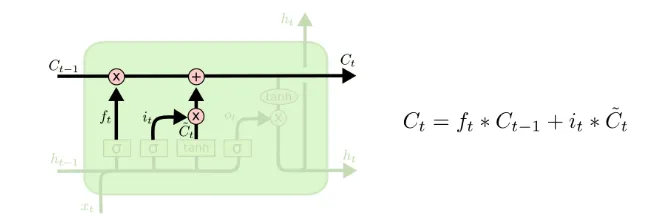

忘却ゲートとインプットゲート (出典:Understanding LSTM Networks)

忘却ゲートとインプットゲートをまとめると、まず忘却ゲートにより、前状態のcell stateからどの情報を捨て、どの情報を維持するかを決めます。

次にインプットゲートにより、新しい情報を付け加え、それを次の状態のcell stateの入力とします。

C_{t} = f_{t} \times C_{t-1} + i_{t} \times \tilde{C_{t}}

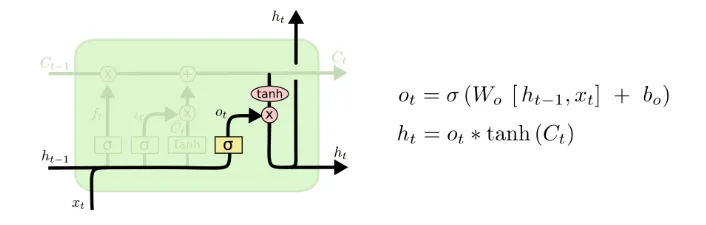

アウトプットゲート

アウトプットゲート (出典:Understanding LSTM Networks)

最後は現状態の出力です。まずはRNNと同様、入力と、前の出力を合わせたものをシグモイドのニューラルネットに入力し、その出力を

$$o_{t} = \sigma(W_{o}[h_{t-1}, x_{t}] + b_{o})

次に、先ほどの

h_{t} = o_{t} \times tanh(C_{t})

tanhの値域は-1から1であり、

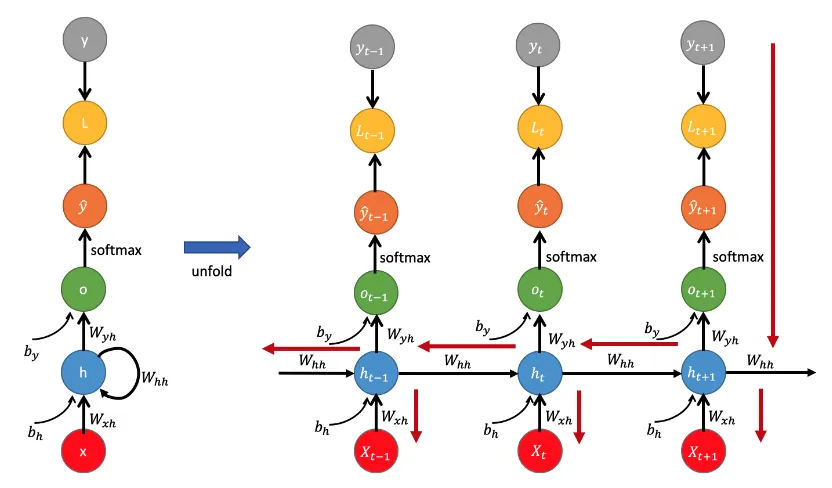

RNNの概要

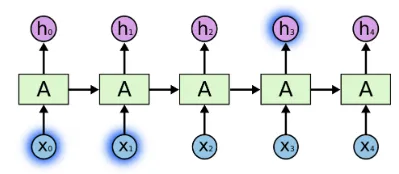

RNN(Recurrent Neural Network)は、シーケンスデータや時系列データなど、時間的な依存関係を持つデータを処理するのに適したニューラルネットワークの一種です。

RNNの特徴は、前のステップの出力が次のステップの入力になるという再帰的な構造です。これにより、RNNは直近の情報だけでなく、それ以前の情報も考慮に入れることができます。

つまり、RNNは過去の状態に基づいて次の状態を予測することができます。

RNNの構造は、各ステップでの入力データに対する重み行列と、前のステップの出力データに対する重み行列を持ちます。

これにより、RNNは時系列データの特徴やパターンを学習し、次のステップの出力を生成することができます。

RNNの仕組み

RNNの仕組み (参考:Backpropagation Through Time for Recurrent Neural Network)

現状態の入力を

h_{t} = tanh(W[h_{t-1}, X_{t}] + b_{h})

o_{t} = W_{yh}h_{t} + b_{y} \hat{y_{t}} = softmax(o_t)

のようになっています。

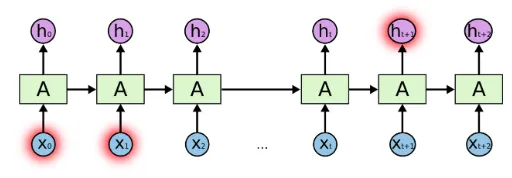

RNNの問題点

短い文章の場合 (出典:Understanding LSTM Networks)

例えば"Whales are in the 〇〇"という文章の"〇〇"を埋めようとする場合、直前の文脈だけ見ていれば、"ocean"や"sea"などと予測できます。しかし、より長い文脈が必要となる場合はどうでしょうか?

長い文章の場合 (出典:Understanding LSTM Networks)

"I grew up in Japan ... , and I speak fluent 〇〇."

このような文章の場合、直前の文脈だけをみると〇〇には何らかの言語が入ることがわかります。しかし、何の言語かを具体的に決めるにはずっと初めのJapanというワードを見なければなりません。

このように予測したい部分とそれに関連する情報との間のギャップが非常に大きいと、残念ながらRNNでは情報を伝達するのが難しくなります。

LSTMはそのようなRNNの問題を解決するような構造になっています。

LSTMの実装

以下は、PythonとTensorFlowを使用してLSTMを用いて時系列データの予測を行うプログラムの例です。この例では、単純なサイン波データを生成し、それを用いて次の時刻の値を予測します。

import numpy as np

import tensorflow as tf

import matplotlib.pyplot as plt

# サイン波データの生成

def generate_data(seq_length):

x = np.linspace(0, 10, seq_length+1)

y = np.sin(x)

return y[:-1], y[1:] # 入力データと出力データを返す

# データの準備

sequence_length = 20

input_data, target_data = generate_data(sequence_length)

# モデルの定義

inputs = tf.placeholder(tf.float32, [None, sequence_length, 1])

labels = tf.placeholder(tf.float32, [None, 1])

lstm_cell = tf.keras.layers.LSTMCell(64)

rnn_layer = tf.keras.layers.RNN(lstm_cell)

output = rnn_layer(inputs)

predictions = tf.keras.layers.Dense(1)(output)

loss = tf.reduce_mean(tf.square(predictions - labels))

optimizer = tf.train.AdamOptimizer(learning_rate=0.001)

train_op = optimizer.minimize(loss)

# 学習の実行

with tf.Session() as sess:

sess.run(tf.global_variables_initializer())

num_epochs = 1000

for epoch in range(num_epochs):

_, curr_loss = sess.run([train_op, loss], feed_dict={inputs: np.expand_dims(input_data, axis=-1),

labels: np.expand_dims(target_data, axis=-1)})

if epoch % 100 == 0:

print("Epoch: {}, Loss: {:.4f}".format(epoch, curr_loss))

# 予測の実行

predicted_values = sess.run(predictions, feed_dict={inputs: np.expand_dims(input_data, axis=-1)})

# グラフで表示

plt.plot(input_data, label='Input Data')

plt.plot(np.arange(1, len(input_data)+1), predicted_values, label='Predictions')

plt.legend()

plt.show()

LSTMの応用例

| 応用分野 | 説明 |

|---|---|

| 自然言語処理 | LSTMはテキスト生成、感情分析、機械翻訳、固有表現抽出などのタスクで広く使用されています。 |

| 音声認識 | LSTMモデルは音声パターンを認識し、音声信号をテキストに変換するために使用されています。 |

| 時系列予測 | LSTMは株価や天気予報などの時系列データで未来の値を予測するために使用されます。 |

| 手書き文字認識 | LSTMネットワークは手書きの文字を認識し、デジタルテキストに変換するために使用されます。 |

| 自動運転車 | LSTMは物体検出、経路計画、意思決定などのタスクにおいて自動運転車に使用されます。 |

| 健康モニタリング | LSTMは患者データの分析、異常の検出、医療状態の予測など、健康モニタリングシステムで使用されます。 |

| 予測保守 | LSTMはセンサーデータや過去のパターンに基づいて、設備の故障や保守の必要性を予測するために使用されます。 |

これらの応用例から分かるように、LSTMはさまざまな分野で幅広く活用され、データのパターンやトレンドの抽出、予測、分類などのタスクに貢献しています。

LSTMの次に台頭した技術

LSTMは今でも多くの領域で活発に使用されていますが、一部の分野では新たなアーキテクチャが台頭しています。特に自然言語処理の分野では、Transformerが主流となりつつあります。

Transformerは、Attention Mechanismに基づくモデルであり、BERTやGPTなどの事前学習モデルが、大規模なデータセットを用いて高度な自然言語理解を達成しています。

一方で、LSTMは時系列データの処理や一部のシーケンスタスクにおいて依然として重要な役割を果たしており、研究や実践の両面で活発な関心を持たれています。

LSTMとTransformerは、それぞれの長所を生かしながら、様々な分野で活用されています。

まとめ

本記事では、LSTMの基本概念から、RNNとの比較、ゲートを用いた情報制御の仕組み、Pythonでの実装例、さまざまな応用例まで、一連の流れを通してその特徴と重要性を理解することができました。

LSTMは、RNNの抱える長期依存関係の学習の問題を解決し、勾配消失や勾配爆発の問題を克服したニューラルネットワーク構造です。ゲート付きのメモリセルを用いて情報の流れを制御することで、重要な情報を保持しつつ不要な情報を忘れる能力を持ち、長期的な特徴パターンを学習することができます。

近年では、Transformerなどの新しいアーキテクチャが注目を集めていますが、LSTMは依然として時系列データの処理や一部のシーケンスタスクにおいて重要な役割を果たしており、研究や実践の両面で今でも広く使用されています。

今後も、LSTMの改良や応用に関する研究が進められており、さまざまな分野でのさらなる活用が期待されています。本記事がLSTMへの理解を深める一助となれば幸いです。