この記事のポイント

この記事は畳み込みニューラルネットワーク(CNN)について詳しく解説しています。

CNNは画像認識技術であり、画像の特徴を識別して物体を認識するAIであることが説明されています。

Microsoft MVP・AIパートナー。LinkX Japan株式会社 代表取締役。東京工業大学大学院にて自然言語処理・金融工学を研究。NHK放送技術研究所でAI・ブロックチェーンの研究開発に従事し、国際学会・ジャーナルでの発表多数。経営情報学会 優秀賞受賞。シンガポールでWeb3企業を創業後、現在は企業向けAI導入・DX推進を支援。

画像認識技術の分野で注目される「CNN」こと畳み込みニューラルネットワークについて、その基本原理から実用化されている例までを詳しく解説します。

画像中のどの部分が特徴的なのかを判別し、これが何であるかを識別するAIの仕組みの一つであるCNNは、自動運転車の開発から医療診断の補助など、私たちの生活を豊かにする多様な応用が進んでいます。

この記事を通じて、CNNのメカニズムや活用例を理解し、AI技術の時代の進展を感じ取っていただければと思います。

また、CNNの実装や導入の相談も承っておりますので、ぜひお気軽にお問い合わせください。

目次

CNNとは

CNN(畳み込みニューラルネットワーク)は、画像を見て「何が写っているか」を判断できるAIの仕組みです。例えば、写真を見て「これは猫だ!」とか「これは車だ!」と教えてくれるものです。

ニューラルネットワークとの違い

ニューラルネットワークと聞くと、漠然と「AIの基本的な仕組み」とイメージする方も多いでしょう。しかし、CNN(畳み込みニューラルネットワーク)は、一般的なニューラルネットワークと少し違った特性を持っています。その違いを知ることで、なぜCNNが画像認識に特化しているのかを理解できるようになります。

ニューラルネットワークとは?

普通のニューラルネットワークは、全ての情報をひとまとめにして考える仕組みです。例えば、画像を使う場合、写真のピクセルを1列に並べて計算します。

だから、「どこに耳があるか」や「目がどこにあるか」などの位置関係は考えません。

一方でCNNは、画像を理解するのに特化したニューラルネットワークです。

何が違うの?

- ニューラルネットワークは全体をひとまとめにして考えるので、計算が大変で、画像の構造(位置関係)を無視してしまいます。

- CNNは画像の特徴を効率よく見つける仕組みがあるので、画像や空間の情報を上手に活用できます。

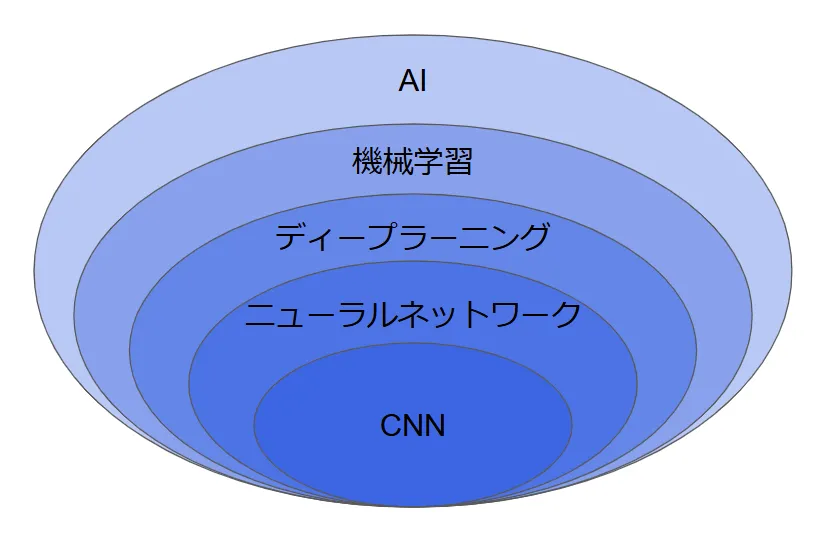

AIなどと比較すると以下のように示すことができます。

ニューラルネットワークの一般的な仕組みと比較することで、CNNがどのように特別なのか、その特性がクリアになりました。これを踏まえ、さらに深くCNNの魅力を掘り下げてみましょう。

画像認識におけるCNNの役割

画像認識におけるCNNの役割は、写真や画像を見て「何が写っているのか」を判断するAIの仕組みです。

どうやって画像を理解するの?

CNNは画像を「部分ごとに特徴を見つけて、全体を判断する」役割を果たします。以下の3つのステップで動きます。

- 特徴を見つける(どんな模様があるか探す)

- まず、画像を小さなエリアに分けて、「線」「丸い形」「角」などの特徴を探します。

- 例えば、猫の耳の三角形や犬の目の丸い形を見つけるイメージです。

- 特徴を組み合わせる(全体像をつかむ)

- 見つけた小さな特徴を組み合わせて、「この形は猫の顔っぽい」とか「これは車のボディだな」と判断します。

- 最終的な答えを出す

- 「これは猫!」「これは車!」と答えを出します。

CNNの力は、画像認識の精度を飛躍的に高め、人間の視覚を補完する新たな道を切り開いています。この技術が日常生活でどのように活かされているのか、さらに探ってみましょう。

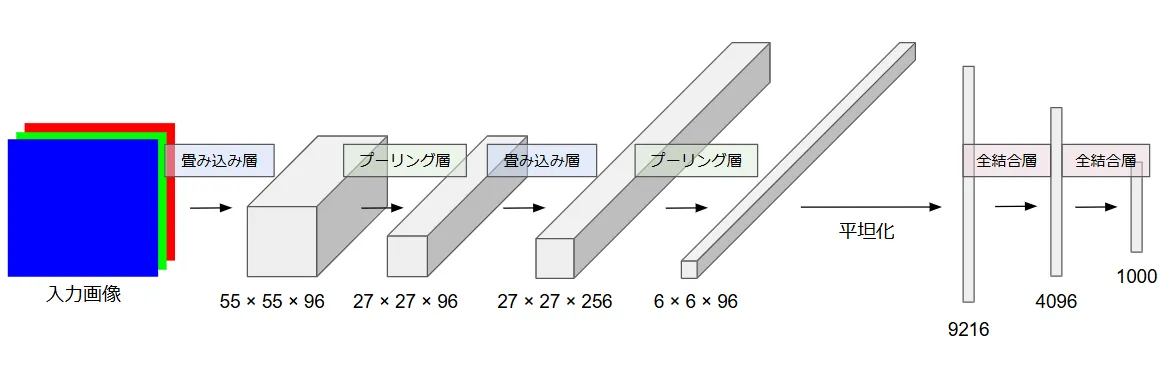

CNNの構造

CNNは複数の層が重なり合って構成される深層学習モデルです。主に畳み込み層、プーリング層、全結合層から成り、それぞれが異なる役割を持っています。

畳み込み層(Convolutional Layer)

畳み込み層は、CNNの中で画像やデータから特徴を抽出する役割を担っています。具体的には、画像を小さな「フィルタ(カーネル)」を使ってスキャンし、特徴を見つけます。

| 要素 | 説明 |

|---|---|

| 役割 | 画像から特徴を抽出 |

| 処理内容 | フィルタによる畳み込み演算 |

| パラメータ | ・フィルタサイズ ・ストライド ・パディング |

| 出力 | 特徴マップ |

フィルタとは

これは、小さなマトリックス(例えば3×3や5×5のサイズ)です。画像全体をスライドしながら、このフィルタを適用します。フィルタは、特定の特徴(例えば「エッジ」や「模様」)を見つけるために学習されます。

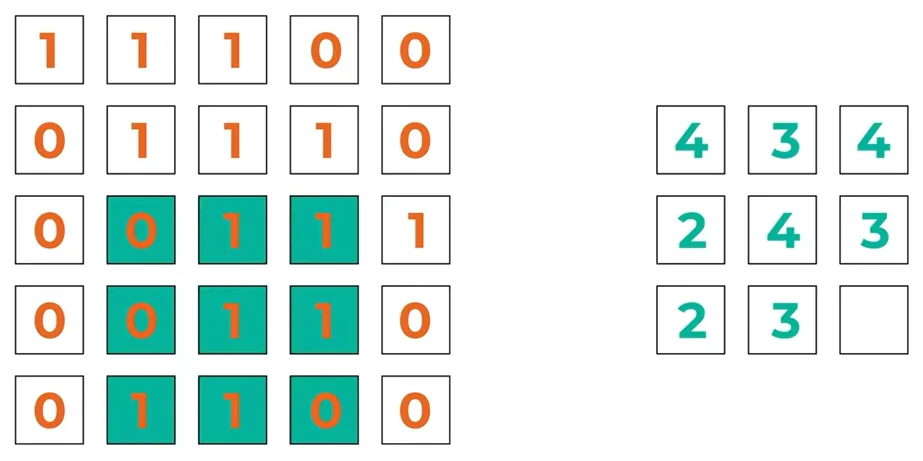

畳み込み演算とは

フィルタを画像にスライドさせ、画像のピクセルの値とフィルタの値を掛け合わせ、その合計を求めます。この演算を画像全体に適用し、新しい特徴マップ(Feature Map)を作ります。

畳み込み層は、画像から重要な特徴を抜き出す土台です。この層があるおかげで、CNNは複雑なパターンを認識できるのです。

プーリング層(Pooling Layer)

プーリング層は、画像のサイズを縮小して計算を効率化するとともに、重要な特徴を保持するために使われます。プーリングは、畳み込み層で抽出した特徴を圧縮して、データの次元(サイズ)を削減します。

| 処理タイプ | 特徴 |

|---|---|

| Max Pooling | 領域内の最大値を選択 |

| Average Pooling | 領域内の平均値を計算 |

| Global Pooling | 特徴マップ全体を集約 |

最大プーリング(Max Pooling)

最も一般的な方法です。画像を小さな領域(例えば2×2)に分けて、その領域内で最大値を取ります。これにより、重要な情報を残しつつ、データを圧縮します。

平均プーリング(Average Pooling)

領域内の平均値を取ります。最大プーリングよりも情報が滑らかに保たれることがあります。

例えば以下は範囲内の合計を集約するプーリングとなっており、緑の領域内の合計値/2の値が右に記載されていますね。

このような操作をプーリングといいます。

引用元:Packt Youtube

プーリング層のおかげで、CNNは無駄を省きつつ重要な情報を保持できます。この効率性が、モデルの実用性を大きく高めているのです。

全結合層(Fully Connected Layer)

全結合層は、画像の特徴を最終的な結果に変換する役割を持っています。畳み込み層やプーリング層で抽出された特徴を使って、「これは猫だ」「これは犬だ」といった最終的な判断を下す層です。

どうやって働くのか?

- 特徴を一つのベクトルに変換:

畳み込み層とプーリング層で得られた特徴を平らに(1次元のベクトル)し、次にそれを全結合層に入力します。この層は、全ての特徴を結びつけて、最終的な判断を行います。

- ニューロン間の接続:

全結合層では、全てのニューロン(ユニット)が次の層の全てのニューロンと接続されています。つまり、入力された特徴が全てのニューロンに伝達され、それぞれのニューロンが重要度を学習します。

全結合層は、CNNの最終的なアウトプットを形作る重要な部分です。この層のおかげで、モデルは「この画像は何か」という答えを出せるのです。

CNNの学習

学習データ

CNNが学習するためには「データ」が必要不可欠です。このデータが、モデルに知識を与え、成長させる原動力となります。質の高いデータが用意されていれば、モデルのパフォーマンスも飛躍的に向上します。

- 訓練データ(Training Data): モデルの学習に使用されるデータ。

- 検証データ(Validation Data): モデルのハイパーパラメータ調整や過学習の検出に使用されるデータ。

- テストデータ(Test Data): 最終的なモデルの評価に使用されるデータ。

活性化関数

活性化関数は、CNNの中で「ニューロン」を活性化させるスイッチのようなものです。このスイッチが、モデルに複雑なパターンを学習する力を与えています。主な活性化関数は以下の通りです。

| 活性化関数 | 数式 | 特徴 |

|---|---|---|

| シグモイド関数 | $ \sigma(x) = \frac{1}{1 + e^{-x}} $ | 出力値が0から1の範囲。勾配消失問題を起こしやすい。 |

| ハイパボリックタンジェント | $ \tanh(x) = \frac{\exp(x) - \exp(-x)}{\exp(x) + \exp(-x)} $ | 出力値が-1から1の範囲。シグモイドより中心が0に近い。 |

| ReLU | $ \text{ReLU}(x) = \max(0, x) $ | 負の入力を0、正の入力をそのまま出力。計算が高速で、勾配消失を軽減。ただし、死んだニューロン問題が発生する可能性がある。 |

損失関数

損失関数は、モデルが間違った場合に「どれだけ間違えたか」を教えてくれる指標です。いわば、モデルに対する教師のような存在で、「ここが間違いだよ」とフィードバックを与えます。

| 損失関数 | 数式 | 適用例 |

|---|---|---|

| 平均二乗誤差 (MSE) | $ MSE = \frac{1}{n} \sum_{i=1}^n (y_i - \hat{y}_i)^2 $ | 回帰問題でよく使用される。 |

| クロスエントロピー誤差 | $ CE = -\sum y \log(\hat{y}) $ | 分類問題で広く使用される。 |

最適化アルゴリズム

最適化アルゴリズムは、モデルが効率よく学習するための道具箱のようなものです。損失を減らすために重みやバイアスを調整し、モデルをより良い状態へ導きます。代表的なアルゴリズムは以下の通りです。

| アルゴリズム | 特徴 |

|---|---|

| 確率的勾配降下法 (SGD) | シンプルで計算効率が良いが、局所最適解に陥る可能性がある。 |

| Adam | SGDを改良し、学習率の調整を自動化。高速かつ安定した収束を実現。 |

過学習

過学習とは、モデルが訓練データにこだわりすぎて、まるで「教科書を暗記しているだけ」の状態になることです。この状態では、未知のデータに対してうまく対応できなくなります。過学習を防ぐための手法として以下が挙げられます。

- ドロップアウト:学習時にランダムに一部のニューロンを無効化し、モデルの汎化性能を向上させます。

- 正則化:損失関数にペナルティ項を追加し、モデルの複雑さを抑制します。

- L1正則化: 重みの絶対値の和をペナルティとする。

- L2正則化: 重みの二乗和をペナルティとする。

これらの要素を適切に組み合わせることで、CNNの学習が効果的に行われます。

CNNの実装

では実際に自分でCNNを体験してみましょう。

模擬コード

以下の模擬コードを実行してみます。

import tensorflow as tf

import matplotlib.pyplot as plt

import numpy as np

from tensorflow.keras import layers, models, Model

# 1. MNISTデータセットのロードと前処理

(train_images, train_labels), (test_images, test_labels) = tf.keras.datasets.mnist.load_data()

# データの前処理(画像を28x28x1にリシェイプし、正規化)

train_images = train_images.reshape((train_images.shape[0], 28, 28, 1)).astype('float32') / 255

test_images = test_images.reshape((test_images.shape[0], 28, 28, 1)).astype('float32') / 255

# 2. CNNモデルの定義(Functional APIを使用)

input_img = layers.Input(shape=(28, 28, 1))

# 畳み込み層1

x = layers.Conv2D(8, (3, 3), activation='relu', name='conv1')(input_img)

x = layers.MaxPooling2D((2, 2), name='pool1')(x)

# 畳み込み層2

x = layers.Conv2D(16, (3, 3), activation='relu', name='conv2')(x)

x = layers.MaxPooling2D((2, 2), name='pool2')(x)

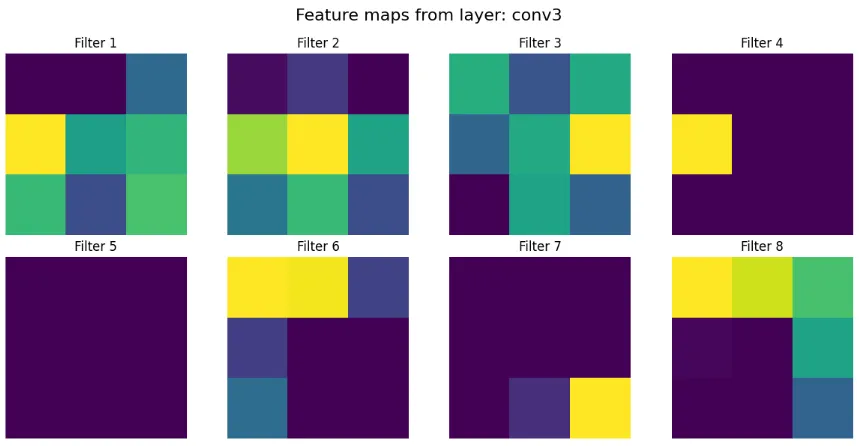

# 畳み込み層3

x = layers.Conv2D(32, (3, 3), activation='relu', name='conv3')(x)

# 平坦化と全結合層

x = layers.Flatten(name='flatten')(x)

x = layers.Dense(64, activation='relu', name='dense1')(x)

output = layers.Dense(10, activation='softmax', name='output')(x)

# モデルの作成

model = Model(inputs=input_img, outputs=output)

# モデルのコンパイル

model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

# モデルの訓練(1エポック)

history = model.fit(train_images, train_labels, epochs=1, batch_size=64, validation_split=0.1)

# モデルの概要を表示

model.summary()

# 3. 中間層の出力を取得するためのモデルの定義

# 特徴マップを取得したい層をリストに追加

layer_names = ['conv1', 'conv2', 'conv3']

layer_outputs = [model.get_layer(name).output for name in layer_names]

# 中間層の出力を取得するモデル

activation_model = Model(inputs=model.input, outputs=layer_outputs)

# 4. 特徴マップを取得するために予測を実行

# 例として最初のテスト画像を使用

img = test_images[0].reshape(1, 28, 28, 1)

activations = activation_model.predict(img)

# 5. 特徴マップの可視化

for layer_name, layer_activation in zip(layer_names, activations):

num_filters = layer_activation.shape[-1]

size = layer_activation.shape[1]

# フィルタ数を表示する数に制限

num_display = min(8, num_filters)

# プロットの設定

fig, axes = plt.subplots(2, 4, figsize=(12, 6))

fig.suptitle(f'Feature maps from layer: {layer_name}', fontsize=16)

for i in range(num_display):

row = i // 4

col = i % 4

ax = axes[row, col]

ax.imshow(layer_activation[0, :, :, i], cmap='viridis')

ax.axis('off')

ax.set_title(f'Filter {i+1}')

# 残りのサブプロットを削除

for i in range(num_display, 8):

fig.delaxes(axes.flatten()[i])

plt.tight_layout()

plt.subplots_adjust(top=0.88) # タイトルの位置調整

plt.show()

# 画像として保存(オプション)

fig.savefig(f'feature_maps_{layer_name}.png')

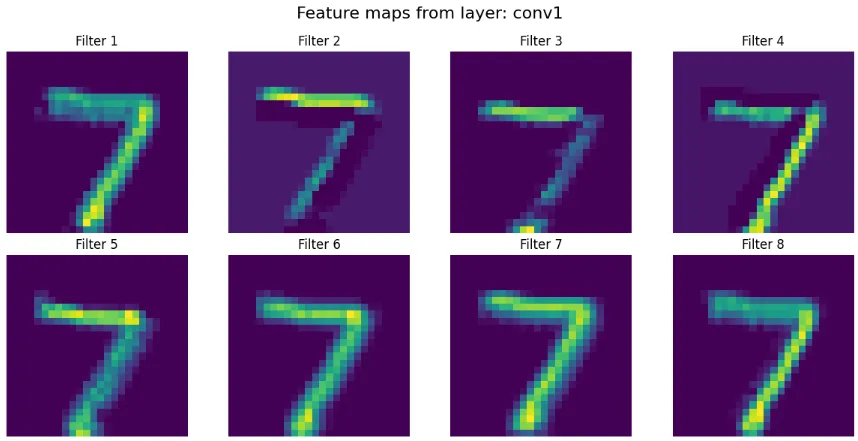

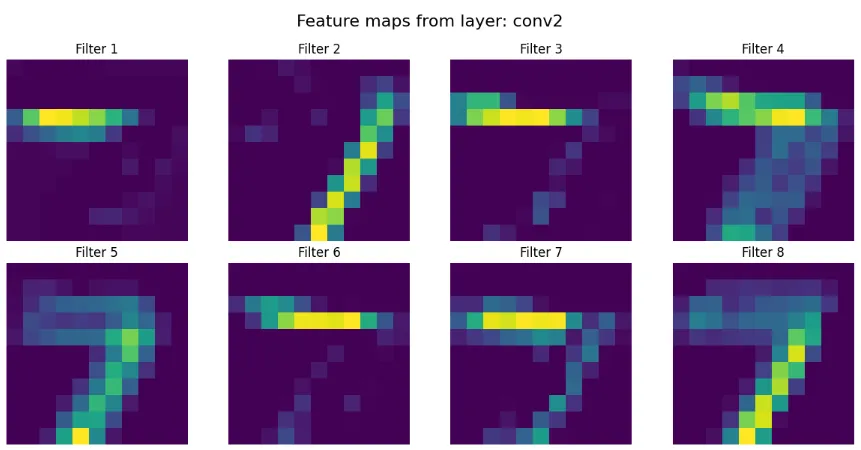

実行結果

実行するとCNNの過程が明らかですね!

実行過程の画像

CNNの活用例

深層学習の中でもCNNは特に画像処理分野で幅広く活用されています。産業から研究まで、様々な分野で実用化が進んでいます。

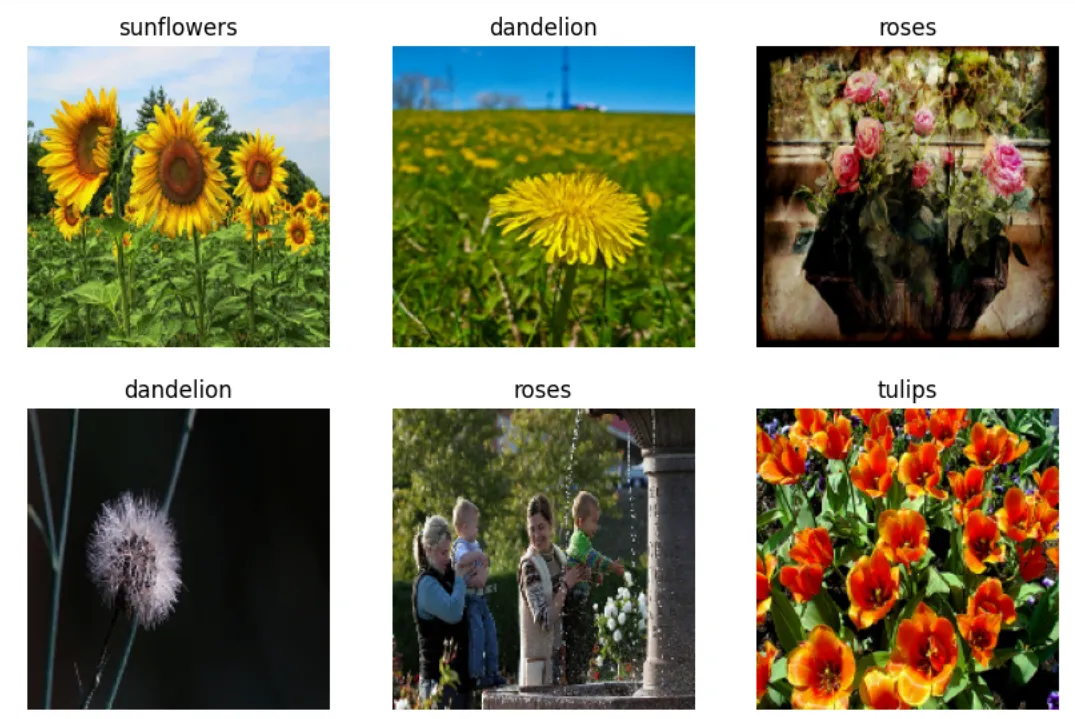

画像認識

「この画像には何が写っているのか?」そんな問いに答えるのが画像認識技術の役割です。そして、その中核を担っているのがCNNです。

| 適用分野 | 具体例 | 特徴 |

|---|---|---|

| SNS | 顔認識タグ付け | ・リアルタイム処理 ・高精度な認識 |

| セキュリティ | 監視カメラ解析 | ・24時間監視 ・異常検知 |

| コンテンツ管理 | 画像分類 | ・自動タグ付け ・検索効率化 |

Googleの例

引用元:Tensorflow

Googleは、画像認識や物体検出に深層学習(CNNを含む)技術を活用しているとされています。特にGoogle Photosの自動タグ付けや検索機能では、CNNが使われていると考えられます。Googleの深層学習ライブラリ「TensorFlow」は、CNNを効率的に実装できるプラットフォームとして広く使用されています。

引用元:Tensflow core

【関連記事】

Tensflowを使った開発についてはこちらの記事を参考に!

→ AI開発におすすめのプログラミング言語5選!フレームワークも紹介

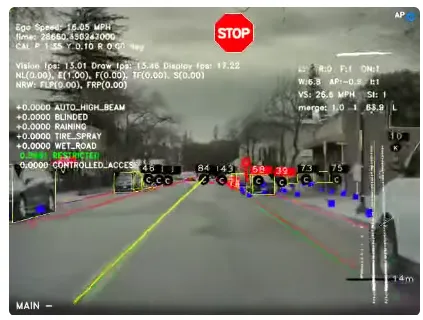

物体検出

自動運転や監視システムでの活用例:

- 歩行者の検出

- 車両の認識

- 障害物の検知

teslaの例

Teslaの自動運転技術(Autopilot)では、CNNを用いた画像処理が使われていると多くの専門家が指摘しています。特に、カメラによる物体認識(歩行者や他の車両、標識など)にはCNNが使われていると予想されています。

引用元:Tesla

画像分類

産業での実用例:

- 製品の品質管理

- 不良品の自動検出

- 商品の自動仕分け

Boschの例

Boschは、製造ラインでの品質管理にAIと画像認識技術を活用しており、不良品を自動で検出するシステムを提供しています。特に、画像解析を行うためにCNNを使用し、部品の形状や表面の欠陥をリアルタイムでチェックします。

引用元:Bosch

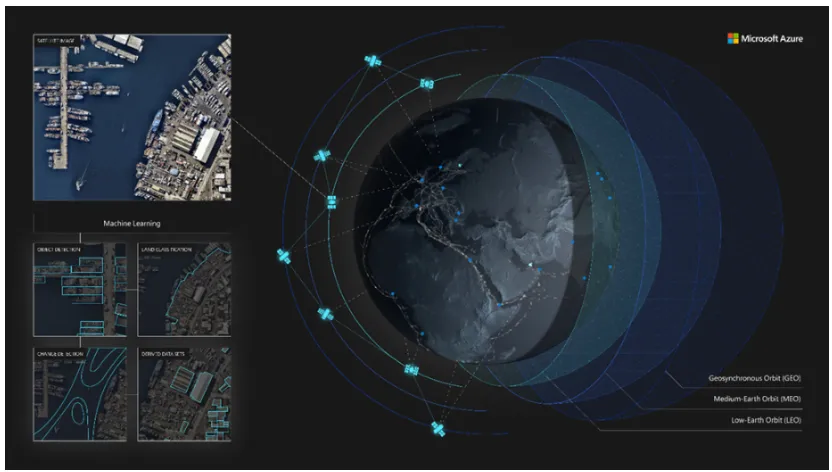

セグメンテーション

医療分野での活用:

- 臓器の領域分割

- 病変部の特定

- 手術支援システム

Microsoftの例

Microsoftは、CNNを活用して衛星画像や航空写真から地物(建物、道路、河川など)をセグメント化する技術を提供しています。この技術は、農業や都市計画、災害対応などの分野で活用されています。Microsoft AzureのAIツールは、セグメンテーション技術を使って地理情報の解析を効率化しています。

引用元:Microsoft

顔認識

| 用途 | 具体例 |

|---|---|

| 認証 | ・スマートフォンのロック解除 ・入退室管理 |

| マーケティング | ・顧客分析 ・行動追跡 |

| エンターテイメント | ・フィルター効果 ・アバター生成 |

Amazon Web Servicesの例

AWS Rekognitionは、CNNを使用した顔認識技術を提供するクラウドサービスで、顔の検出や分析、顔同士の一致の確認を行います。企業はこのサービスを活用して、監視カメラ映像から顔を認識したり、ユーザーの顔情報を基にパーソナライズされたサービスを提供したりします。

引用元:AWS

医療画像診断

| 診断分野 | 応用例 |

|---|---|

| X線検査 | 骨折検出、肺炎診断 |

| MRI | 腫瘍検出、脳疾患診断 |

| 内視鏡 | 病変部位の特定 |

Philips Healthcareの例

Philips Healthcareは、CNNを利用した医療画像診断ソリューションを提供しています。特に、CTスキャン、MRI、X線画像における病変検出や診断支援を行っています。PhilipsのAI技術は、がんや脳卒中などの早期発見をサポートし、医師の診断精度を向上させることができます。

引用元:Philips

CNNの発展と未来

CNNは1990年代から現在に至るまで、急速な進化を遂げています。技術の発展と共に、より高度な画像認識や新たな応用分野が開拓され続けています。

最新のCNNモデル

CNNの進化はとどまるところを知りません。ResNetやEfficientNetなど、これまで登場してきたモデルは、それぞれ独自の特長を持ち、さまざまな課題を解決してきました。最新のモデルは、さらに精度を高めつつ計算コストを抑えることを目指しています。この章では、最新のCNNモデルがどのように私たちの期待に応えているのかを見ていきましょう。

EfficientNet

EfficientNetは、Googleが開発したCNNモデルで、最適化されたアーキテクチャとスケーリング手法(例えば、入力画像サイズの調整やネットワークの深さ、幅、解像度を調整)を組み合わせて、非常に効率的に高精度を達成します。EfficientNetは、計算資源を抑えながらも高精度な結果を出すことができるため、特に制限のある環境(モバイルデバイスなど)での利用が注目されています。

【関連記事】

公式ページはこちら

ResNet (Residual Networks)

ResNetは、非常に深いニューラルネットワークでも学習が安定するように設計されたCNNアーキテクチャです。残差接続(Residual connections)を使用することで、深いネットワークでも勾配消失問題を回避し、より高精度な学習が可能になります。ResNetは、非常に深い層(100層以上)を持つモデルであり、大規模データセットで優れたパフォーマンスを発揮します。

【関連記事】

公式ページはこちら

YOLO (You Only Look Once) v5

YOLOは、物体検出において非常に高速で精度の高いモデルとして広く知られています。YOLOv5は、YOLOシリーズの最新のバージョンで、物体検出の精度を大幅に向上させています。YOLOv5は、トレーニングの簡便さ、軽量さ、リアルタイム性能を持ち合わせており、特に自動運転や監視システムで広く使用されています。

【関連記事】

公式ページはこちら

CNNの展望

技術が進化するにつれ、CNNにも新しい可能性が見え始めています。計算効率の向上や軽量化に加え、他のモデルとのハイブリッドな活用が進むことで、これまで以上に実世界での応用が期待されています。将来的にはどのような形でCNNが活躍しているのか、その未来を想像してみましょう。

ハードウェアの進化による性能向上

ムーアの法則に基づき、半導体技術は2030年までにさらなる微細化と高性能化が進むと予測されています。これにより、CNNの処理速度や効率が大幅に向上し、より複雑なモデルのリアルタイム処理が可能になるでしょう。

【関連記事】

ハードウェアについてはこちらの記事をどうぞ!

→生成AI向けPC22選!用途別のおすすめパソコン・選び方を徹底解説

エッジデバイスでの高度なAI処理

通信技術の進化とエネルギー効率の向上により、エッジデバイス上での高度なAI処理が現実のものとなります。これにより、リアルタイムな画像認識や異常検知が可能となり、産業や医療など多様な分野での応用が期待されます。

【関連記事】

エッジAIについてはこちらの記事をどうぞ!

→エッジAIとは?その概要や活用事例、クラウドAIとの違いを徹底解説!

自律型AIエージェントの普及

エージェント型AIは、ユーザーの特定の目標を達成するために独立して意思決定を行い、行動を起こすソフトウェアプログラムです。これらのプログラムは、メモリ、計画、環境の感知、ツールの使用、安全ガイドラインの遵守といった機能を備え、さまざまなAI技術を組み合わせて自律的に目標達成のためのタスクを遂行します。2028年までに、日常業務における意思決定の少なくとも15%がエージェントAIによって自律的に行われるようになり、2024年の0%から増加する見込みです。

【関連記事】

AIエージェントについてはこちらの記事をどうぞ!

→AIエージェントとは?その仕組みや作り方、活用事例を徹底解説

新たなデバイス技術の登場

スピントロニクスや量子デバイスなど、次世代のデバイス技術が開発中であり、これらが実用化されることで、CNNの性能や応用範囲が飛躍的に拡大する可能性があります。

これらの進展により、2030年にはCNNがより多くの分野で活用され、私たちの生活や産業に大きな影響を与えることが期待されています。

まとめ

畳み込みニューラルネットワーク(CNN)は、私たちの目の代わりとして、画像や映像の中から意味を見つけ出す技術です。一般的なニューラルネットワークと異なり、画像の形や模様、色の違いを読み取り、それを基に判断を下せるような特別な仕組みを持っています。この技術が登場したことで、AIが本当に「見る」ことができるようになったと言っても過言ではありません。

このようなCNNの進化は、単なる技術革新ではなく、私たちの日常生活や産業を大きく変える力を持っています。例えば、医療分野では、これまで熟練の医師しか発見できなかった病気の兆候をAIが補助することで、より多くの命を救えるようになりました。自動運転車では、CNNが道路上の状況を理解し、安全な運転をサポートしています。こうした応用例を見ると、CNNはもはや「未来の技術」ではなく、「今の私たちの生活を支える技術」となっているのだと実感します。

CNNの活用、画像処理の実装はお気軽に弊社にご相談ください。導入の構想段階から、AI開発まで一気通貫で支援いたします。

本記事が皆様のご参考になれば幸いです。