この記事のポイント

この記事は機械学習の手法の一つであるランダムフォレストについて詳しく解説しています。

ランダムフォレストは、多くの決定木を組み合わせて予測精度を高めるアンサンブル学習の手法です。

Microsoft MVP・AIパートナー。LinkX Japan株式会社 代表取締役。東京工業大学大学院にて自然言語処理・金融工学を研究。NHK放送技術研究所でAI・ブロックチェーンの研究開発に従事し、国際学会・ジャーナルでの発表多数。経営情報学会 優秀賞受賞。シンガポールでWeb3企業を創業後、現在は企業向けAI導入・DX推進を支援。

機械学習アルゴリズムの一つである「ランダムフォレスト」は、多くの決定木を組み合わせることによって、単一の決定木では達成できない高い予測精度と汎用性を持つアンサンブル学習手法です。

本記事では、ランダムフォレストの基本的な仕組みや特徴、活用事例を詳しく解説します。過学習を抑えるためのバギング手法や、特徴量の重要度を計算しモデルの解釈を可能にする側面など、ビジネスから科学研究まで、幅広い領域で利用されるその魅力に迫ります。

また、実務でのアルゴリズムの適用に際して必要となるハイパーパラメータのチューニングやモデルの評価方法、さらに複雑な問題への応用例についても議論を深めていきます。

データ分析に新たにチャレンジしたい方、専門知識をさらに深めたい方にとって、ランダムフォレストの概要から実践的な利用方法までを学べる内容となっています。

目次

ランダムフォレストとは

機械学習アルゴリズムの中でも高い汎用性と精度を誇るランダムフォレストは、ビジネスにおける予測モデルの構築から、科学研究における分析まで、幅広い分野で活用されています。複数の決定木を組み合わせることで、単一の決定木よりも高精度な予測を実現する手法です。特に近年のビッグデータ時代において、その性能と使いやすさから、多くのデータサイエンティストから支持されています。

ランダムフォレストの手法と位置付け

ランダムフォレストのイメージ

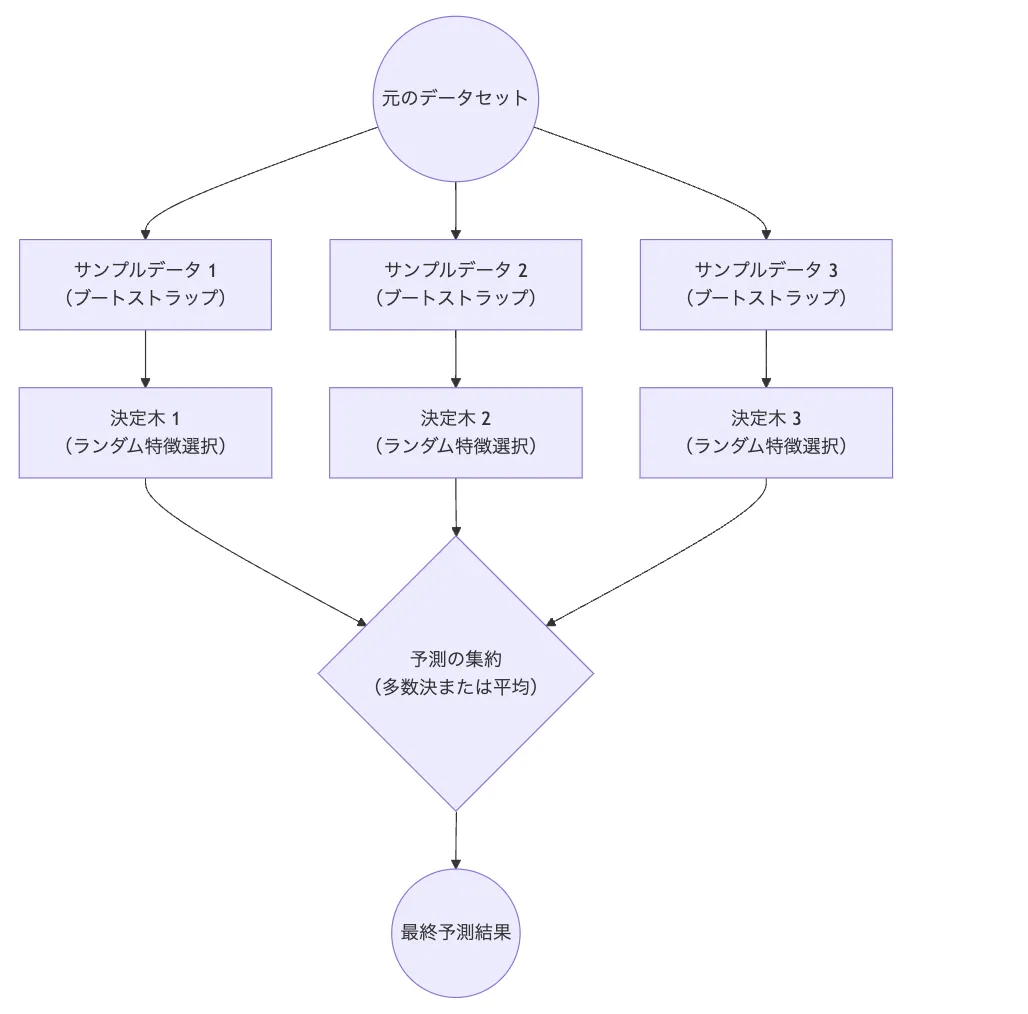

ランダムフォレストは、複数の決定木を組み合わせたアンサンブル学習手法の一つです。決定木という直感的に理解しやすいアルゴリズムをベースとしながら、アンサンブル学習の力を活用することで、高い予測精度と汎用性を実現しています。

特に注目すべきは、単一の決定木が持つ過学習の傾向や、特定のデータへの過度な適合という弱点を、複数の木を組み合わせることで効果的に克服している点です。また、並列処理との相性が良く、大規模データの処理にも適しているため、現代のビッグデータ分析においても重要な役割を果たしています。

機械学習における位置づけ

| 分類 | 特徴 | 主な用途 | 代表的な実装 |

|---|---|---|---|

| 教師あり学習 | 分類・回帰両対応 | 予測モデル構築 | scikit-learn |

| アンサンブル学習 | 複数モデルの統合 | 精度向上 | RandomForestClassifier |

| バギング手法 | ランダムサンプリング | 過学習抑制 | RandomForestRegressor |

ランダムフォレストの仕組み

決定木をベースとしながら、「ランダム性」を導入することで、予測精度を向上させるのがランダムフォレストの特徴です。この手法は、個々の決定木の予測能力を活かしながら、集団としての安定性と精度を実現する巧妙な設計となっています。

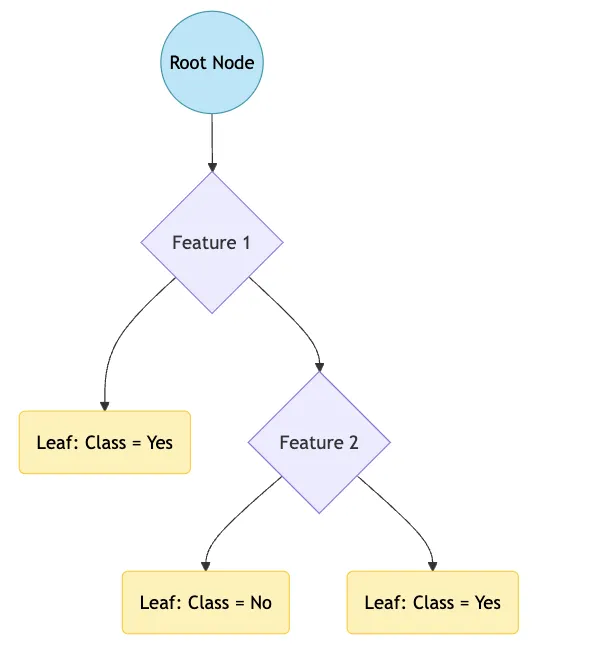

決定木とは

決定木は木の形状をしたモデルでノードと葉から構成されます。

決定木イメージ

ノード(青色): 特微量に基づいてデータを分割するポイント。根ノード(最上部)から始まり、内部ノードを経て葉ノードに至ります。

葉ノード(黄色): 最終的な予測結果を示すノード。分類問題ではクラスレベル、回帰問題では数値を表します。

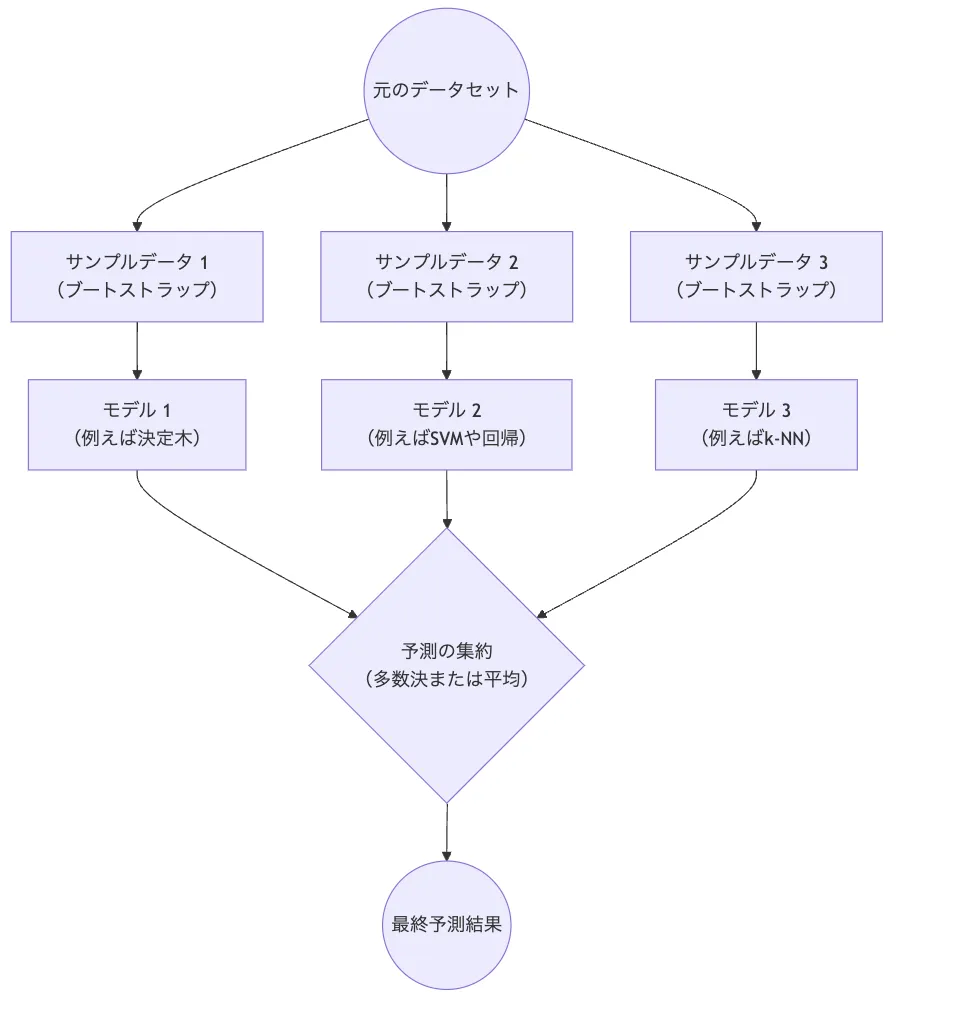

アンサンブル学習とは

アンサンブル学習イメージ

アンサンブル学習は複数の学習アルゴリズムやモデルを組み合わせてより高い予測精度を実現する手法です。複数の弱い学習器を組み合わせることで、全体として強い学習器を形成します。これにより個々のモデルの誤差を相殺し精度を向上させることができます。

- バギングとは

バギングは同じモデルを複数回訓練し、それらの予測を平均または多数決で集約する手法です。これにより、全体の予測精度を向上させることができます。

基本的な学習プロセスは以下の通りです:

-

データのランダム性(バギング)による多様性の確保

- 学習データからのブートストラップサンプリング

- 各決定木で異なるデータセットを使用

- サンプリングによる予測の分散低減

-

特徴量のランダム性による過学習の抑制

- 分岐時に特徴量をランダムに選択

- 決定木間の相関を低減

- モデルの汎化性能を向上

ランダムフォレストの特徴

ランダムフォレストは、その設計思想と実装の工夫により、実務での活用において多くの利点を備えています。特に、高い予測精度と実用性のバランスが取れている点は、多くの実務家から高く評価されている理由の一つです。

性能面での特徴を詳しく見ていきましょう。

| 分類 | 具体的な特徴 | 利点 |

|---|---|---|

| 性能面での特徴 | ||

| 予測精度の高さ | - バギング(分散削減) - 特徴量選択による過学習抑制 - アンサンブル学習による安定化 - 外れ値に対する頑健性 |

安定した高精度な予測が可能。 単一モデルよりも汎化性能が向上。 |

| 汎用性 | - 分類問題と回帰問題の両方に対応 - 大規模データや高次元データでも高い性能 |

多様な応用分野で使用可能。 どのようなデータセットにも柔軟に対応。 |

| 頑健性 | - 外れ値やノイズに強い - 欠損値があっても動作可能 |

データ前処理の負担を軽減。 実務データに特有の課題に対応しやすい。 |

| 実務での活用しやすさ | ||

| 前処理の簡便さ | - データの正規化が不要 - 外れ値の処理が最小限 - 欠損値の許容 |

時間を節約でき、実務データの準備が容易。 |

| チューニングの容易さ | - 主なパラメータが少ない(木の本数n_estimators、特徴量数max_features)- 過学習しにくい設計 |

少ない労力で最適化可能。 グリッドサーチやランダムサーチで効率的に最適化できる。 |

| 解釈のしやすさ | - 特徴量重要度の計算 - 部分依存プロット(PDP)で特徴量の影響を可視化 - 決定木構造の追跡が可能 |

モデルの動作を説明しやすい。 特徴量の影響を具体的に把握可能。 |

- 性能面では、ランダムフォレストは「バギング」や「ランダム特徴量選択」によって過学習を抑え、安定した高精度の予測を実現します。また、外れ値やノイズに対する頑健性が高いため、現実世界のデータでも安心して使用できます。

- 実務での活用しやすさにおいては、データの前処理がほとんど不要で、主要なパラメータが少なく、モデルの解釈性もあるため、実務家にとって非常に扱いやすいアルゴリズムです。

ランダムフォレストの特徴(数式)

| 分類 | 数式 | 特徴 |

|---|---|---|

| ブートストラップ | ( D_k \sim \text{Bootstrap Sampling from } D ) | データの多様性を確保。 |

| 分割基準(Gini不純度) | ( G(t) = \sum_{k=1}^K p_k (1 - p_k) ) | 分割条件を最適化して、不純度が最小になる分割を選択。 |

| ランダム特徴量選択 | ( m = \sqrt{M} ) | 過学習を防ぎ、各決定木の独立性を高める。 |

| アンサンブル学習 | - 分類: ( \hat{y} = \text{argmax}k \sum{i=1}^T \mathbb{1}(h_i(x) = k) ) - 回帰: ( \hat{y} = \frac{1}{T} \sum_{i=1}^T h_i(x) ) |

複数モデルの結果を統合することで安定した予測を実現。 |

ランダムフォレストのアルゴリズム

ランダムフォレストのアルゴリズムは、その名の通り「森」を作るように、複数の決定木を組み合わせて構築されます。各決定木はそれぞれ異なるデータセットと特徴量で学習することで、多様性のある予測モデルを実現します。ここでは、その具体的な仕組みと実装方法について解説します。

決定木の構築

決定木の構築プロセスは、ランダムフォレストの性能を決定する重要な要素です。各決定木は以下のステップで構築されます。

構築プロセスの詳細:

-

データのサンプリング

- ブートストラップサンプリングによるデータ選択

- 元のデータセットと同じサイズのサンプルを作成

- 重複を許容したランダムな抽出

-

特徴量の選択

| フェーズ | 処理内容 | パラメータ |

|---|---|---|

| 分岐判断時 | 特徴量のランダム選択 | sqrt(n)個を選択 |

| 分割基準 | 不純度の計算 | ジニ係数/エントロピー |

| 停止条件 | 深さや不純度で判断 | max_depth等で制御 |

複数の決定木の作成

個々の決定木の多様性を確保することが、ランダムフォレストの性能向上の鍵となります。

多様性を確保する仕組み:

-

データサンプリングの多様性

- 約63.2%のデータが選択される確率

- 残り36.8%はOOB(Out-Of-Bag)として評価に使用

- 各木で異なるデータセットを使用

-

特徴量選択の多様性:

特徴量数 = floor(sqrt(全特徴量数)) # 分類の場合

特徴量数 = floor(全特徴量数 / 3) # 回帰の場合

決定木の数の決定:

| 木の数 | 効果 | 注意点 |

|---|---|---|

| 100未満 | 計算コスト低 | 精度が不安定 |

| 100-500 | バランスが良好 | 一般的な選択 |

| 500以上 | 高精度 | 計算コスト大 |

予測結果の統合

複数の決定木からの予測結果を統合する方法は、タスクの種類によって異なります。

分類問題の場合:

- 多数決方式による決定

- 各クラスの確率を平均

- 信頼度スコアの算出

回帰問題の場合:

- 各決定木の予測値の平均

- 予測値の分布による信頼区間の算出

- 外れ値の影響を軽減

ランダムフォレストのメリット・デメリット

機械学習アルゴリズムとしてのランダムフォレストは、優れた予測性能と実用性を備えていますが、同時にいくつかの制約や課題も存在します。実務での活用においては、これらの特性を十分に理解した上で、適切な使用方法を選択することが重要です。

ランダムフォレストのメリット

高い予測精度

ランダムフォレストは、一般的に高い予測精度を誇ります。これは、複数の決定木を組み合わせることで、個々の決定木の弱点を補い、全体としての精度を高めているためです。

例えば、ロジスティック回帰などの線形モデルは、データの線形な関係しか捉えることができません。一方、ランダムフォレストは、決定木を用いることで、データの非線形な関係も捉えることができます。

他アルゴリズムとの比較:

| アルゴリズム | 精度 | 計算コスト | 解釈性 |

|---|---|---|---|

| 決定木 | △ | ◎ | ◎ |

| ランダムフォレスト | ◎ | ○ | ○ |

| ロジスティック回帰 | ○ | ◎ | ◎ |

| ニューラルネットワーク | ◎ | △ | × |

過学習を防ぐ効果

過学習とは、学習データに過度に適合しすぎてしまい、未知のデータに対する予測精度が低下する現象です。ランダムフォレストは、決定木の多様性により、過学習を抑制する効果があります。

ランダムフォレストでは、各決定木が異なるデータと特徴量を用いて学習されるため、個々の決定木が過学習を起こしにくくなります。また、複数の決定木の予測結果を統合することで、過学習の影響をさらに軽減することができます。

様々なデータに対応可能

ランダムフォレストは、数値データだけでなく、カテゴリデータも扱うことができます。また、欠損値に対しても、特別な処理を必要とせずに、そのまま適用することができます。

対応可能なデータ特性:

| データ型 | 対応力 | 必要な前処理 |

|---|---|---|

| 数値データ | ◎ | スケーリング不要 |

| カテゴリデータ | ○ | エンコーディング |

| テキストデータ | ○ | ベクトル化 |

| 画像データ | △ | 特徴量抽出 |

ランダムフォレストのデメリット

計算コストの高さ

ランダムフォレストは、複数の決定木を構築するため、計算コストが高くなる傾向があります。決定木の数やデータ量が多いほど、計算に時間がかかります。

計算コストに影響する要因:

-

データサイズ

- サンプル数の増加

サンプル数が多いほど、ブートストラップサンプリングで抽出するデータ量が増え、各木の訓練にかかる時間も長くなります。 - 特徴量の数

次元数が多いデータセットでは、分岐に利用される特徴量の組み合わせも膨大になるため、探索時間が増加します。特に、テキストや画像などの多次元データでは計算コストが上がりやすくなります。 - メモリ使用量

サンプル数や特徴量の増加に伴い、メモリ使用量も増加し、大規模データを扱う場合、メモリ不足や計算速度の低下が発生する可能性があります。

- サンプル数の増加

-

モデルパラメータ

- 決定木の数

決定木の数が多いほど、アンサンブル全体の予測精度は向上する可能性がありますが、その分計算負荷も増加します。実際のデータセットに合わせて適切な木の数を設定することが重要です。 - 木の深さ

木の深さが深いほど、各木が複雑なパターンを学習しやすくなりますが、計算負荷が高くなり、過学習のリスクも増します。 - 並列処理の設定

並列処理を有効にすることで計算効率は向上しますが、メモリ消費量が増え、ハードウェアへの負荷がかかります。並列処理の適切な設定が求められます。

- 決定木の数

解釈の難しさ

ランダムフォレストは、複数の決定木を組み合わせるため、モデルの解釈が複雑になります。

個々の決定木の構造を理解することは比較的容易ですが、全体としてのモデルの振る舞いを理解することは難しい場合があります。

解釈性の課題:

- ブラックボックス的な性質

ランダムフォレストでは、各決定木がランダムにサンプリングされたデータや特徴量で学習されるため、全体としての振る舞いを一意に説明することが難しいです。これは、特にビジネスや医療のように予測根拠の説明が重要な場面では課題となります。 - 個々の予測の判断根拠の説明困難

ランダムフォレストは、各木の予測結果を平均化(または多数決)することで最終的な予測を出力するため、個々の決定木の貢献度や予測根拠が見えにくくなります。どの特徴量がどのように予測に影響したかを具体的に説明するのが難しく、判断の透明性が欠けがちです。 - 複雑な特徴量間の相互作用

ランダムフォレストは、各決定木が異なるデータの部分集合で学習するため、特徴量間の相互作用が複雑になりがちです。複数の特徴量がどのように組み合わさって予測結果に寄与しているのかを分析するのは容易ではありません。

ランダムフォレストの活用事例

ランダムフォレストは、その高い予測精度と実装の容易さから、様々な産業分野で実践的に活用されています。

特に、大量のデータが利用可能な分野では、その真価を発揮し、ビジネス価値の創出に大きく貢献しています。

| 活用分野 | 具体的な用途 |

|---|---|

| 医療画像診断 | 病変検出、MRI画像分類 |

| 自然言語処理 | 文書分類、感情分析 |

| マーケティング | 顧客分析、離反予測 |

| 金融 | 不正検知、リスク評価 |

画像認識

医療分野からセキュリティまで、画像認識技術は現代社会の様々な場面で活用されています。ランダムフォレストは、深層学習が普及する以前から画像認識タスクで使用されており、現在でも特定の用途では優れた選択肢となっています。特に医療画像診断の領域では、X線画像やMRI画像から病変を検出する補助システムとして実装されています。

医療現場では判断の根拠を示すことが重要であり、ランダムフォレストの特徴量重要度を活用することで、診断の説明性を確保しています。また、製造業での品質管理においても、不良品の自動検出や製品の分類に活用され、生産性向上に貢献しています。

主な応用分野:

- 医療画像の病変検出

- セキュリティカメラの異常検知

- 製造ラインの品質検査

- 衛星画像の土地利用分類

- 顔認識システム

画像認識での特徴的な利点:

- 特徴量ベースの堅牢な判断

- 判断根拠の明確な説明

- 少量データでの効果的な学習

- 処理速度と精度のバランス

自然言語処理

テキストデータの爆発的な増加に伴い、自然言語処理の重要性は年々高まっています。カスタマーサポートの現場では、大量の問い合わせメールやチャットログを自動分類し、適切な部署への振り分けや優先度の判定に活用されています。また、ソーシャルメディアの投稿分析では、ブランドに対する感情分析や、トレンドの検出にも使用されています。

特に、テキストマイニングの分野では、文書分類や感情分析などの基本的なNLPタスクにおいて、安定した性能を発揮します。Word2Vecなどの単語埋め込みと組み合わせることで、より深い言語理解を実現し、高精度な分析が可能になっています。

実践的な活用例:

- メール自動分類

- スパムフィルタリング

- 感情分析

- 文書カテゴリ分類

- キーワード抽出

テキスト処理における利点:

- 高速な処理と学習

- 多言語対応の容易さ

- 新しい分類カテゴリへの適応性

- スケーラブルな実装

マーケティング

顧客行動の予測と理解は、現代のマーケティングにおいて極めて重要な要素となっています。ランダムフォレストは、豊富な顧客データを活用して、精度の高い予測モデルを構築することができます。特に顧客離反予測の分野では、その優れた予測性能を発揮しています。

購買履歴、Webサイトでの行動データ、顧客属性情報など、複数のデータソースを組み合わせることで、離反リスクの高い顧客を早期に特定し、適切な施策を展開することが可能になっています。また、レコメンデーションシステムでは、顧客の嗜好を学習し、パーソナライズされた商品提案を実現しています。

主な活用領域:

- 顧客離反予測(チャーン分析)

- 購買行動予測

- 顧客セグメンテーション

- クロスセル・アップセル機会の特定

- キャンペーン効果予測

予測モデルの特徴:

- 複数データソースの効果的統合

- リアルタイムスコアリング

- 施策効果の定量評価

- 顧客行動の変化検知

金融

金融分野では、リスク評価や不正検知など、高い精度と説明責任が求められる場面で活用されています。特に、クレジットカードの不正利用検知では、取引パターンの異常を検出し、リアルタイムでのリスク評価を可能にしています。また、融資審査においては、申込者の属性や過去の取引履歴から、デフォルトリスクを予測し、審査の判断材料として活用されています。

主要な適用分野:

- クレジットスコアリング

- 不正取引検知

- 市場リスク評価

- 与信判断

- ポートフォリオ分析

金融分野での活用が進む背景には、ランダムフォレストの高い予測精度だけでなく、その判断過程の説明可能性があります。金融規制上、モデルの判断基準を説明する必要がある場面で、特徴量重要度などを用いて、判断の妥当性を示すことができます。これにより、コンプライアンスを維持しながら、高度な予測モデルの運用が可能となっています。

リスク評価の主要領域:

-

信用リスク管理

- 個人・法人の返済能力評価

- 将来的なデフォルト可能性の予測

- 与信限度額の動的な調整

-

市場リスク分析

- 資産価格の変動予測

- ポートフォリオのリスク評価

- 市場動向の予測モデリング

特に重要なのは、モデルの出力結果をビジネス判断に活用する際の透明性です。ランダムフォレストは、予測に影響を与えた要因を明確に示すことができ、これは規制当局への報告や、顧客への説明において大きな利点となっています。また、新たなリスク要因の発見や、既存の審査基準の妥当性検証にも活用されており、リスク管理の高度化に貢献しています。

ランダムフォレストの実装【Python】

実務でのAI開発において、ランダムフォレストの実装にはPythonのscikit-learnライブラリが広く使用されています。scikit-learnは、統一的なAPIと豊富なドキュメントを提供し、効率的なモデル開発を可能にします。特に、ランダムフォレストの実装では、分類問題と回帰問題の両方に対応する充実した機能を備えています。

scikit-learnの基本実装

分類問題と回帰問題の基本的な実装方法について、それぞれのユースケースに応じた実装例を見ていきましょう。

基本的なワークフロー:

- データの準備:データセットを読み込み、入力データ(特徴量)とターゲットデータ(ラベル)を分けます。

- データの分割:データを訓練用とテスト用に分割します。こうすることでモデルの性能を後でテストデータで評価できます。

- モデルの作成:ランダムフォレスト分類器を作成します。主要なパラメータはn_estimators(木の数)やmax_depth(木の深さ)などです。

- モデルの学習:訓練データを使ってモデルを学習させます。

- 予測と評価:テストデータに対して予測を行い、予測精度を確認します。

- 必要なライブラリのインポート

from sklearn.datasets import load_iris # データの読み込み

from sklearn.model_selection import train_test_split # データの分割

from sklearn.ensemble import RandomForestClassifier # ランダムフォレストモデル

from sklearn.metrics import accuracy_score, classification_report # 評価用の指標

- データの準備

data = load_iris() # Irisデータセット(例)を読み込み

X = data.data # 特徴量(花の情報)

y = data.target # ラベル(花の種類)

- データの分割

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

- モデルの作成

clf = RandomForestClassifier(n_estimators=100, random_state=42)

- モデルの学習

clf.fit(X_train, y_train)

- 予測と評価

y_pred = clf.predict(X_test) # テストデータに対して予測

accuracy = accuracy_score(y_test, y_pred) # 予測精度の計算

print("Accuracy:", accuracy) # 精度の表示

print(classification_report(y_test, y_pred)) # 各クラスの詳細な評価結果

- 分類問題の例

clf = RandomForestClassifier(

n_estimators=100,

max_depth=None,

min_samples_split=2,

random_state=42

)

- 回帰問題の例

reg = RandomForestRegressor(

n_estimators=100,

max_depth=None,

min_samples_split=2,

random_state=42

)

- 主要パラメータ

| パラメータ名 | 説明 | 推奨設定範囲 |

|---|---|---|

| n_estimators | ランダムフォレスト内の決定木の数。木の数が多いほど精度が向上するが、計算時間も増加する。 | 100-1000 |

| max_depth | 各決定木の最大の深さ。深くするほど複雑なモデルになるが、過学習のリスクも高まる。 | 3-20 |

| min_samples_split | ノードを分割する際に必要な最小サンプル数。大きな値にするとよりシンプルなモデルになる。 | 2-20 |

| min_samples_leaf | リーフノード(末端ノード)に必要な最小サンプル数。大きな値にすると過学習を抑えられる。 | 1-10 |

| max_features | 各分割で考慮する特徴量の数。ランダム性を増やし、汎化性能を向上させる効果がある。分類問題では「auto(デフォルト)」「sqrt」「log2」が一般的。 | "auto", "sqrt", "log2" |

| bootstrap | ブートストラップサンプリングを使用するかを指定。通常はTrueにして、ランダムに抽出されたサンプルで木を成長させる。 |

True, False |

| random_state | 再現性を保つための乱数シード。設定すると同じ結果が得られる。 | 任意の整数 |

モデルの学習と評価

モデルの学習から評価まで、実践的なワークフローを見ていきます。特に重要なのは、適切な評価指標の選択と、クロスバリデーションによる性能評価です。

評価指標の選択:

- 分類問題

| 指標 | 説明 | 適用例 |

|---|---|---|

| 正解率(Accuracy) | 全体のサンプルの中で正しく分類された割合。クラスが均等でない場合は不適切な評価になることがある。 | 全体の正確さ確認 |

| 適合率(Precision) | 正と予測されたサンプルのうち、実際に正である割合。正例の予測精度が重要な場合に使用する。 | スパム検出 |

| 再現率(Recall) | 実際に正であるサンプルのうち、正と予測された割合。正例の見逃しを防ぐことが重要な場合に使用する。 | 疾患検出 |

| F1スコア | 適合率と再現率の調和平均。どちらも重要な場合にバランス良く評価できる。 | 全体的なバランス確認 |

- 回帰問題

| 指標 | 説明 | 適用例 |

|---|---|---|

| 平均二乗誤差(MSE) | 誤差の二乗平均。大きな誤差に敏感で、誤差を小さくすることに最適化する指標。 | 予測値の精度確認 |

| 平均絶対誤差(MAE) | 絶対誤差の平均。MSEよりも外れ値の影響を受けにくく、誤差の平均を直感的に示す。 | 精度を全体で確認したい場合 |

| 決定係数(R²) | モデルがデータをどれだけ説明できているかを示す指標。1に近いほど良いモデルで、0はランダムと同等の予測を示す。 | 全体のモデル適合度の確認 |

- 回帰問題での評価例

ハイパーパラメータのチューニング

モデルの性能を最適化するために、グリッドサーチやランダムサーチを使用したハイパーパラメータのチューニングが重要です。

チューニングの主なアプローチ:

-

グリッドサーチ(網羅的探索)

-

ランダムサーチ(確率的探索)

-

ベイズ最適化

-

グリッドサーチ(網羅的探索)

グリッドサーチは、指定したハイパーパラメータのすべての組み合わせを試行し、最も良い結果をもたらすパラメータの組み合わせを見つける手法です。各組み合わせに対して交差検証を行い、モデルの性能を評価します。

from sklearn.model_selection import GridSearchCV

from sklearn.ensemble import RandomForestClassifier

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

# データの準備

data = load_iris()

X = data.data

y = data.target

# データの分割

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# モデルのインスタンス化

model = RandomForestClassifier(random_state=42)

# ハイパーパラメータの範囲を指定

param_grid = {

'n_estimators': [100, 200, 300],

'max_depth': [None, 10, 20, 30],

'min_samples_split': [2, 5, 10]

}

# グリッドサーチの設定

grid_search = GridSearchCV(

estimator=model,

param_grid=param_grid,

cv=5, # 5分割の交差検証

scoring='accuracy', # モデルの性能評価指標

n_jobs=-1 # 全てのCPUコアを使用

)

# グリッドサーチの実行

grid_search.fit(X_train, y_train)

# 最良のパラメータとスコアの表示

print("Best Parameters:", grid_search.best_params_)

print("Best Cross-validated Accuracy:", grid_search.best_score_)

- ランダムサーチ(確率的探索)

ランダムサーチは指定した範囲内からランダムにハイパーパラメータを選択し、性能を評価する手法です。すべての組み合わせを試すわけではないため、計算コストが低く、短時間で良好な結果を得られることがあります。

from sklearn.model_selection import RandomizedSearchCV

from sklearn.ensemble import RandomForestClassifier

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

import numpy as np

# データの準備

data = load_iris()

X = data.data

y = data.target

# データの分割

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# モデルのインスタンス化

model = RandomForestClassifier(random_state=42)

# ハイパーパラメータの範囲を指定

param_distributions = {

'n_estimators': np.arange(100, 400, 100), # 100から300までの範囲を指定

'max_depth': [None, 10, 20, 30],

'min_samples_split': [2, 5, 10]

}

# ランダムサーチの設定

random_search = RandomizedSearchCV(

estimator=model,

param_distributions=param_distributions,

n_iter=10, # 試行する組み合わせの数

cv=5, # 5分割の交差検証

scoring='accuracy', # モデルの性能評価指標

n_jobs=-1, # 全てのCPUコアを使用

random_state=42

)

# ランダムサーチの実行

random_search.fit(X_train, y_train)

# 最良のパラメータとスコアの表示

print("Best Parameters:", random_search.best_params_)

print("Best Cross-validated Accuracy:", random_search.best_score_)

- ベイズ最適化

ベイズ最適化は過去の評価結果を基に次に試すべきハイパーパラメータの組み合わせを決定する手法です。これにより少ない試行で高い性能を得られる可能性が高まります。ライブラリとしてはscikit-optimizeなどがあります。

最適化のポイント:

| 観点 | 内容 | 重要度 |

|---|---|---|

| 計算コスト | 探索範囲と実行時間のバランス | ★★★ |

| 汎化性能 | 過学習を防ぐパラメータ選択 | ★★★★★ |

| メモリ使用量 | 効率的なリソース利用 | ★★★★ |

モデルの保存と読み込み

scikit-learnで作成したモデルを永続化することで、再学習の手間を省き、簡単にモデルをデプロイできます。Pythonではpickleやjoblibといったライブラリを使って、学習済みモデルをファイルに保存し、再利用することが可能です。特にjoblibは、大規模なデータの保存に最適化されているため、モデルの永続化に推奨されます。

import joblib

# モデルの保存

joblib.dump(model, 'random_forest_model.joblib')

# モデルの読み込み

loaded_model = joblib.load('random_forest_model.joblib')

上記のコードで、joblib.dumpを用いてモデルをrandom_forest_model.joblibという名前で保存しています。また、保存したモデルはjoblib.loadで読み込み、推論や再訓練に再利用できます。

運用環境での注意点:

-

バージョン互換性の確認

モデルの保存に使われたscikit-learnやPythonのバージョンと、読み込む際のバージョンが異なると、互換性の問題が発生する場合があります。これは特にモデルが異なる環境で利用される場合に重要です。モデルを保存したバージョンの記録や、同じ環境でのデプロイが推奨されます。 -

メモリ使用量の管理

モデルのサイズが大きくなると、読み込みや推論時にメモリを大量に消費します。運用環境のメモリ制限に注意し、必要に応じてモデルの軽量化や、メモリ消費の少ないアルゴリズムの選択が求められます。joblibはメモリ効率が良いとされますが、モデルのサイズが非常に大きい場合には、モデル圧縮やモデルの構造自体を再検討することも考えましょう。 -

推論速度の最適化

実運用においては、推論のスピードがシステム全体のパフォーマンスに影響を与えます。推論速度を向上させるため、モデルの圧縮や量子化、より高速なデータ処理ライブラリの使用や、C++やCUDA対応のモデル実装などの工夫を行うとよりよいでしょう。 -

モデルの定期的な再学習

実データが変化する可能性がある場合、モデルの性能を維持するために、一定期間ごとに再学習が必要です。再学習のスケジュールを設定し、定期的に性能評価を行うことで、モデルの劣化を防ぎます。再学習の頻度は業務内容やデータの特性に依存しますが、定期的な評価が品質を保つ鍵です。

特徴量の重要度

ランダムフォレストの大きな利点の一つは、モデルの判断に対する各特徴量の貢献度を定量的に評価できることです。この特徴量重要度の分析は、モデルの解釈性を高め、ビジネス上の意思決定に役立つ洞察を提供します。

特徴量の重要度とは

特徴量重要度は、各特徴量がモデルの予測にどの程度影響を与えているかを数値化したものです。ランダムフォレストでは、各決定木の分岐で不純度の減少量に基づいて計算され、予測精度に寄与する度合いを評価します。

計算方法の概要:

-

不純度の減少量計算

各決定木の分岐で、特徴量が関与する際の不純度(例えば、ジニ不純度やエントロピー)の減少量を計算します。この不純度減少が大きいほど、その特徴量が予測に与える影響が大きいとされます。 -

特徴量ごとに減少量を集計

すべての分岐点における不純度減少量を、特徴量ごとに合計し、どの特徴量が全体の予測にどれほど貢献しているかを示します。 -

全決定木での平均を算出

ランダムフォレストは多数の決定木の集合体であるため、各特徴量の重要度を全決定木で平均化し、モデル全体の重要度を算出します。

重要度の特徴:

| 観点 | 説明 | 注意点 |

|---|---|---|

| 相対的な値 | 全特徴量の合計が1 | 絶対値での比較は不適切 |

| 非負値 | 0以上の値のみ | 負の影響は表現できない |

| 木の深さ依存 | 上位の分岐ほど影響大 | バイアスに注意 |

ランダムフォレストの応用

ランダムフォレストの基本的な実装を発展させ、より高度な応用や他のアルゴリズムとの組み合わせにより、さらなる性能向上が可能です。特に、Extra Treesや勾配ブースティングとの組み合わせは、実務でよく使用される手法です。

Extra Trees

**Extra Trees(Extremely Randomized Trees)**は、ランダムフォレストと似たアンサンブル学習アルゴリズムで、計算効率や汎化性能をさらに向上させるためのランダム性が強化されています。ランダムフォレストでは、各決定木が特徴量をランダムに選択し、最適な分岐基準を探していくのに対し、Extra Treesでは分岐の閾値も完全にランダムに設定します。

Extra Treesの特徴:

- より高速な学習

分岐の閾値をランダムに設定するため、最適な閾値の計算が不要となり、学習時間が短縮されます。特に大量のデータや特徴量を扱う場合に、計算コストを削減できます。 - 過学習のさらなる抑制

決定木のランダム性を強化することで、各木の予測が相互に独立し、過学習を防ぐ効果がさらに高まります。これにより、未知のデータに対する汎化性能が向上します。 - 特徴量重要度の安定性向上

完全にランダムに分岐するため、特徴量間での相関の影響が軽減され、特徴量重要度のランキングがより安定します。 - メモリ効率の改善

Extra Treesは各木がシンプルで、木構造も比較的小さくなるため、メモリ使用量が抑えられ、特にメモリ制約が厳しい環境での適用が可能です。

ランダムフォレストとの比較:

| 観点 | Random Forest | Extra Trees |

|---|---|---|

| 学習速度 | 標準 | より高速 |

| メモリ使用量 | 標準 | より効率的 |

| 予測精度 | 標準 | 同等/やや低下 |

| ノイズへの耐性 | 良好 | より強い |

実装例:

from sklearn.ensemble import ExtraTreesClassifier

# Extra Treesの実装例

et_model = ExtraTreesClassifier(

n_estimators=100,

max_depth=None,

random_state=42

)

Extra Treesの適用場面:

Extra Treesは、計算効率や汎化性能の向上を重視する場面に適しています。特に以下のケースで有用です

- データのサイズが大きい場合:

分岐の閾値計算を省略するため、学習速度が速くなり、大規模データセットにも対応しやすくなります。 - ノイズの多いデータ:

完全なランダム性により、ノイズの影響を受けにくくなるため、ノイズが多いデータに対して安定した予測が可能です。 - 特徴量の重要度を分析する場合:

ランダム性が強化されているため、特徴量間の相関が低減され、特徴量重要度がより安定した結果となる傾向にあります。

ランダムフォレストと勾配ブースティング

両手法を組み合わせることで、それぞれの長所を活かした高性能なモデルを構築できます。

アンサンブル手法の特徴:

-

ランダムフォレスト

- 並列学習が可能

- 過学習しにくい

- パラメータ調整が容易

-

勾配ブースティング

勾配ブースティングは、誤差を修正しながら新しい木を追加していく逐次学習方式で、より高精度なモデルを目指すことが可能です。- より高い予測精度

- 逐次的な学習

- きめ細かな調整が可能

実践的な組み合わせ方:

from sklearn.ensemble import GradientBoostingClassifier

from sklearn.ensemble import VotingClassifier

# アンサンブルモデルの構築

estimators = [

('rf', RandomForestClassifier()),

('gb', GradientBoostingClassifier())

]

ensemble = VotingClassifier(

estimators=estimators,

voting='soft'

)

運用上の考慮点:

| 項目 | 内容 | 対応策 |

|---|---|---|

| 計算コスト | 処理時間の増加 | 並列処理の活用 |

| メモリ使用量 | リソース消費の増加 | モデルの軽量化 |

| チューニング | パラメータ探索の複雑化 | 段階的な最適化 |

まとめ

ランダムフォレストは、機械学習の中でも特に強力なモデルの一つです。数多くの決定木を組み合わせることで、非常に高い予測精度と汎化性能を実現しています。特徴量のランダムな選択とブートストラップサンプリングを用いることで、過学習を防ぎ、モデルの解釈性も確保しています。これにより、どの特徴量が予測にどのように寄与しているのかを理解しやすくなっています。

医療、マーケティング、金融など、多岐にわたる分野での応用が進んでおり、具体的には異常検知、画像診断、顧客行動分析などで信頼性の高い予測が提供されています。また、scikit-learnなどのライブラリを使用することで、実装や評価が容易になり、データ分析の専門家でなくても扱いやすいのが魅力です。

適切なパラメータチューニングや最適化を行うことで、高精度かつ効率的な運用が可能になります。これからのデータ駆動型社会において、ランダムフォレストはますます重要な役割を果たすでしょう。興味のある方は、ぜひこのモデルを取り入れ、データ分析の力を実感してみてください。

AI総合研究所では、データ分析環境構築、データ分析内製化研修を提供しています。

企業でのデータ分析・活用をサポートしていますのでお気軽にご相談ください。