この記事のポイント

この記事はDatabricksによる新しい大規模言語モデル「DBRX」の開発について記述しています。

DBRXはMixture of Expertsアーキテクチャを採用し、プログラミングやテキスト補完などのタスクに高性能を発揮します。

NVIDIAのGPUソリューションと組み合わせることで、多様な業界への応用が見込まれています。

無料のクラウドクレジットを使用してDBRXを試すことができ、開発者はこれを自社アプリケーションに統合する検討材料として活用できます。

監修者プロフィール

坂本 将磨

Microsoft AIパートナー、LinkX Japan代表。東京工業大学大学院で技術経営修士取得、研究領域:自然言語処理、金融工学。NHK放送技術研究所でAI、ブロックチェーン研究に従事。学会発表、国際ジャーナル投稿、経営情報学会全国研究発表大会にて優秀賞受賞。シンガポールでのIT、Web3事業の創業と経営を経て、LinkX Japan株式会社を創業。

新たな大規模言語モデル「DBRX」がDatabricksによって開発されました。

この技術はMixture of Expertsアーキテクチャを用いており、プログラミングやテキスト補完といったタスクに高いパフォーマンスを提供します。

さらに、NVIDIAのGPUソリューションと組み合わせることで、ヘルスケアやテレコミュニケーションを含む多様な業界での活用が期待されています。

本記事ではDBRXの特徴や、NVIDIAとの連携、無料クラウドクレジットによる試用方法などについて解説していきます。開発者はこれらの情報を参考に、自社アプリケーションへの統合を検討できるでしょう。

Databricksの新技術「DBRX」とは?

Databricksが開発した最先端の大規模言語モデル(LLM)であるDBRXは、プログラミングやコーディング、テキスト補完などのタスクに優れたパフォーマンスを発揮します。

DBRXの最大の特徴は、Mixture of Experts(MoE)アーキテクチャを採用していることです。MoEは、複数の専門家ネットワークを使用して管理され、トークンごとに最も関連性の高い専門家ネットワークがアクティブ化されます。

これにより、入力データの各部分を効率的に処理することができます。DBRXは、合計1,320億個のパラメータを持ち、そのうち常に360億個がアクティブな状態にあります。

DBRXの使用例

NVIDIAのGPU加速ソリューションとの連携

DBRXは、NVIDIA TensorRT-LLMを使用してレイテンシとスループットを最適化しています。

また、NVIDIAのマイクロサービスであるNIMでサポートされており、パフォーマンスが最適化されたAIモデルの展開を簡素化します。

NVIDIAは主要なモデルビルダーと協力し、Llama3-70B、Llama3-8B、Gemma 2B、Mixtral 8X22Bなどの人気モデルを完全に高速化されたスタックでサポートしています。

DBRXとNVIDIAのGPU加速ソリューションの組み合わせにより、ヘルスケアやテレコミュニケーションなど、多岐にわたる産業での利用が期待されています。

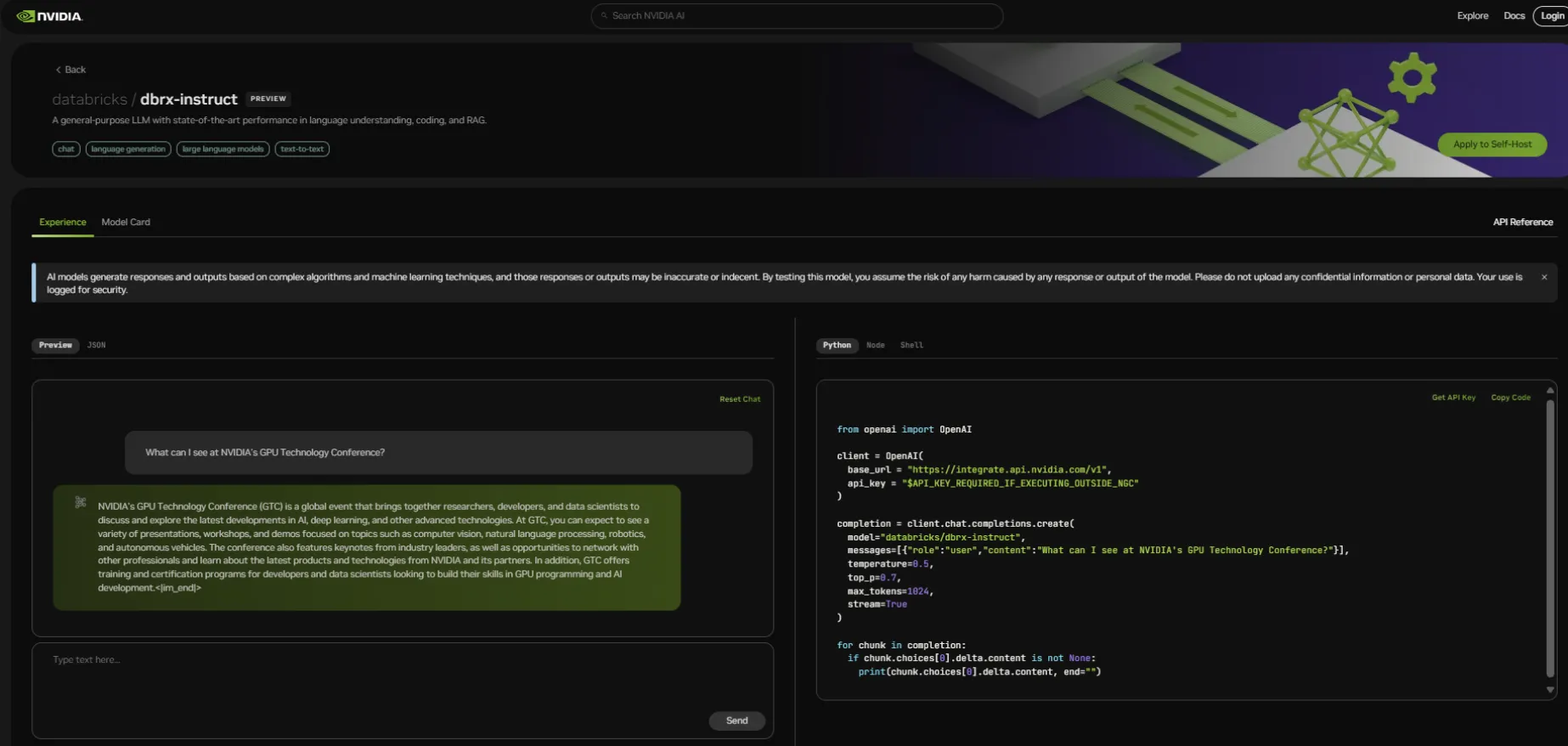

無料クラウドクレジットを利用したDBRXの試用

DBRXの使用を開始するには、NVIDIA のウェブサイト「build.nvidia.com」にアクセスします。

無料のNVIDIAクラウドクレジットを使用することで、NVIDIAがホストするAPIエンドポイントにアプリケーションを接続し、モデルの大規模なテストや概念実証(POC)の構築が可能です。

これにより、開発者はDBRXの性能を実際に試すことができ、自社のアプリケーションへの統合を検討することができます。

出典:NVIDEA