この記事のポイント

新しい大規模言語モデル「SnowflakeのLLMArctic」について説明しています。

LLMArcticは合計480Bのパラメータを持つDense-MoEハイブリッドアーキテクチャを用いており、SQL問い合わせ生成やコーディング作業の効率化に寄与します。

同モデルは、自然言語の質問からSQLクエリへ79%の高精度で変換する能力があるとSpiderベンチマークで実証されています。

NVIDIAのエコシステムとも連携し、NVIDIA NIMマイクロサービスを介して展開されることで、各種の最適化とアクセスのしやすさが確保されます。

さらに、NVIDIAのウェブサイトではクッキーポリシーが明示されており、ユーザーは自分のクッキー設定を管理できるようになっています。

監修者プロフィール

坂本 将磨

Microsoft AIパートナー、LinkX Japan代表。東京工業大学大学院で技術経営修士取得、研究領域:自然言語処理、金融工学。NHK放送技術研究所でAI、ブロックチェーン研究に従事。学会発表、国際ジャーナル投稿、経営情報学会全国研究発表大会にて優秀賞受賞。シンガポールでのIT、Web3事業の創業と経営を経て、LinkX Japan株式会社を創業。

データ処理の自動化やコード生成を促進する新たなテクノロジーが誕生しました。Snowflake社は、SQLクエリの生成や企業のコーディング作業を助ける新しい大規模言語モデル「Arctic」を発表しました。

この480Bパラメータを搭載したモデルは、Dense-MoEハイブリッドアーキテクチャを採用し、高いリソース効率を誇ります。Spiderベンチマークでは79%の精度で自然言語をSQLに変換する能力を実証しています。

Snowflakeの新LLM「Arctic」登場: SQLとコード生成に最適化

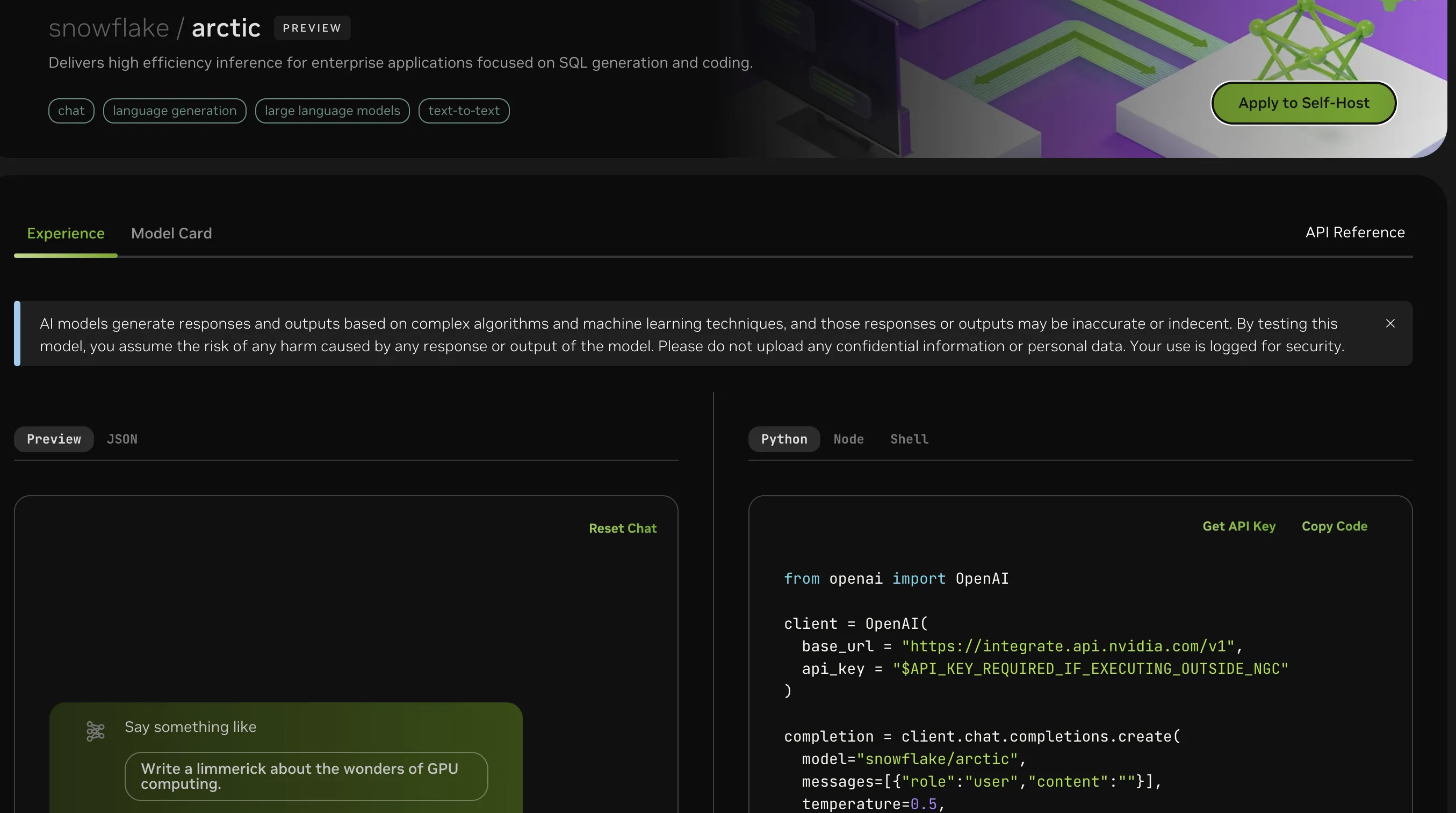

2024年4月26日、Snowflake社はArcticという新しい大規模言語モデル(LLM)を発表しました。このモデルは、SQLの問い合わせやコーディング作業を効率化することを目的としており、特に企業アプリケーションでの使用に最適化されています。

Arcticの最大の特徴は、新しいDense-MoE(Mixture of Experts)ハイブリッドトランスフォーマーアーキテクチャに基づいており、合計480Bのパラメータを持ちます。

このアーキテクチャは、密なトランスフォーマーモデルと分散型のエキスパートモデルを組み合わせており、トレーニング時と推論時のリソースの効率的な使用を可能にしています。

また、ArcticはSpiderベンチマークで79%という高精度を達成しており、これによって自然言語の質問からSQLクエリへの変換能力を評価することができます。

Arcticのデモ画面

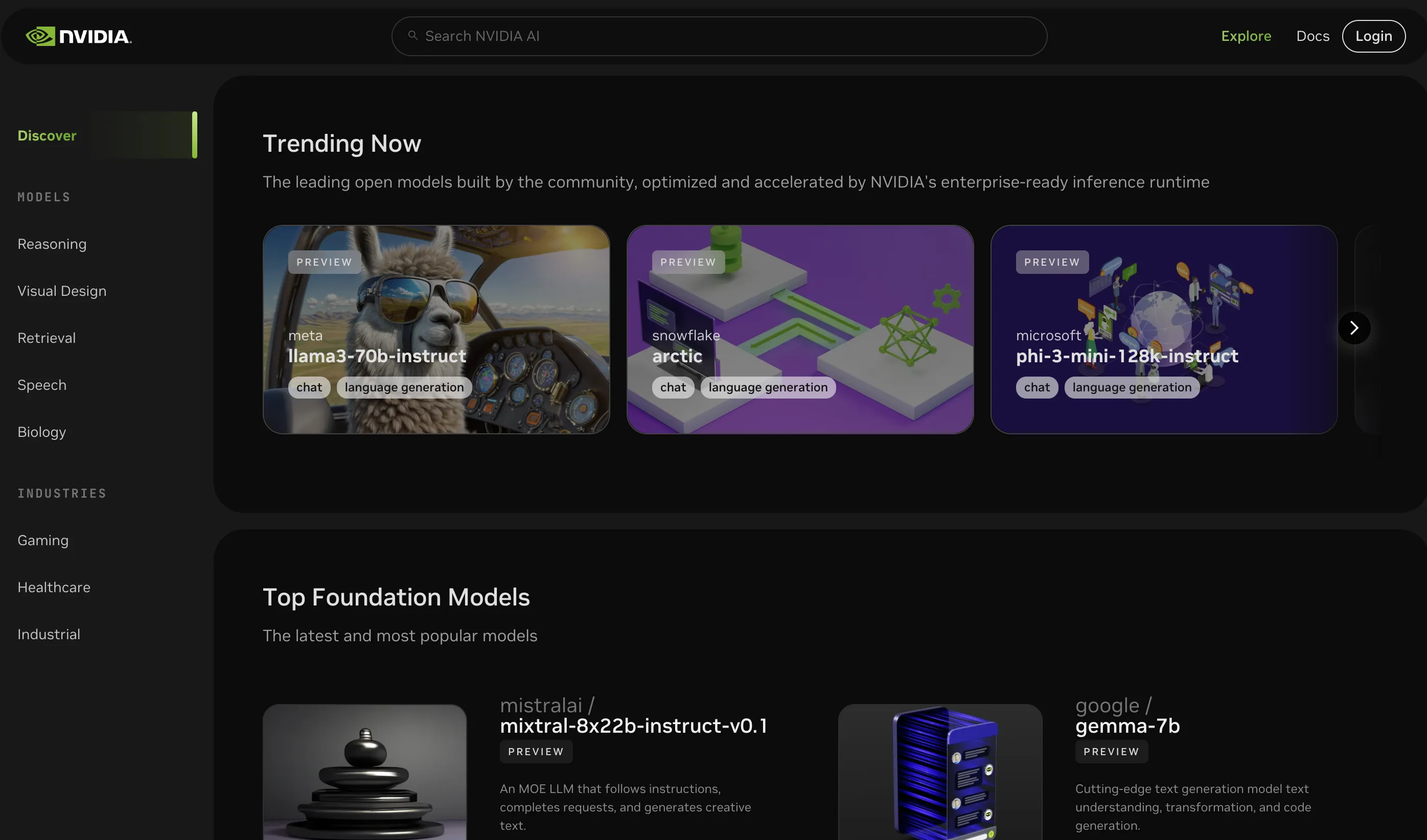

NVIDIAのエコシステムと連携: Arcticの展開と利用

ArcticはNVIDIAのエコシステムと連携し、NVIDIA NIMマイクロサービスを利用して配備することができます。

これにより、レイテンシやスループットの最適化が図られ、開発者はNVIDIA APIカタログからArcticにアクセスできるようになっています。

NVIDE APIカタログ

NVIDIAのクラウドクレジットを使用して、ブラウザからモデルを体験し、実際のアプリケーションに接続してコンセプト実証(POC)を構築することができます。

また、オンプレミス、クラウド、あるいは自分のワークステーションで、数分でモデルを展開する柔軟性があります。

これにより、データのセキュリティとプライバシーを保ちながら、既存のインフラストラクチャ投資やクラウドへのコミットメントを最大限に活用することが可能です。

NVIDIAのウェブサイトとクッキーポリシー

NVIDIAは、そのウェブサイトを通じてAI技術に関する情報やディスカッションのリソースを提供しています。また、ウェブサイトの機能性とユーザー体験の向上のためにクッキーを使用していることを公表しており、詳細なクッキーポリシーがあります。

NVIDIAプライバシーセンターを通じて、ユーザーは自分のクッキー設定を管理することができます。パフォーマンスクッキーは、ウェブサイトとの相互作用を追跡するために使用され、広告クッキーは、個人データを保存せずにブラウザとデバイスの特定に基づいてターゲット広告を表示するために使用されます。

ユーザーは、提供されたオプションを通じてクッキーに対する同意を制御することができます。

出典:NVIDEA