この記事のポイント

XAIはAIの意思決定プロセスを人間が理解可能な形で説明する技術

XAIの主な手法には「大域的説明」と「局所的説明」がある

XAIツールにはSHAP、LIME、What-If Toolなどがある

医療、建設、製造、金融など多様な分野でXAIが活用されている

XAI導入には開発の難しさ、コスト、解釈の複雑さなどの課題がある

監修者プロフィール

坂本 将磨

Microsoft AIパートナー、LinkX Japan代表。東京工業大学大学院で技術経営修士取得、研究領域:自然言語処理、金融工学。NHK放送技術研究所でAI、ブロックチェーン研究に従事。学会発表、国際ジャーナル投稿、経営情報学会全国研究発表大会にて優秀賞受賞。シンガポールでのIT、Web3事業の創業と経営を経て、LinkX Japan株式会社を創業。

AIの意思決定過程を人間が理解し、信頼するためには、いかにAIが決定を下したのかを明らかにする必要があります。

そこで注目されるのが「XAI(説明可能なAI)」です。

本記事では、AI技術の透明性と信頼性を向上させる目標を持つXAIについて、その必要性や手法、導入のメリットと課題を丁寧に解説します。

さらに、XAI導入に伴う課題や将来の展望についても触れ、AI技術の発展と社会への浸透におけるXAIの重要性を明らかにしていきます。

目次

1. SHAP (SHapley Additive exPlanations)

2. LIME (Local Interpretable Model-Agnostic Explanations)

【コンサルティング】AI導入・運用支援サービス(日立コンサルティング)

XAI(説明可能なAI)とは

XAIは出力に至るまでの根拠や過程が人間に「説明可能なAI」

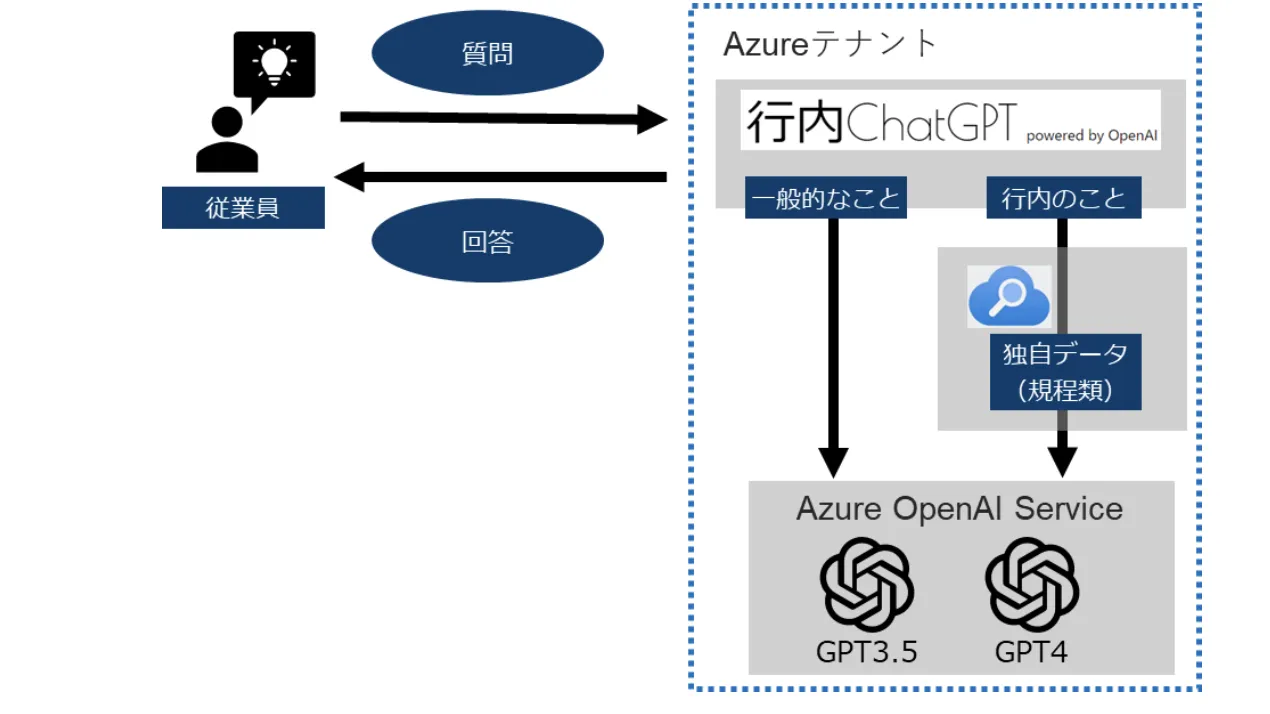

**XAI(Explainable Artificial Intelligence)とは、「AIの意思決定プロセスを透明化し、人間が理解可能な形で説明する技術」です。

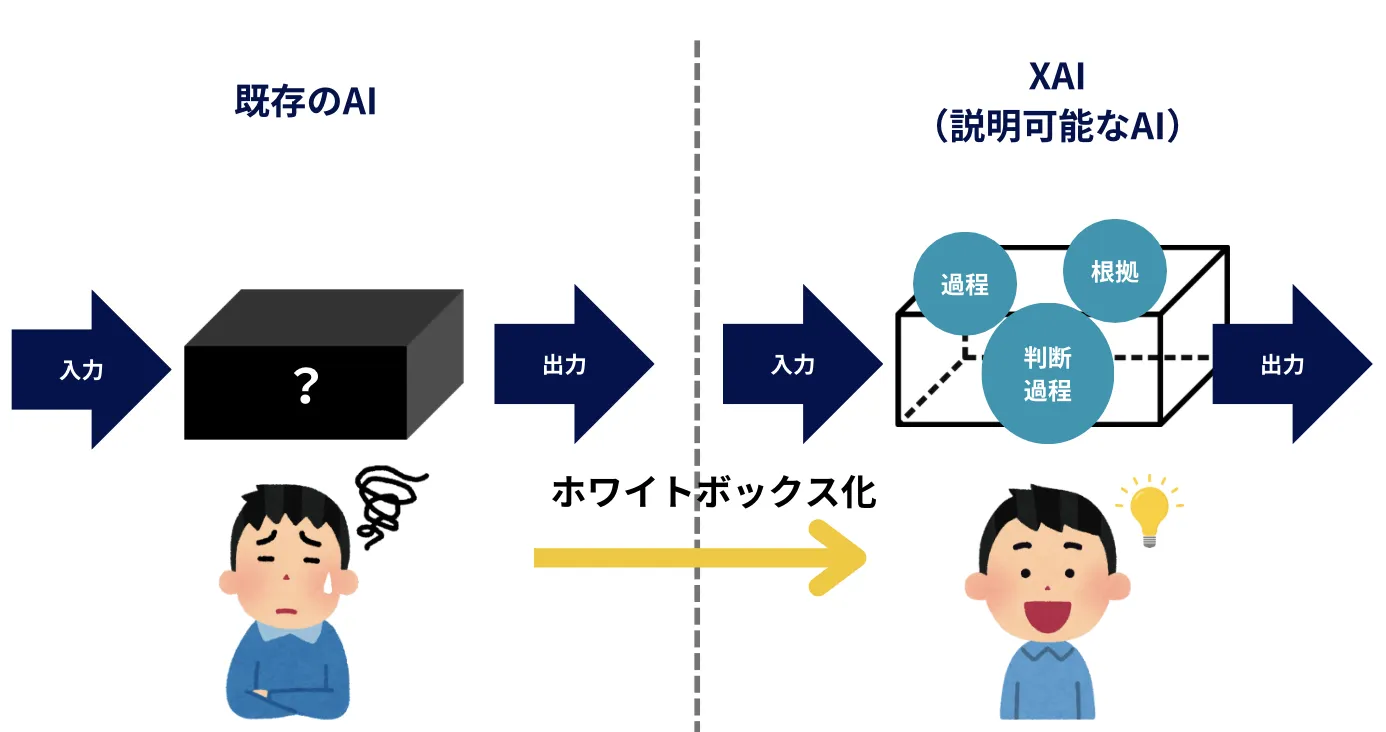

従来のAIモデル、特にディープラーニングは「ブラックボックス」と呼ばれ、その内部の意思決定プロセスが不透明でした。

XAIは、このブラックボックスを開き、「AIがどのようにして特定の結論に至ったのか」を明らかにすることを目指しています。

XAIの重要性と企業での活用メリット

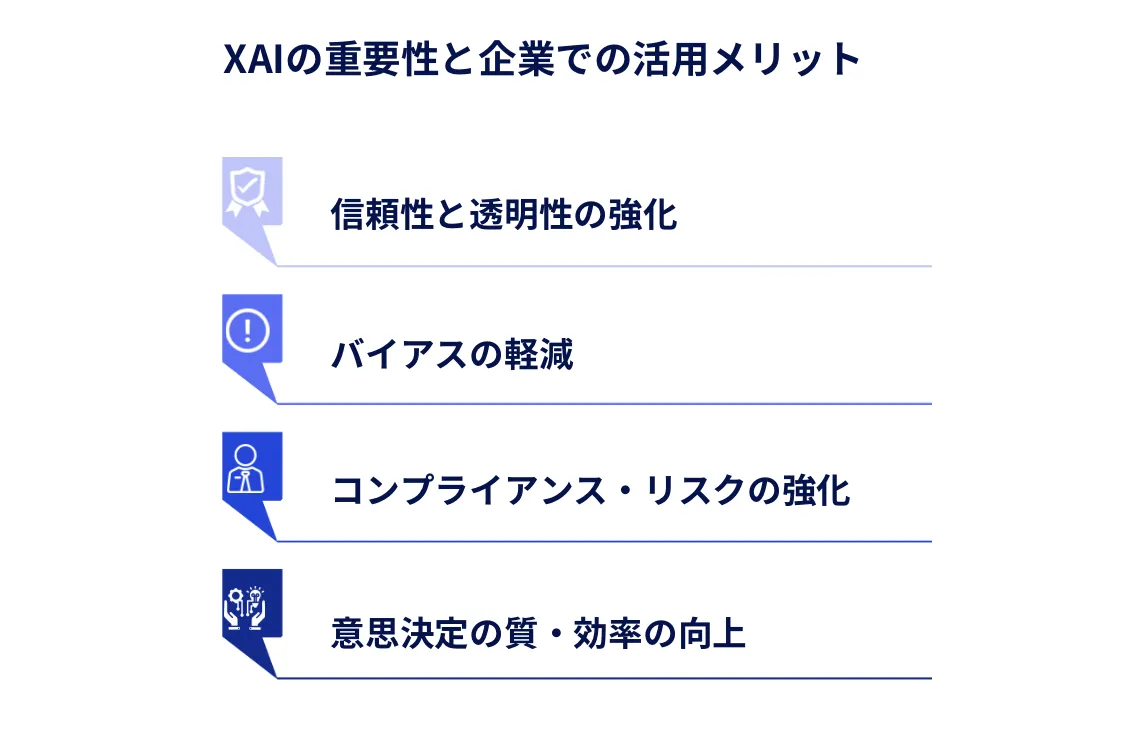

XAIの重要性は、AIが社会のさまざまな分野で重要な意思決定を行うようになるにつれて、ますます高まっています。

医療診断、金融取引、自動運転車など、人々の生活に直接影響を与える分野でAIが活用される中、その判断過程の透明性と説明可能性は不可欠です。

XAIの重要性と企業での活用メリット4つ

1.信頼性と透明性の強化

また、XAIを活用することで、ビジネス全体の信頼性を向上させることができます。

XAIは、AIの意思決定プロセスを可視化することで、ユーザーや利害関係者の信頼を獲得します。

これは特に、医療診断や金融取引など、重要な決定を行う分野で重要です。

透明性の向上により、AIシステムの採用率が高まり、ビジネス全体の信頼性向上につながります。

2.バイアスの軽減

AIモデルには、訓練データに基づくバイアスが含まれることがあります。

XAIを用いることで、モデルが特定のバイアスに基づいて意思決定を行っていないかを検証し、必要に応じて調整することで、公平性の確保が可能になります。

3.コンプライアンスとリスク管理の強化

多くの産業や地域では、AIの利用に関する規制が強化されています。

XAIは、モデルの意思決定プロセスを説明可能にすることで、法的・規制的な要件を満たしやすくし、企業がコンプライアンスを維持するのに役立ちます。

さらに、XAIを活用することで、規制当局や監査機関への対応が容易になり、リスク管理の面でも強化が図れます。

4.意思決定の質と効率の向上

XAIにより、AIモデルの判断根拠を理解することができるため、人間の専門家がその結果を検証し、必要に応じて介入することが可能になります。

これにより、AIと人間の協働が促進され、より質の高い意思決定が可能となります。

XAIの主な手法

XAIには様々な手法がありますが、大きく分けて「大域的な説明(Global Explanation)」と「局所的な説明(Local Explanation)」の2つのアプローチがあります。

これらの手法は、AIモデルの解釈可能性を高め、その判断プロセスを人間が理解しやすい形で提示することを目的としています。

大域的な説明(Global Explanation)

大域的な説明は、モデル全体の振る舞いを解釈することを目的としています。

主な手法には以下のようなものがあります。

- 特徴量重要度: モデル全体で各入力特徴量がどの程度重要かを測定します。

- 部分依存プロット(PDP): 特定の特徴量が予測にどのように影響するかを視覚化します。

- モデルの近似: 複雑なモデルを、より解釈しやすい簡単なモデル(例:決定木)で近似します。

局所的な説明(Local Explanation)

局所的な説明は、個々の予測や決定に焦点を当て、特定のインスタンスに対するモデルの判断を説明します。

- LIME (Local Interpretable Model-agnostic Explanations): 予測を説明するために、局所的に解釈可能な近似モデルを使用します。

- SHAP (SHapley Additive exPlanations): ゲーム理論を基に、各特徴量の予測への貢献度を計算します。

- 反事実説明: 「もし入力がこう変わっていたら、結果はどうなっていたか」を示します。

これらの手法を適切に組み合わせることで、AIモデルの判断過程をより多角的に理解し、説明することが可能になります。

代表的なXAIツールの紹介

ここでは、先ほど説明した手法を用いた、XAIツールの中から特に注目されているものを3つ紹介します。

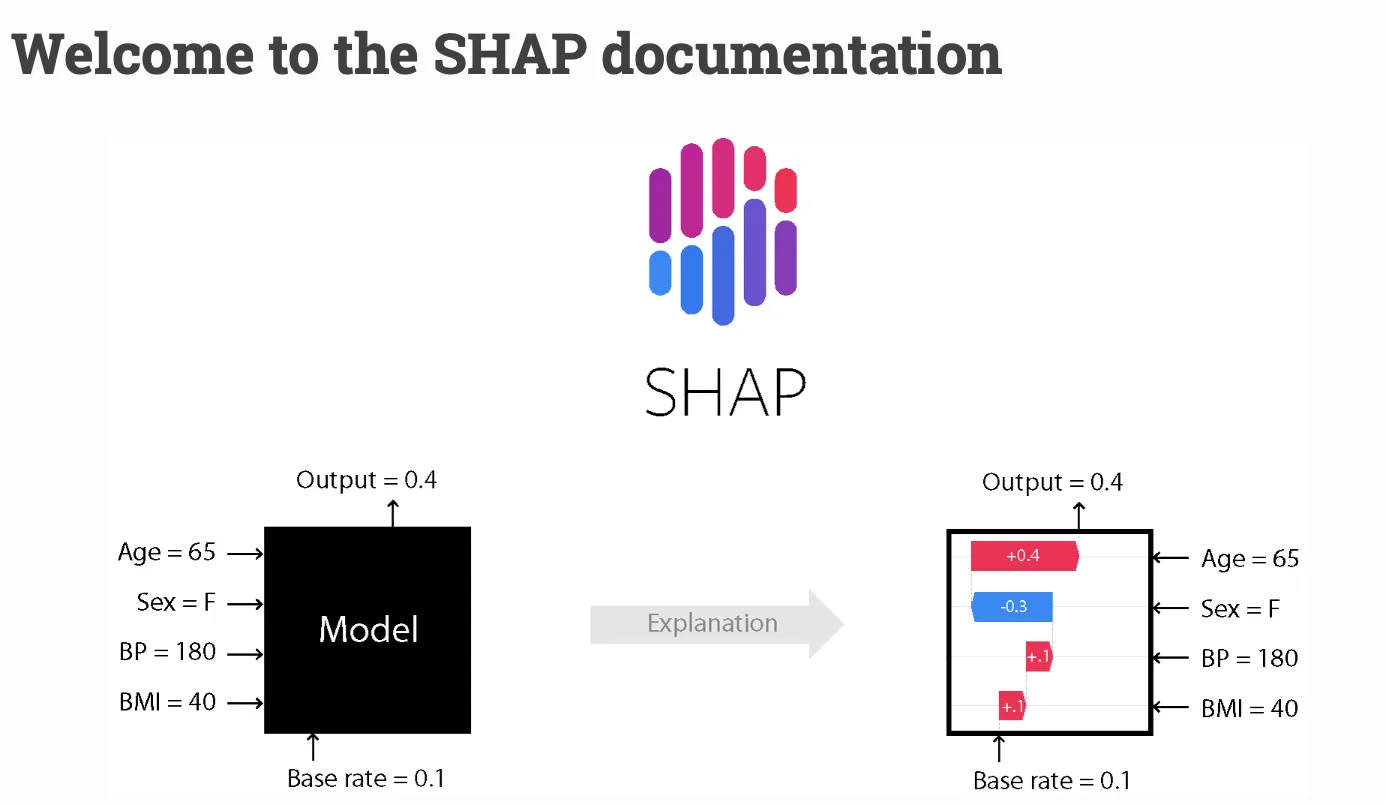

1. SHAP (SHapley Additive exPlanations)

SHapley Additive exPlanations (参考:SHAP)

SHAPは、AIがどのようにして特定の結論や予測にたどり着いたのかを説明する方法の一つです。

例えば、AIが「この植物は水が足りていない」と判断したとします。SHAPを使うと、AIがその判断をするための要素(例えば「葉の色」や「土の湿り具合」など)がどれくらい影響を与えたかを具体的に示すことができます。

SHAPは、複雑なAIの判断プロセスを分かりやすくするために、各要素の「貢献度」を計算します。

これにより、AIがなぜその結論に至ったのかを理解しやすくし、人々がAIをもっと信頼できるようにします。

2. LIME (Local Interpretable Model-Agnostic Explanations)

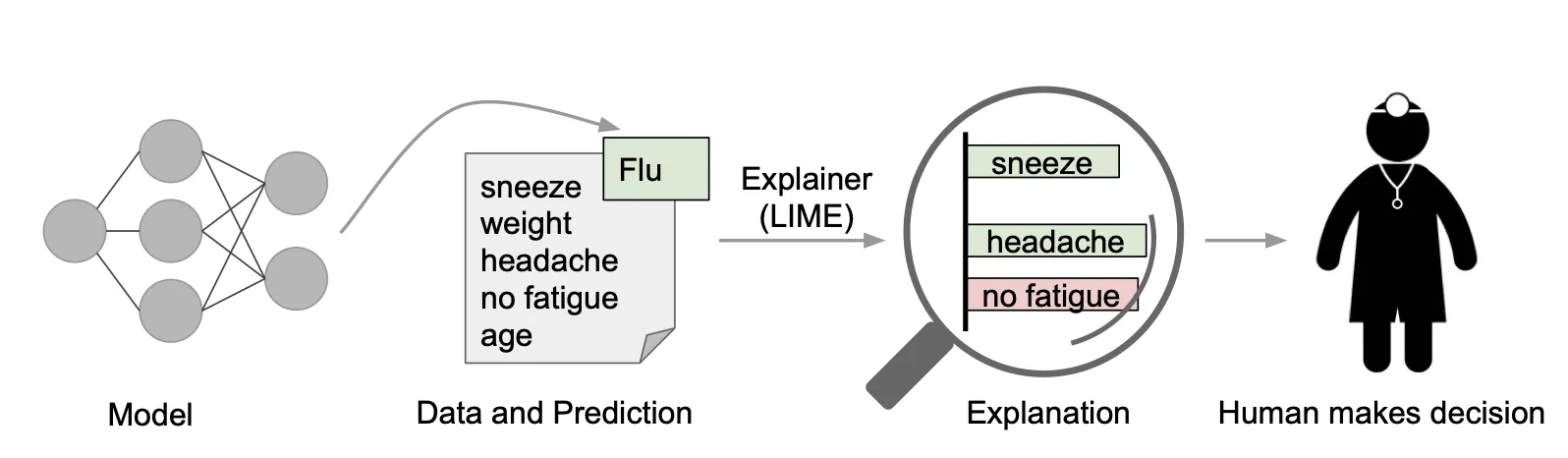

例えば、AIがある患者がインフルエンザにかかっていると予測した場合、LIMEを使うと、その予測に影響を与えた要因(例えば「くしゃみ」や「頭痛」など)を具体的に示すことができる。 (参考:“Why Should I Trust You?” Explaining the Predictions of Any Classifier)

LIMEは、モデルが複雑で解釈が難しい場合に、簡単なモデルを使って説明を作ります。

この技術は、元の複雑なモデルの近くで小さな変更を加えて予測を行い、それぞれの予測に最も影響を与えた特徴を線形モデルで近似して説明します。

これにより誤った判断があった場合でもその原因を見つけやすくなります。

3. What-If Tool

What-If Tool (参考:What-If Tool)

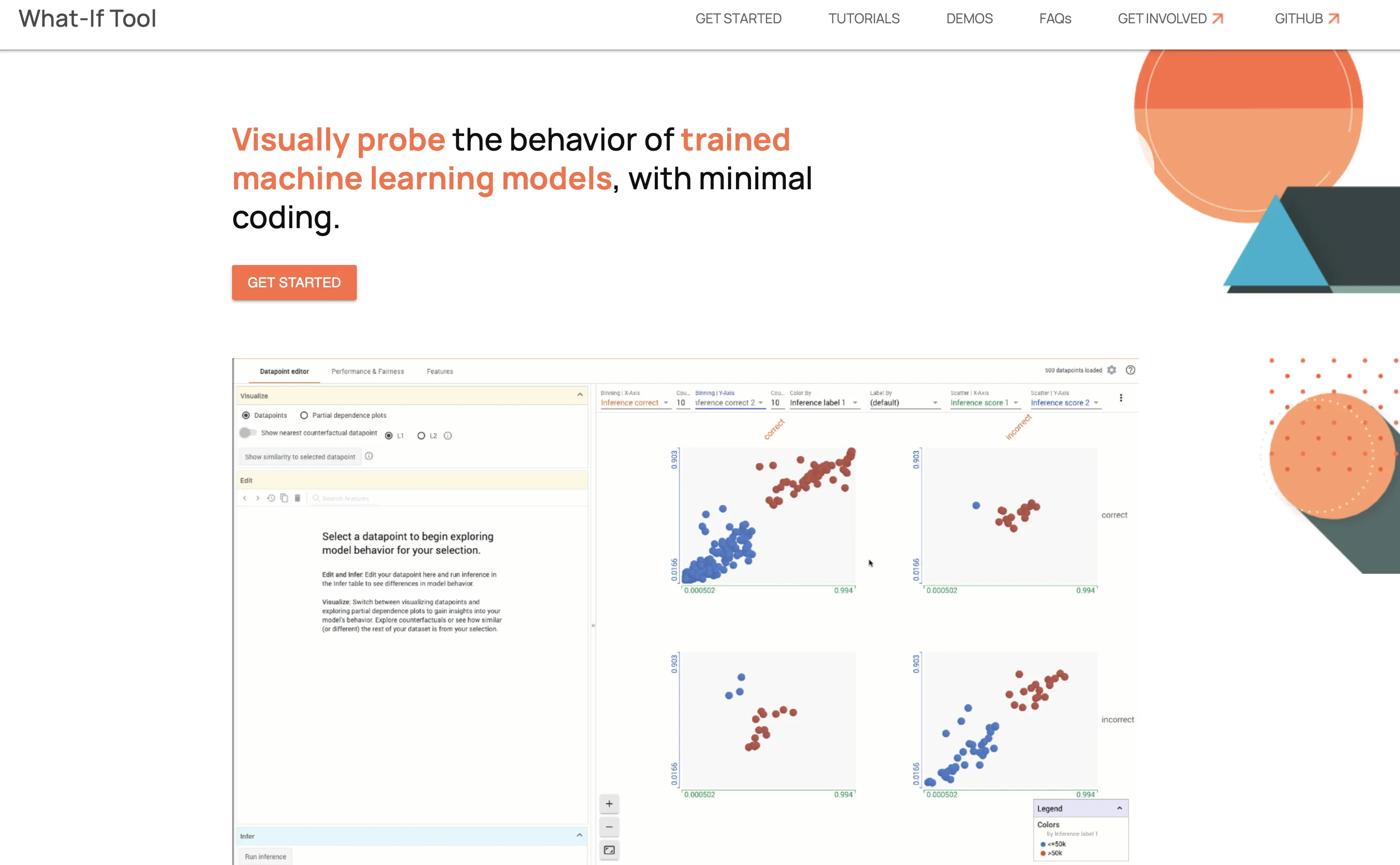

Googleが開発したWhat-If Toolは、AIモデルの振る舞いを探索し、「もし〜だったら」という

Googleが開発したWhat-If Toolでは、AIが異なる状況やデータに対してどんな判断をするかを仮説検証するためのツールです。

例えば、AIが「この人はローンを返済できるかどうか💭」を判断するとします。

What-If Toolを使えば、

- 収入がもう少し高かったらどうなるか

- 借入額を減らしたら判断は変わるか

上記の様に、「もしも」の状況を試して、AIの反応を見ることができます。

このツールはAIの判断がどのように変わるかを視覚的に確認できるので、AIモデルの振る舞いを理解し、潜在的な偏見やエラーを発見するのに役立ちます。

XAIの活用事例

XAIは様々な産業で活用されており、AIの判断プロセスの透明化や信頼性の向上に貢献しています。

ここでは、実際のビジネス現場でXAIがどのように利用されているかを、具体的な事例を通じて紹介します。

【医療分野】肝がん発症リスク予測(日本IBM)

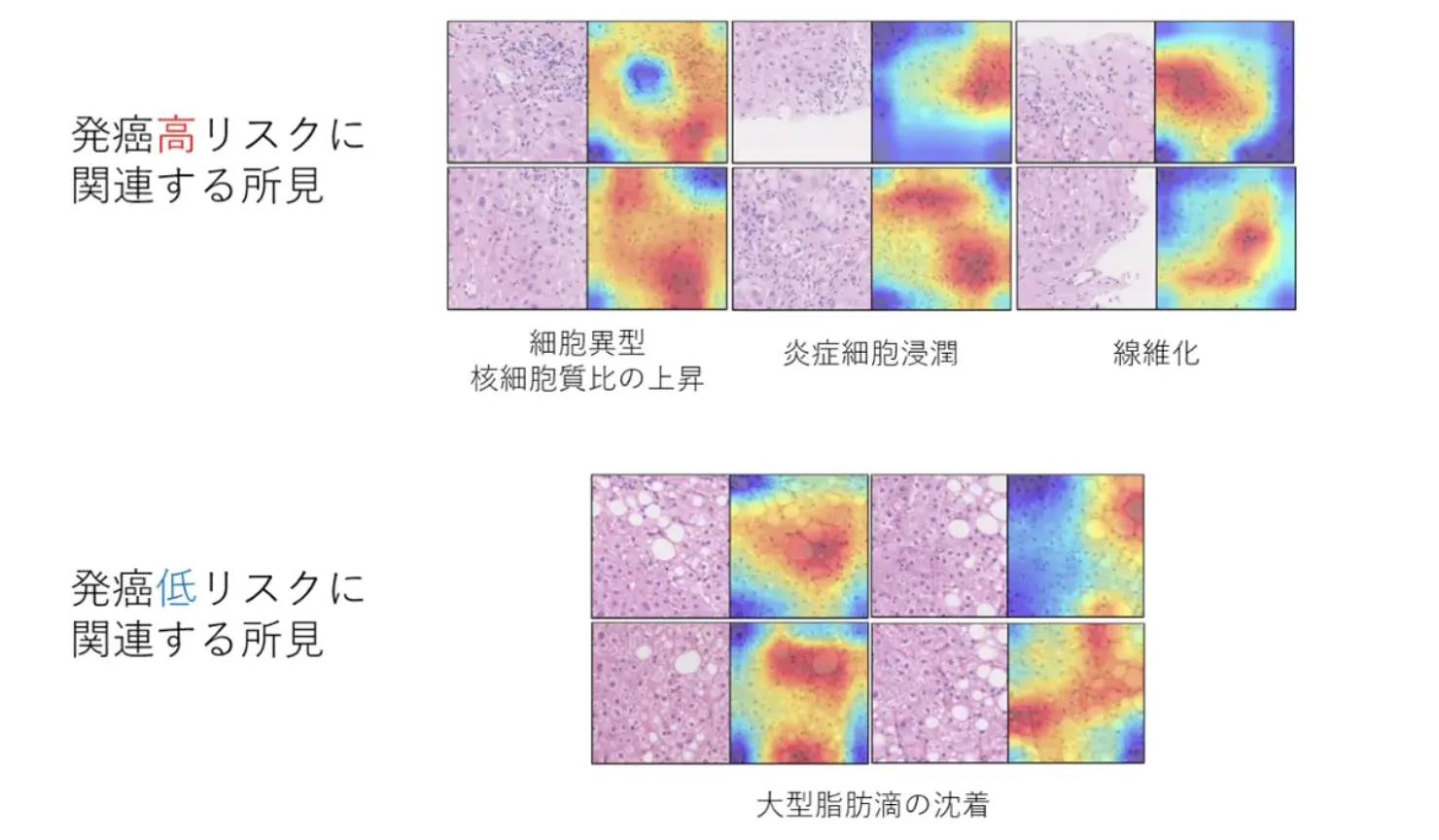

XAIが注目した肝がん発症に関連する病理学的所見

日本IBMは、肝生検デジタル病理画像を基に、脂肪肝から肝がん発症リスクを予測するAIモデルを開発しました。

このAIモデルは、従来の指標だけでは発見しにくい肝がんのリスクを、新たに注目された微細な病理所見から高精度で予測します。

さらに、XAI(説明可能なAI)の技術であるGrad-CAM++を用いて、AIがどの病理画像の部分に注目しているのかを明示化し、ヒトの目では見過ごされがちなサインを可視化しました。

この技術により、肝がんの早期発見と適切なフォローアップが可能となり、将来的には他疾患への応用も期待されています。

参考:

Deep learning and digital pathology powers prediction of HCC development in steatotic liver disease

脂肪肝病理画像から発がんを予測するAIモデル

【建設分野】コンクリート構造物の劣化要因診断(IHI)

![]()

AIcon診断のサービス概要

IHIグループは、コンクリート構造物の劣化要因をAIで診断する「AIcon診断サービス」を開発しました。

このサービスは、損傷写真から変状を識別する「変状識別AI」と、劣化要因を推定する「劣化推定AI」の2段階のAI機能を備え、XAI技術を利用して劣化要因の根拠を明示します。

診断結果は専門家がチェックし、適切な対策工法を提示する受託サービスも提供されています。

また、利用者が予算や現場条件に応じた概算工費を算定できる「概算工費システム」も利用可能です。

参考:

橋梁などインフラ構造物の点検・診断をサポートする2つのツールを開発~点検・診断品質の向上,業務効率化,コスト削減~

【製造業】タイヤ設計支援システム(横浜ゴム)

HAICoLabの概念図

横浜ゴム株式会社は2024年7月、XAI(説明可能なAI)を活用したタイヤの設計支援システムを独自に開発しました。

このシステムは、技術者がタイヤ設計において求める特性を効率的に達成できるように支援し、特に経験の浅い技術者でもスピーディに高性能なタイヤを設計できるように設計されています。

システムはXAI技術の一つである「SHAP」をカスタマイズしており、技術者に必要な情報を視覚的に提供します。

参考:

横浜ゴム、XAIを活用したタイヤ設計支援システムを独自開発

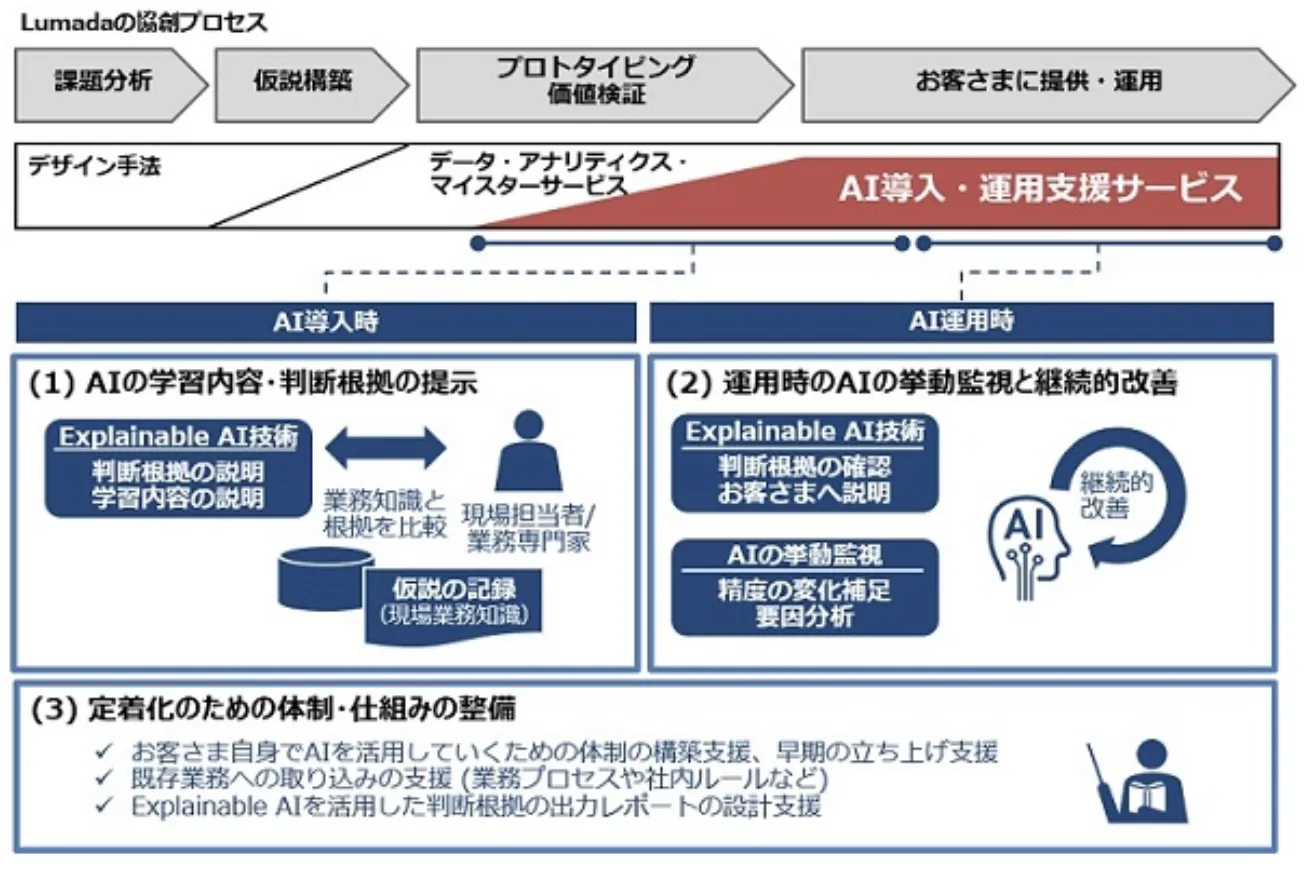

【コンサルティング】AI導入・運用支援サービス(日立コンサルティング)

AI導入・運用支援サービスの概要

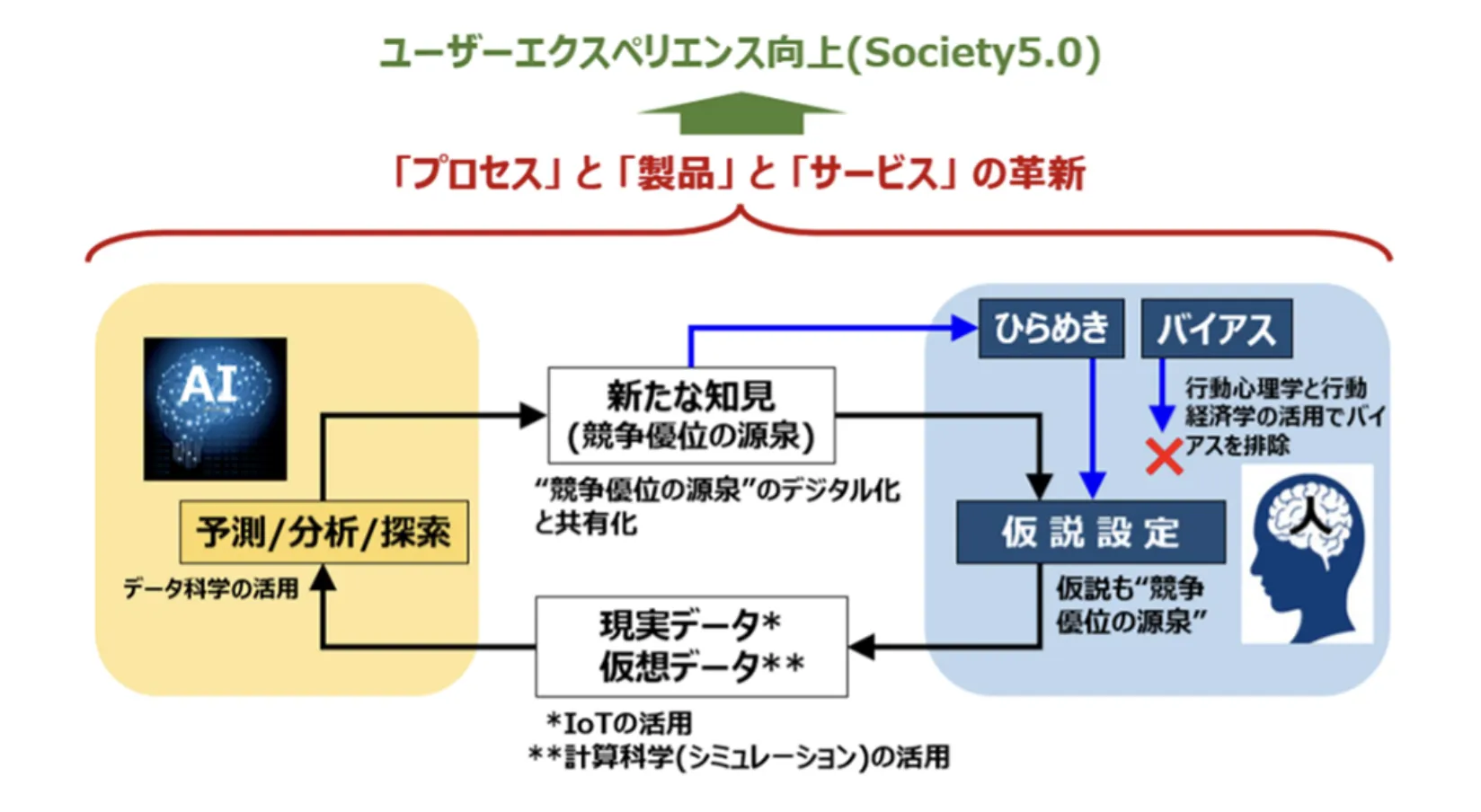

日立コンサルティングでは、XAIを活用した「AI導入・運用支援サービス」を提供しています。

このサービスは、業務システムにAIを適用する際、XAIを用いてAIの予測や判断の根拠を明確にし、現場担当者との見解の一致を図りつつ、AIモデルの継続的な改善を支援します。

さらに、運用中のAI挙動を監視し、XAIでモデルの精度低下や原因を特定、改善を行うことで、重要な業務でのAI適用を推進します。

また、体制整備やガバナンス強化も行い、デジタルトランスフォーメーションを支援します。

参考:

Explainable AI(XAI)を活用し、業務システムへのAIの適用や継続的な運用・改善を支援する「AI導入・運用支援サービス」を提供開始

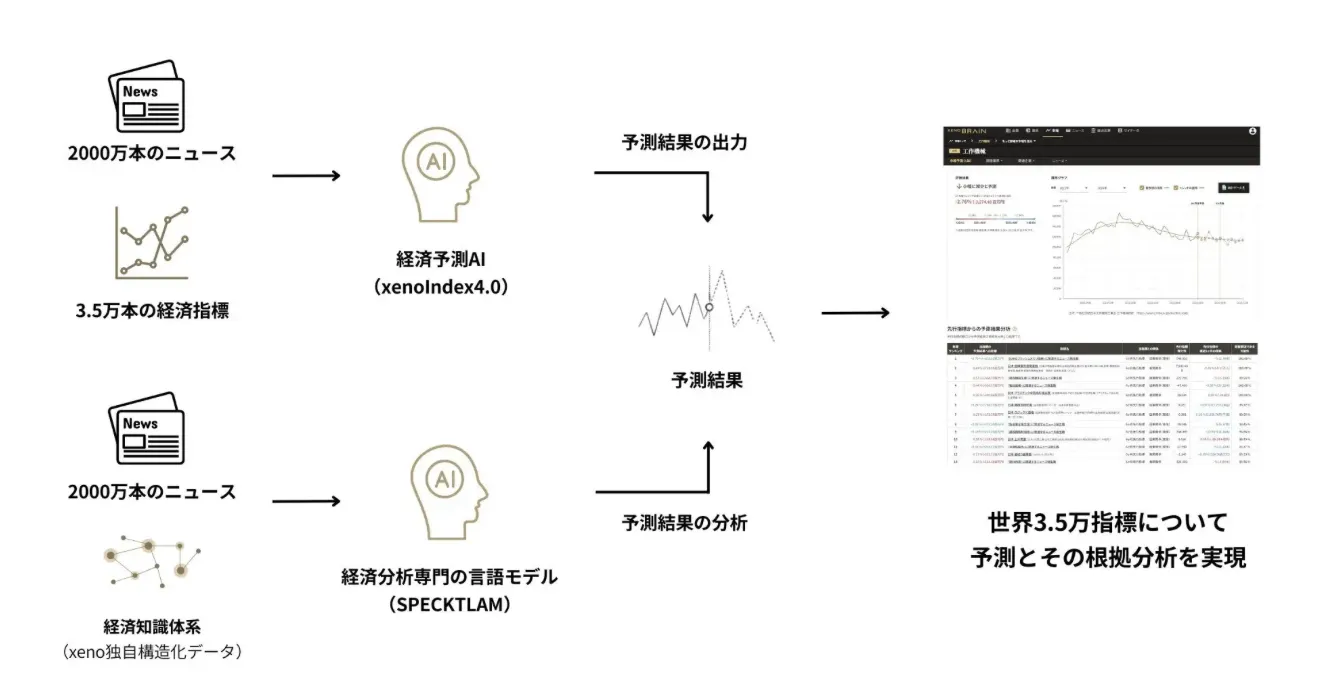

【金融分野】経済予測プラットフォーム(xenodata lab.)

xenoIndex(ゼノインデックス)「予測根拠分析」機能概要図

株式会社xenodata lab.は、経済予測プラットフォーム「xenoBrain」において、『説明可能なAI(XAI)』を活用した新機能「予測根拠分析」をリリースしました。

予測根拠根拠分析は、独自の言語モデル『SPECKTLAM』を使用し、AIが生成した予測に基づく要因分析を行います。

この機能により、AIが経済予測を行う際の根拠となる先行指標やニュースの動きを視覚的に確認できるようになりました。

**予測対象への影響や関連性を詳細に把握できるため、より信頼性の高い経済予測が期待できます。

参考:

経済特化生成AIのゼノデータ、『説明可能な AI(XAI)』として経済予測根拠分析機能をリリース~AI経済予測の根拠を、先行指標やニュース発生状況から説明可能に~

XAI導入に向けての課題

XAI導入に向けての課題

XAIを現実のシステムに導入するにあたって向き合う事になる3つの課題を解説します。

開発の難しさ

XAIは多様なアプローチが存在し、個別の企業だけで研究開発を完遂するのは困難です。XAIの手法は日々進化しており、最新の技術を追跡し、適切に実装するには高度な専門知識が必要です。

また、異なるAIモデルや問題領域に対して、最適なXAI手法を選択することも容易ではありません。

この課題に対処するには、学術界や他企業との協力、オープンソースツールの活用、継続的な学習と研究が重要となります。

コストの問題

XAIの導入には高いコストがかかります。特に計算リソースの確保や専門家の雇用が必要となります。

XAIは通常のAIモデルよりも計算量が多くなる傾向があり、高性能なハードウェアが必要になることがあります。また、XAIの専門家は需要が高く、人材の確保と育成にも投資が必要です。

これらのコストを正当化するためには、XAI導入による具体的なビジネス価値を明確に示すことが重要です。

PoC倒れのリスク

多くの企業がAIの実証実験(PoC)で止まり、本番運用に至らないケースが多いです。

これは、現場の不信感やAIの利用率の低さが原因とされています。

XAIはこの問題を部分的に解決する可能性がありますが、XAI自体も適切に導入・運用されなければ同様の問題に直面する可能性があります。

この課題を克服するには、段階的な導入アプローチ、ユーザーとの密接な協働、継続的な改善プロセスの確立が重要です。

まとめ

説明可能なAI(XAI)に関するこの記事では、XAIの定義、重要性、主な手法、活用事例、および関連する課題について探求しました。XAIは、AIシステムの意思決定プロセスを透明化し、利用者がそれを理解することを可能にする技術であり、幅広い分野での活用が期待されています。

XAIは、ユーザーにとってAIシステムが理解しやすいものとなることを目指し、これにより信頼性とコンプライアンスを高めることができます。しかし、その実現にはまだいくつかの課題が存在しており、技術的な複雑さ、パフォーマンスとのバランス、社会的・法的枠組みなど様々な問題に取り組む必要があります。