この記事のポイント

ChatGPTには機密情報漏洩、誤情報拡散、著作権違反などのセキュリティリスクがある

リスクの主な原因は、入力内容がモデルの学習に利用されることと、学習データの悪用可能性

個人情報や機密情報の不用意な入力を避け、安全なインターネット接続を使用することが重要

組織では適切な利用ガイドラインの制定やデータ損失防止(DLP)製品の導入が有効

OpenAIもデータ暗号化、アクセス制御、使用量監視などのセキュリティ対策を実施している

Microsoft AIパートナー、LinkX Japan代表。東京工業大学大学院で技術経営修士取得、研究領域:自然言語処理、金融工学。NHK放送技術研究所でAI、ブロックチェーン研究に従事。学会発表、国際ジャーナル投稿、経営情報学会全国研究発表大会にて優秀賞受賞。シンガポールでのIT、Web3事業の創業と経営を経て、LinkX Japan株式会社を創業。

AIモデルの進化は、コミュニケーションの革新をもたらす一方で、ChatGPTのようなシステムがもたらすセキュリティリスクにも注意が必要です。

本記事では、ChatGPTの基本機能とそれに伴うセキュリティ上の問題点を明らかにし、機密情報の漏洩、著作権侵害、誤情報の拡散といったリスクへの対処方法について、企業や個人が日常で実践できる具体的な対策を解説します。

また、プライバシー保護のための「適切な対策」やセキュリティ強化のための「ソフトウェア導入の重要性」そして「最終的な出力内容に対する人間によるチェックの必要性」を強調することで、読者のAIセキュリティに対する理解を深めることを目的としています。

OpenAIが発表した最新のAIエージェント、「OpenAI Deep Research」についてはこちら⬇️

【ChatGPT】OpenAI Deep Researchとは?使い方、料金体系を徹底解説!

目次

ChatGPTのセキュリティリスクとは

ChatGPTの利用が増えるにつれて、セキュリティリスクも顕在化しています。これらのリスクは主に次のような形で現れます。

機密情報の漏洩

ユーザーがChatGPTに質問やリクエストを行う際に、無意識に機密情報を含めてしまう可能性があります。これには個人識別情報(PII)、企業秘密、セキュリティの詳細などが含まれます。

一度インターネット上で共有された情報は取り返しがつかないことが多く、機密情報の漏洩は個人や組織にとって重大なリスクをもたらします。

例えば韓国のサムスン電子はエンジニアが社内機密のソースコードをChatGPTにアップロードし、誤って流出させたとして大問題になりました。この事件を機に、サムスンは社内での「生成AI」ツールの使用を禁止しています。

【関連記事】

➡️ChatGPTの情報漏洩事例はなぜ起きた?実際の事例を交えてその対策を紹介

誤情報の拡散リスク

ChatGPTは、学習データに基づいて応答を生成するため、学習データに含まれる偏見や誤った情報が、生成された文章に反映される可能性(ハルシネーションリスク)があります。

このため、ChatGPTが提供する情報の信頼性は完全ではなく、偽情報や誤情報が拡散されるリスクがあります。特に、ChatGPTの応答を鵜呑みにして、検証なしに情報を共有することで、深刻な影響を及ぼす恐れがあります。

【関連記事】

➡️ハルシネーションとは?その原因やリスク、対策方法を解説

著作権違反の可能性

著作権は、作品の創作物(文学、音楽、美術作品など)に対する排他的な権利を作成者に与える法律です。これには、作品の複製、配布、公演、展示などが含まれます。

ChatGPTが既存の作品から直接引用または大きく影響を受けた内容を生成した場合、その使用が著作権法の「引用」に適合しているかどうかが問題となります。また、コンテンツの使用目的も重要です。非商用目的であれば問題が少ない場合もありますが、商用目的で使用する場合は、著作権違反のリスクが高まる可能性があります。

そのため、ChatGPTを使用する際は、生成されたコンテンツが既存の著作権を侵害していないかを慎重に評価する必要があります。

【関連記事】

➡️AIで生成した作品の著作権はどうなる?注意点や実際の事例を徹底解説

ChatGPTでセキュリティ事故が起きる理由

ChatGPTでセキュリティリスクが懸念される理由としては、主に以下の2つが挙げられます。

- 入力内容がモデルの学習に利用されるため

- 学習データが悪用される恐れ

ここでは、それぞれについて詳しく解説していきます。

入力内容がモデルの学習に利用されるため

ChatGPTをはじめとするAI言語モデルは、膨大な量のデータを学習することで、人間のような自然な対話を可能にしています。

しかし、この学習プロセスには、インターネット上の多様なデータが含まれており、個人情報や機密情報、著作権を侵害するコンテンツなども含まれている可能性があります。

そのため、ユーザーがChatGPTにプライバシーに関する情報を入力した場合、その情報が意図せずモデルに学習され、別のユーザーとの対話で漏洩してしまうリスクがあるのです。

実際に、OpenAIはChatGPTの利用に際して以下の目的で個人情報を取得し、利用することを明記しています。

- ChatGPTの提供・管理・維持・分析

- **ChatGPTの改善・調査

- **ユーザーとのコミュニケーション

- 新しいプログラム・サービスの開発

- ChatGPTへの詐欺・犯罪行為・不正使用を防止し、OpenAIののITシステム・アーキテクチャ・ネットワークのセキュリティの確保

- 事業譲渡を行うため

- 法的義務及び法的手続を遵守するとともに、OpenAIおよび関連会社・ユーザー・その他の第三者の権利・プライバシー・安全・財産の保護

(出典:OpneAI プライバシーポリシー)

以下がChatGPTの利用により、OpenAIが自動的に取得する個人情報です。

| 項目 | 説明 |

|---|---|

| ログデータ | お客様のブラウザやデバイスが自動的に送信する情報。インターネットプロトコルアドレス、ブラウザの種類及び設定、リクエストの日時、お客様が本サービスとどのようなやりとりをしたかが含まれます。 |

| 利用データ | お客様が閲覧したり関与したコンテンツの種類、使用した機能、とった行動、タイムゾーン、国、アクセス日時、ユーザーエージェント及びバージョン、コンピュータやモバイルデバイスの種類、コンピュータ接続に関する情報。 |

| デバイス情報 | 使用するデバイス、オペレーティングシステム、デバイス識別子、使用しているブラウザの名称。収集される情報は、使用するデバイスの種類及び設定によって異なる。 |

| クッキー | ウェブサイトからブラウザに送信される情報の小片。本サービス運営・管理及び利用体験向上のために利用。クッキーの受け入れや拒否はブラウザの設定で選択可能。クッキーを拒否すると、ウェブサイトの利用に影響が出ることがある。 |

| 分析結果 | 本サービスの利用状況を分析し、体験を向上させる目的で、さまざまなオンライン分析製品にクッキーを使用。 |

(出典:OpneAI プライバシーポリシー)

また、法律で義務付けられている場合を除き、特定の状況において、ユーザーへの通知することなく、個人情報を第三者に提供することがあることも明記されています。

| 項目 | 説明 |

|---|---|

| ベンダー及びサービスプロバイダー | OpenAIが、事業のために必要なサービスを提供するベンダーやプロバイダーに個人情報を提供し、業務実行時のみ情報にアクセスさせる。 |

| 事業譲渡 | 戦略的取引や組織再編などで、ユーザーの情報が調査され、後継者や関連会社へ譲渡されることがある。 |

| 法律上の要請 | 必要に応じて、法律遵守や不正行為の防止などの目的で、ユーザーの情報を政府や第三者と共有することがあります。 。 |

| 関連会社 | OpenAIの関連会社に個人情報を共有し、プライバシーポリシーに従ってこれを利用することがある。 |

| ビジネスアカウント管理者 | ChatGPTエンタープライズやビジネスアカウントに参加すると、アカウント管理者がユーザーの情報にアクセスし管理することがある。 |

| お客様が情報を共有される他のユーザー又は第三者 | ユーザーはプラグイン等特定の機能を通じて他者と情報を共有できるが、共有相手の信頼性は自己責任で判断すること。 |

(出典:OpneAI プライバシーポリシー)

2.学習データが悪用される例

ChatGPTは高度な言語生成能力を持つため、悪意のあるユーザーが巧みな質問をすることで、本来開示すべきでない情報を引き出そうとする可能性もあります。

さらに、ChatGPTが生成した内容は、時として誤情報や偏見を含んでいる場合があり、それが拡散されることでセキュリティ上の問題が生じる恐れもあります。

例えば、フィッシング詐欺やスパムメールの作成、フェイクニュースの拡散などに利用される恐れがあります。

【関連記事】

➡️ChatGPTの問題点とは?その危険性や社会に与える影響を解説

また、米Google、ETH Zurich、NVIDIA、Robust Intelligenceに所属する研究者らが発表した論文「Poisoning Web-Scale Training Datasets is Practical」は、データポイズニングの危険性を指摘しています。

データポイズニングとは、「学習データセットに使われる前にデータへ毒(悪意ある改ざん)を仕込み、それらを学習した機械学習モデルを攻撃すること」を指します。

このような手法を用いて人種差別や性差別などのバイアスを悪化させたり、モデルに何らかのバックドアを埋め込んで学習後のモデルの動作を制御したりされる危険性があります。

ChatGPTのセキュリティ対策

ChatGPTのセキュリティリスクに対処するためには、多角的なアプローチが必要です。

ここでは、「利用者や組織が実践できるセキュリティ対策」および、「OpenAIによるセキュリティリスクへの取り組み」について解説します。

利用者ができる対策

個人や組織がChatGPTを安全に利用するために実践できる具体的な対策を4つご紹介します。

1.個人情報(機密性の高い情報)を不用意に入力しない

ChatGPTでの対話において、個人を特定する情報(氏名・住所・電話番号・メールアドレスなど)や機密性の高い情報(パスワード銀行口座情報・マイナンバーなど)の共有を避けましょう。

特に重要な情報は匿名化するか、そもそも入力しない事が重要です。

例えば、シンガポールのセキュリティー企業であるGroup-IBは2023年6月中旬、「ChatGPTのアカウント10万件超がダークウェブの闇市場で取引されている」と発表しました。

アカウントが盗まれている最大の理由はChatGPTに入力された機密情報にあります。

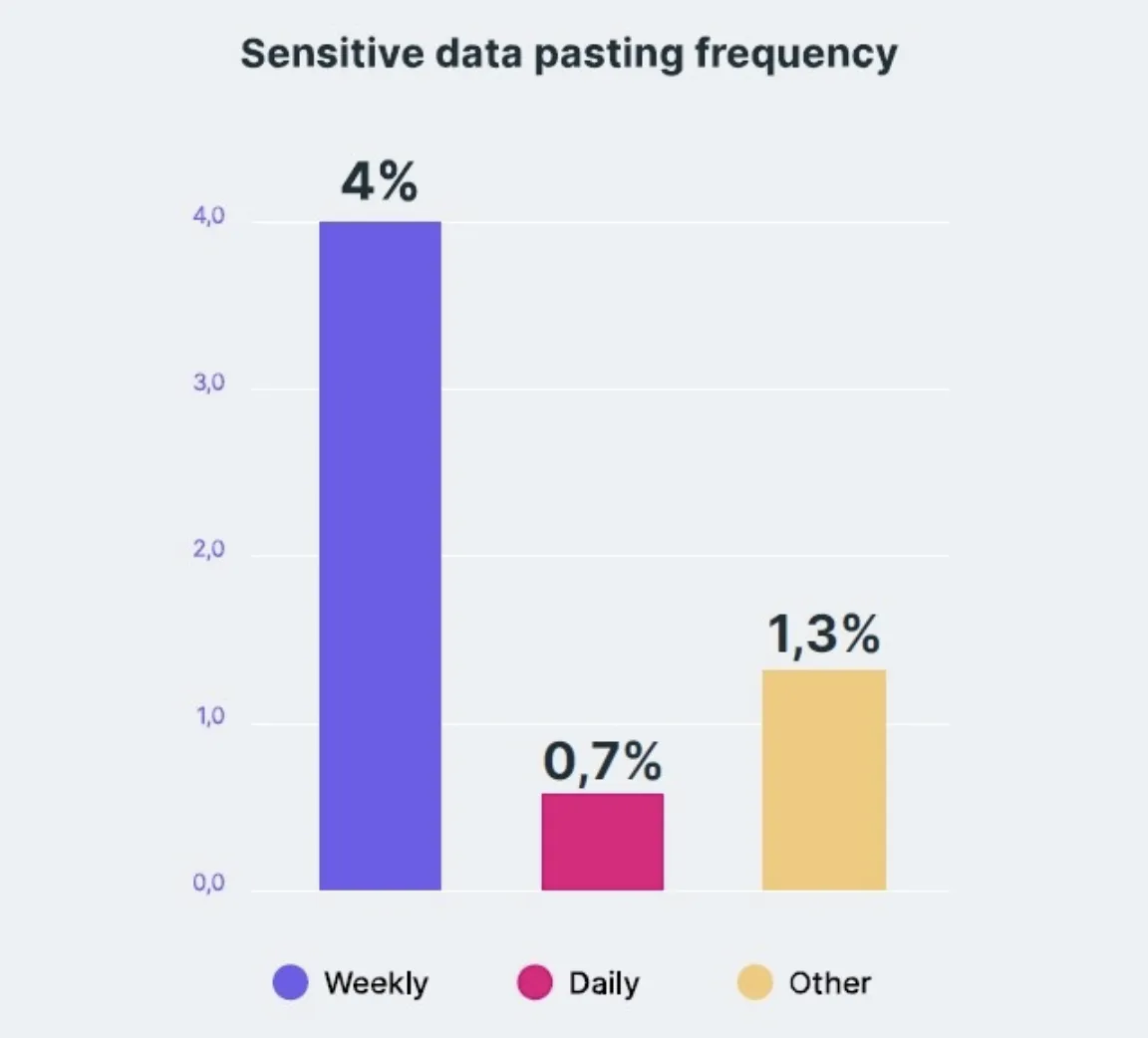

また、Webブラウザーのセキュリティーツールなどを提供するイスラエルのLayerX(レイヤーX)は同社のツールを使用している1万人のユーザーを対象に調査したところ、全体の6%がChatGPTに機密情報を入力したことがあると発表しており、全体の4%は週に1回程度、0.7%については週に何回も入力しているとの結果を示しています。

ChatGPTに機密情報を入力したことがある人の割合 (参考:米LayerX)

機密情報を入力しないよう気をつけることは勿論、入力してしまった場合に備えて会話を保存しない為の設定をすること(オプトアウト設定)も重要です。

【関連記事】

➡️ChatGPTのオプトアウトとは?入力データを学習させない為の設定方法

2. 安全なインターネット接続を使用する

公共のWi-Fiなど、セキュリティが不確かなインターネット接続を使用してChatGPTにアクセスする際は特に注意が必要です。

フリーWi-Fiは通信内容が暗号化されておらず、SNSやメールを覗き見されたり、閲覧しているWebサイトの履歴を窃取されたりするリスクが高まります。

VPNを利用することでデータの暗号化を強化し、安全な接続を確保することが大切です。

3. 適切なガイドラインの制定

ChatGPTを有効に活用するには、その特性を理解し、適切な利用方法を心がける必要があります。ChatGPTは、あくまでも補助的なツールであり、最終的な判断は人間が行うべきです。

また、プライバシーに配慮し、機密情報を入力しないよう注意が必要です。ChatGPTとのやり取りが公開される可能性があることを念頭に置き、発言内容にも気をつけましょう。

4. データ損失防止(DLP)製品の導入

DLPはデータの移動を監視し、データの保存場所を特定し、データの使用を制御することで、組織のデータ保護ポリシーの遵守を支援します。

| 項目 | 説明 |

|---|---|

| 機密情報の保護 | 機密データや個人識別情報(PII)、知的財産、財務情報などの不正な外部への送信を防止 |

| コンプライアンスの遵守 | HIPAA(健康情報のプライバシー保護)、GDPR(一般データ保護規則)、PCI-DSS(クレジットカード情報のセキュリティ基準)などの規制要件の遵守を支援 |

| 内部脅威からの保護 | 意図的または偶発的な内部からのデータ漏洩防止。(従業員が不適切な方法でデータを共有することを含む) |

| データの可視化と制御 | 組織内で生成、処理、保存されるデータの流れを理解し、不正なデータの移動を検出 |

5.API(Application Programming Interface)の活用

OpenAIはAPIで提供するコンテンツまたは受領したコンテンツをサービスの開発などに利用しないことを利用規約に明記しています。

しかし、APIを介したChatGPTの利用においても、最終的にはユーザーがChatGPTに入力する情報の管理が重要になります。機密情報や個人識別情報をAPIリクエストに含めない、あるいは必要な場合には適切に匿名化するなどの対策が必要です。

OpenAIの取り組み

OpenAIは、ChatGPTのセキュリティとプライバシー保護に取り組んでいます。

ユーザーの個人情報を適切に管理し、不正アクセスや情報流出を防ぐためのセキュリティ措置を講じています。

また、有害なコンテンツや違法な情報を検知し、フィルタリングする仕組みの導入や、AIの倫理的な利用を促進するため、ガイドラインの策定や研究開発にも力を入れています。

以下は、セキュリティとプライバシー保護のためにOpenAIが実施しているいくつかの対策です。

- データ暗号化

OpenAIは、正アクセスによるデータの漏洩や改ざんを防ぐためにデータの暗号化を行っています。これには、伝送中のデータ(SSL/TLSを使用)と保存されているデータの両方が含まれます。

- アクセス制御

APIキーを含む認証メカニズムを通じて、ChatGPTへのアクセスを厳格に管理しています。これにより、承認されたユーザーのみがサービスにアクセスできるようになっています。

- 使用量の監視と制限

不正利用や異常なアクセスパターンを検出するために、APIの使用量を監視しています。必要に応じて、使用量の制限を設けることで、サービスへの攻撃を防いでいます。

- プライバシーポリシーと利用規約

OpenAIは、ユーザーがサービスを安心して使用できるよう、プライバシーポリシーと利用規約を提供しています。

これにより、どのようなデータが収集され、どのように使用されるかが明確にされています。

- コンプライアンスと監査

GDPRやCCPAなどのデータ保護規制に準拠するための対策を講じており、定期的にセキュリティ監査を受けています。

ChatGPTのセキュリティリスクに立ち向かうためには、利用者、組織、開発者が協力し、それぞれの立場で適切な対策を講じることが不可欠です。

技術的対策と人的対策を組み合わせ、AIシステムの安全性と信頼性を高めていくことが、ChatGPTをはじめとするAI言語モデルの健全な発展につながるでしょう。

まとめ

この記事を通じて、ChatGPTの利用がもたらす潜在的なセキュリティリスクと、それに対処するための企業や個人が取り組むべき対策について深く理解していただけたことと思います。ChatGPTは便利なツールですが、その使用には誤情報の拡散リスク、著作権違反の可能性、機密情報の漏洩といったいくつかのセキュリティ上の懸念が伴います。

最終的に、ChatGPTをはじめとするAIツールのセキュリティとプライバシーを守るためには、利用者一人ひとりの意識と行動が重要です。OpenAIもセキュリティとプライバシー保護のための取り組みを続けていますが、利用者自身もリスクを認識し、適切な対策を講じることで、ChatGPTを安全に有効活用していきましょう。