この記事のポイント

推論モデルは、学習済みAIを活用し、新たなデータから予測や意思決定を行う技術

学習モデルが知識獲得、推論モデルは既存知識で高速予測と役割が異なる

入力データ、推論エンジン(学習済みパラメータ)、出力結果が構成要素

OpenAIのoシリーズ, AnthropicのClaude 3.7, GoogleのGemini 2.0等が代表例

AIチャット、画像/音声認識、自動運転など幅広い分野で活用

Microsoft MVP・AIパートナー。LinkX Japan株式会社 代表取締役。東京工業大学大学院にて自然言語処理・金融工学を研究。NHK放送技術研究所でAI・ブロックチェーンの研究開発に従事し、国際学会・ジャーナルでの発表多数。経営情報学会 優秀賞受賞。シンガポールでWeb3企業を創業後、現在は企業向けAI導入・DX推進を支援。

AI技術が急速に進化する中で、「学習済みモデル」という言葉はよく耳にするようになりました。

しかし、「学習済みモデル」と「推論モデル」の違い、そして「推論モデル」が具体的にどのような場面で役立つのか、明確に理解している人は多くないのではないでしょうか。

AIの導入を検討している企業にとって、推論モデルの理解は不可欠です。なぜなら、推論モデルこそが、AIの真価を発揮し、ビジネスに具体的な価値をもたらす鍵となるからです。

本記事では、この「推論モデル」に焦点を当て、その仕組み、学習モデルとの違い、代表的なモデル、そして幅広い活用事例までを、徹底的に解説します。

推論モデルの基本を理解し、ビジネスへの応用のヒントを得て、AI活用の第一歩を踏み出しましょう。

推論モデルとは

近年、AI技術の発展に伴い、推論モデルの活用が幅広い分野で進んでいます。

推論モデルとは、事前に学習したAIを活用し、新たなデータに基づいて予測や意思決定を行う技術 です。

これにより、企業は業務の効率化や高度なデータ分析の実現が可能となります。

また、最新の推論モデルとして、OpenAIの「o1」や「o3」、Anthropicの「Claude 3.7 Sonnet」、Googleの「Gemini 2.0 Flash Thinking」などが登場しており、それぞれのモデルが異なる特徴を持ちながらも、高度な推論能力を提供しています。

推論モデルと学習モデルの違い

では、推論モデルと学習モデル(GPT-4シリーズなど)がどのように違いがあるのでしょうか。

| 項目 | 推論モデル | 学習モデル |

|---|---|---|

| 役割 | 既存の知識を使って予測 | 新しいデータを学習し、知識を獲得 |

| 処理速度 | 高速(リアルタイム対応) | 計算負荷が大きく時間がかかる |

| 必要な計算資源 | 少なめ(エッジデバイスでも動作) | 大規模な計算リソースが必要(クラウド・GPU) |

| 推論精度 | 複雑な問題でも高精度な解決が可能 | 単純なパターン認識は得意だが複雑な推論は苦手 |

| 適したタスク | 数学、コーディング、論理的分析 | テキスト生成、画像認識、分類タスク |

| コスト構造 | 初期実装コストは高いが運用コストは低め | 継続的な学習には高コストが発生 |

推論モデルの仕組み

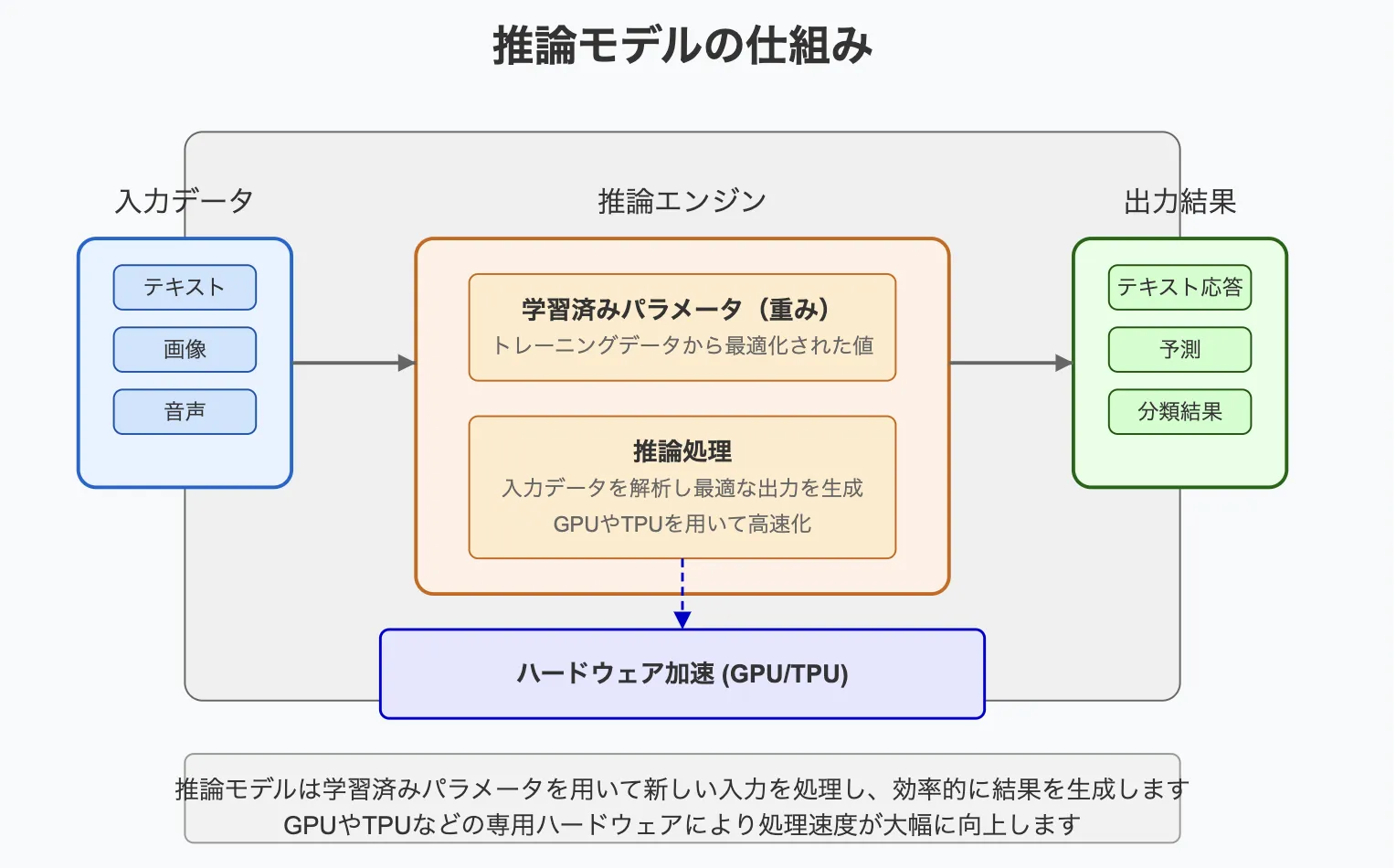

推論モデルの仕組み

上記のように、推論モデルは、AIがデータから答えや判断を導き出すための仕組みです。この過程をシンプルに説明すると次のようになります。

推論モデルは、私たちが入力したデータを受け取り、あらかじめ学習した知識を使って答えを出します。これは料理人が材料(データ)とレシピ(学習済みの知識)を使って料理(答え)を作るようなものです。

技術的基盤

推論モデルの多くは、トランスフォーマーアーキテクチャを基盤としていますが、通常のモデルと異なる点として以下の技術が組み込まれています:

- RLHF(Reinforcement Learning from Human Feedback):人間のフィードバックを基にした強化学習

- CoT(Chain of Thought):思考の連鎖を明示的に表現する推論手法

- ReAct:思考と行動を交互に行うフレームワーク

これらの技術により、モデルは単に答えを出すのではなく、どのように答えに至ったかという過程を明示できるようになっています。

三つの主要素

-

入力データ - モデルが処理する情報

- テキスト(質問文、文章など)

- 画像(写真、図など)

- 音声(話し言葉、音楽など)

-

推論エンジン - データを処理する頭脳部分

- 学習済みパラメータ(重み) - トレーニングによって獲得した知識

- 推論処理 - 入力を分析し最適な出力を計算するプロセス

-

出力結果 - モデルが生成する答え

- テキスト応答

- 予測や分類結果

- 問題解決のための提案

処理の高速化

推論モデルは膨大な計算を高速に行う必要があります。そのために以下のような技術を使っています。

- GPUやTPU - 特殊な計算チップを使用(これらは通常のコンピュータよりも並列処理に優れているため、AI計算に適しています)

- 量子化技術(Quantization) - モデルの精度を維持しながらサイズを縮小

- 推論最適化フレームワーク(TensorRT、ONNXなど) - 処理速度を向上させる専用ソフトウェア

実生活での例

推論モデルは、経験豊富な専門家のようなものです。医師が患者の症状(入力データ)を聞き、医学知識(学習済みパラメータ)を活用して、診断(出力結果)を行うのと同じです。

違いは、AIはこのプロセスを非常に高速に、大量のデータで実行できる点にあります。

推論モデルの魅力は、一度学習すれば何度でも活用でき、様々な種類の問題に対応できることです。私たちが日常的に使うAIアシスタントや画像認識、翻訳サービスなど、多くの便利なツールはこの仕組みで動いています。

代表的な推論モデル

以下は主要な推論モデルの比較です。

| モデル | 提供元 | 特徴 | ベンチマーク(MMLU) | 適したタスク | 料金感 |

|---|---|---|---|---|---|

| o1 | OpenAI | 高度な論理推論、高速処理 | 86.5% | 数学、コーディング | GPT-4の約1/10 |

| Claude 3.7 Sonnet | Anthropic | ハイブリッド推論、自然な対話 | 90.2% | 複雑な分析、文書作成 | Claude 3 Opusと同等 |

| Gemini 2.0 Flash | マルチモーダル推論 | 83.7% | 画像解析、データサイエンス | 要問合せ |

OpenAI「oシリーズ」

- 数学やプログラミングなどの論理的思考タスクに特化

- 高速かつ低コストで利用可能

- 「チェイン・オブ・ソート(Chain of Thought)」手法を活用し、高精度な推論を実現

【関連記事】

o1のシステムカード

Anthropic 「Claude 3.7 Sonnet」

- 迅速な応答と深い推論を両立した「ハイブリッド推論モデル」

- ユーザーのニーズに応じて、素早い回答と深い考察を切り替え可能

Google「Gemini 2.0 Flash Thinking Experimental」

- プログラミング、数学、物理学などのマルチモーダルタスク向け

- 思考過程を説明する推論機能を搭載

このように、今までのモデルより、より深くモデル自体が思考することが特徴です。

推論モデルの活用例

-

AIチャット(ChatGPT, Claude, Gemini)

- 自然言語処理による質問応答や文章生成

- 自然言語処理による質問応答や文章生成

-

画像認識(医療診断, セキュリティ監視)

- レントゲン画像の解析や不審者検知

- レントゲン画像の解析や不審者検知

-

音声認識(スマートスピーカー, 字幕生成)

- 音声コマンドの認識やリアルタイム字幕生成

-

DeepRerearch

各生成AIサービスが推論モデルを利用したデータの収集、まとめに生成AIを活用しています。

まとめ

- 推論モデルは、学習済みのAIを活用し、新しいデータに対してリアルタイムで予測・判断を行う技術です。

- 最新の推論モデルとして、OpenAIの「o3-mini」、Anthropicの「Claude 3.7 Sonnet」、Googleの「Gemini 2.0 Flash Thinking Experimental」などが登場しています。

- 今後、軽量化や精度向上、マルチモーダルAIの進化が期待されるでしょう。

AI総合研究所では、企業のAI活用を研修、開発、伴走支援と一気通貫で支援しています。お気軽にご相談ください。