この記事のポイント

AI性能向上に資する新技術「TensorRTモデルオプティマイザ」の発表について見ていきます。

推論過程を高速化し、AIモデルの効率を改善する技術が導入されています。

監修者プロフィール

坂本 将磨

Microsoft AIパートナー、LinkX Japan代表。東京工業大学大学院で技術経営修士取得、研究領域:自然言語処理、金融工学。NHK放送技術研究所でAI、ブロックチェーン研究に従事。学会発表、国際ジャーナル投稿、経営情報学会全国研究発表大会にて優秀賞受賞。シンガポールでのIT、Web3事業の創業と経営を経て、LinkX Japan株式会社を創業。

AIの推論性能を向上させ、実用化への道を進むNVIDIAが新たな一手を打ち出しました。

「TensorRTモデルオプティマイザ」と名付けられたこの革新的なツールは、AIモデルがよりスピーディかつ効率的に機能することを目指して設計されています。

複数の技術を駆使してAIのレスポンスを高速化することで、言語の翻訳や画像生成といったタスクを、これまで以上に迅速かつ精確にこなすことが可能となるでしょう。

この記事では、NVIDIAの先端技術がどのように推論パフォーマンスを改善するのか、またそれが産業界にどのようなインパクトを与えるのかについて、具体的な情報をお届けします。

NVIDIA TensorRTモデルオプティマイザ:AI推論パフォーマンスを向上

NVIDIAは、人工知能(AI)のモデルがより速く、より効率的に動作するようにするための新しいツール「NVIDIA TensorRTモデルオプティマイザ」を発表しました。

このツールは、AIの学習結果を実際に使う「推論」という段階での性能を上げるために設計されています。

量子化(データを単純化すること)やスパーシティ(データの中から重要な情報だけを取り出すこと)などの技術を使って、AIモデルを最適化します。

これにより、特に大きなAIモデルでも速く正確に動作するようになります。例えば言語を翻訳したり、絵を描くAIがより上手になります。

NVIDIAの最適化技術がもたらす進化

NVIDIAの新しいモデルオプティマイザは、AIがより少ない情報で学習できるようにする「Quantization Aware Training(QAT)」という機能を持っています。

これは、AIが推論をする際に必要なデータの量を減らしながらも、その精度を保つ技術です。

また、将来登場するNVIDIAのBlackwellプラットフォームをはじめとするする、先進的なAI推論プラットフォームにも対応しています。

「スパースモデル」という技術も使え、これによりAIは必要な情報だけを上手に見つけ出すことができ、その結果、より速く動作するようになります。

モデルオプティマイザは、これらの最適化技術を簡単に組み合わせられるようにする為のAPI機能も提供しており、エンジニアがAIモデルを自由にカスタマイズできるようになっています。

NVIDIAの進化を支えるエンジニアチームと資源

このモデルオプティマイザは、ディープラーニングやAI推論技術の進化を目指してNVIDIAのエンジニアチームが開発しました。

チームは、OmniML社の買収によって加わった、学術界や業界で経験を持つトップクラスのメンバーによって構成されています。彼らの専門知識と経験が、NVIDIAのAI技術をさらに進化させる原動力となっています。

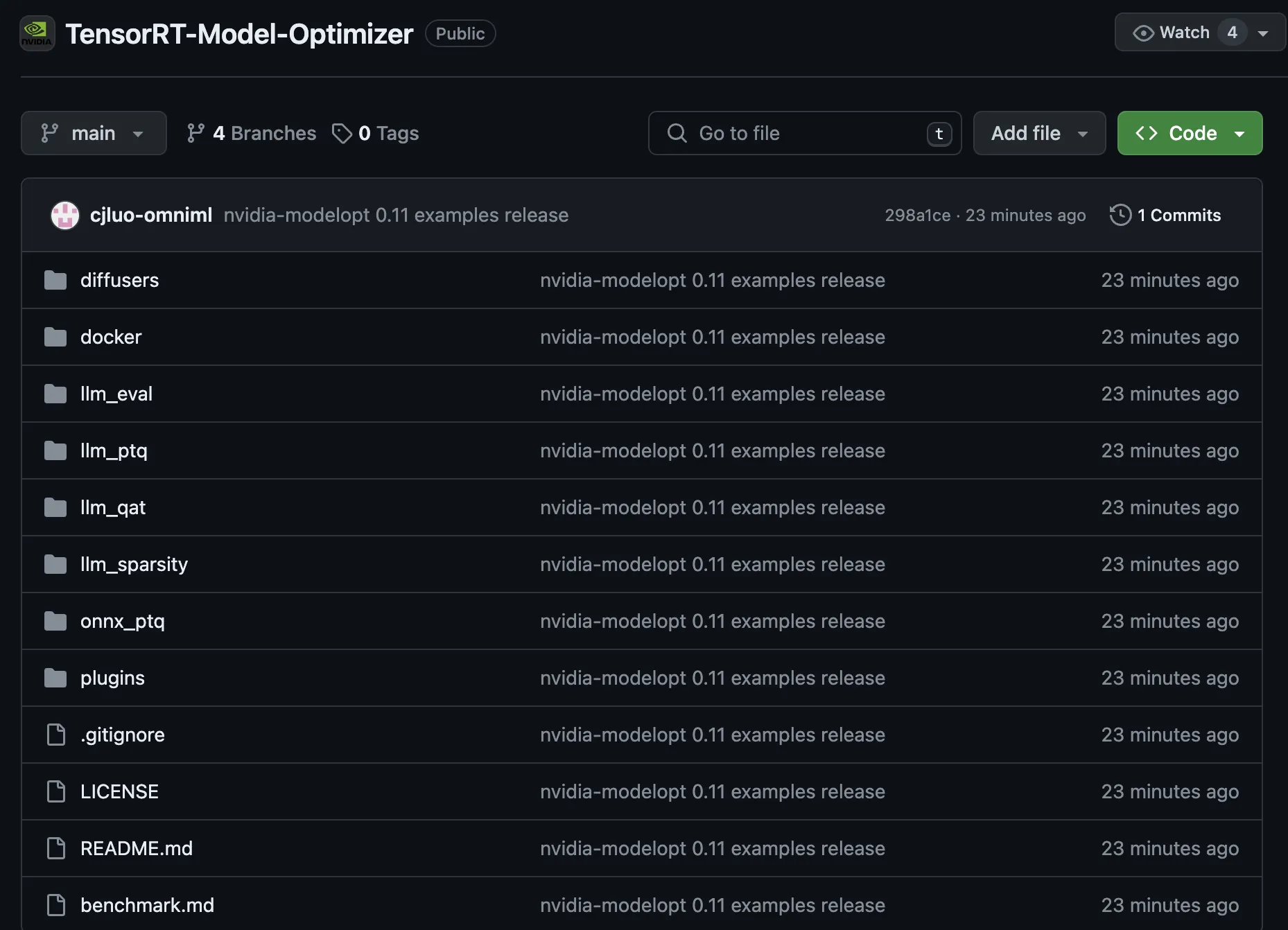

このツールは、NVIDIAのPyPIやGitHubを通じて誰でもアクセスでき、使い方についての詳しい説明書(ドキュメント)も提供されています。

TensorRTのリポジトリ

出典:NVIDEA