この記事のポイント

Ironwoodは、Googleが開発した第7世代TPUで、AI推論処理に特化

最大9,216チップ構成で42.5エクサフロップスの計算性能を誇る

推論向けアーキテクチャと高速インターコネクトで低遅延な応答を実現

高度な液体冷却を採用し、前世代比で約2倍の電力効率を達成

Google Cloudを通じて提供され、NVIDIAに依存しないAIインフラ戦略を支える

Microsoft MVP・AIパートナー。LinkX Japan株式会社 代表取締役。東京工業大学大学院にて自然言語処理・金融工学を研究。NHK放送技術研究所でAI・ブロックチェーンの研究開発に従事し、国際学会・ジャーナルでの発表多数。経営情報学会 優秀賞受賞。シンガポールでWeb3企業を創業後、現在は企業向けAI導入・DX推進を支援。

AI推論の高速化と効率化が求められる中、Googleが自社開発するTPU(Tensor Processing Unit)の最新世代「Ironwood」を発表しました。

GPUとは何が違うのか? なぜGoogleは独自のAIチップを開発し続けるのか? その驚異的な性能と電力効率の秘密に迫ります。

本記事では、このGoogleの最新TPU「Ironwood」について、基礎から徹底的に解説します。

Ironwoodの概要、前世代TPUやGPUとの違い、6つの主要な特徴、Google Cloudでの提供方法、そしてNVIDIA GPUとの競争におけるGoogleの戦略まで、幅広く網羅的に説明します。

Ironwoodとは?Googleが開発した第7世代TPU

Ironwoodイメージ

Ironwood(アイアンウッド)は、Googleが自社開発した第7世代のTPU(Tensor Processing Unit)です。従来のTPUよりも推論処理に特化しており、AIモデルの高速・低遅延な推論を実現します。

2025年4月開催の「Google Cloud Next」で発表され、特に生成AIやLLM(大規模言語モデル)の運用を加速させる基盤として注目を集めています。

TPUとは?Googleが開発したAI専用チップ

TPU(Tensor Processing Unit)は、GoogleがAI処理のために独自開発した専用プロセッサです。主に 深層学習(ディープラーニング) における行列演算に特化しており、GoogleのクラウドサービスやAIアプリケーションの裏側で活用されています。

初代TPUは2015年に登場し、以降は訓練(トレーニング)や推論(インフェレンス)向けに最適化されたバージョンが進化を続けています。

初代TPUイメージ

TPUとGPUの違いは?

これまでAIの計算処理といえば「GPU(Graphics Processing Unit)」が中心でしたが、GoogleはよりAI処理に特化した「TPU(Tensor Processing Unit)」を独自開発し、自社クラウドに組み込んで提供しています。その違いはなんでしょうか。

以下に、TPUとGPUの主な違いをまとめました。

| 観点 | GPU | TPU |

|---|---|---|

| 開発元 | NVIDIAやAMDなど | |

| 設計目的 | グラフィックス/並列計算汎用 | AIモデルの行列演算専用 |

| 用途 | 画像処理、ゲーム、AI学習も可能 | AIの訓練・推論に特化 |

| 柔軟性 | 汎用性が高くさまざまな用途に使える | 特定タスクに最適化されて高速・省電力 |

| 提供形態 | GPUカードとして市販 | Google Cloud経由のみ(現時点) |

GPUは汎用的で多用途に使える一方、TPUは「AI専用」であり、Googleのクラウドでしか利用できない点が最大の違いです。

「Ironwood」の主な特徴6選

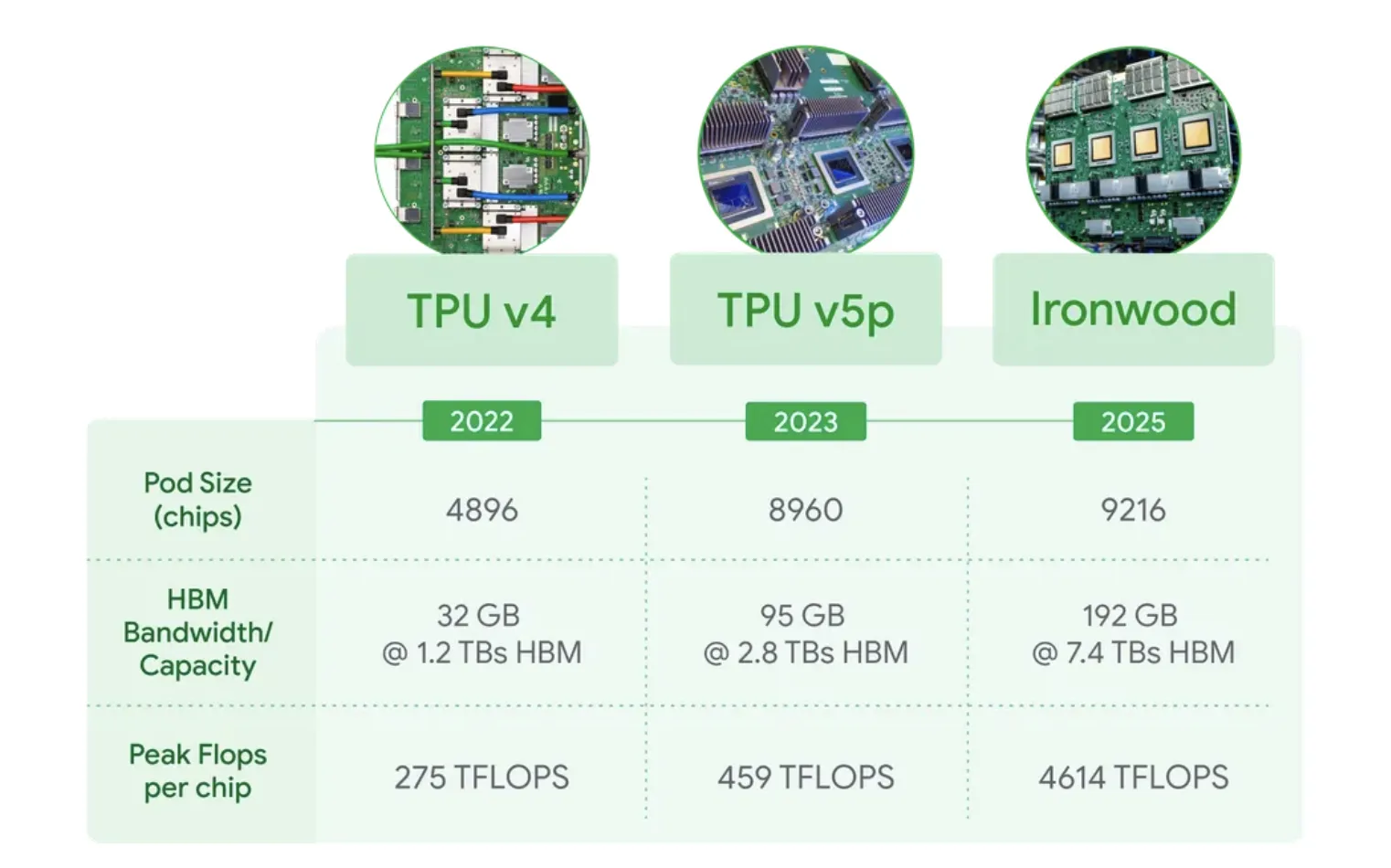

「Ironwood」の性能比較

以下の点で、前世代のTPU(Trillium / TPU v6)や他社GPUと比較して、圧倒的な性能と効率を誇ります。

1. 世界最大規模のAI性能を支えるスケーラビリティ

- Ironwoodは、最大9,216個のチップをまとめて1つのシステムとして動かすことができます。

- この構成で得られる計算性能は42.5エクサフロップス(1秒間に約42垓回の計算)で、世界最大のスーパーコンピュータ「El Capitan」の約24倍に相当します。

- 単体のチップでも4,614TFLOPSという超高性能を誇ります。

※身近な例にすると、スマホやノートPCの1000倍以上の計算力を1チップで持っているようなイメージです。

2. 推論時代に最適化された新アーキテクチャ

- Ironwoodは、ChatGPTのような**「考えて答えるAI(=思考モデル)」**を高速に処理するために設計されています。

- AIが回答を出すまでのデータの受け渡しを効率化し、待ち時間(レイテンシ)を減らしています。

- チップ同士の通信速度も1.2Tbps(テラビット毎秒)に強化され、大規模なAIモデルの分散処理が高速化されました。

たとえば、複雑な質問にリアルタイムでAIが答えるような処理を、従来よりずっと速く、正確に実行できます。

3. 電力効率は従来の約2倍、空冷の約2倍のパフォーマンス

- Ironwoodは、前世代のTrilliumと比べて同じ電力で約2倍の計算能力を発揮します。

- 高度な液体冷却システムによって、発熱を抑えながら安定して動作できるようになりました。

- 初代TPUと比べると約30倍も電力効率が向上しており、環境負荷の面でも優れています。

AIの計算処理には莫大な電力が必要になりますが、Ironwoodは環境負荷とコストの両方に配慮した設計です。

4. 圧倒的なメモリ容量と帯域幅

- Ironwoodの各チップには、192GBの超高速メモリ(HBM)が搭載されており、これは従来の6倍の容量です。

- また、メモリへのデータの出入りを表す「帯域幅」も7.2Tbpsと、従来の4.5倍に強化されています。

AIモデルが大きくなるほど、処理するデータも増加します。大容量・高速なメモリは、高精度なAIを動かすために不可欠です。

5. SparseCore搭載でレコメンドや科学計算も加速

- Ironwoodには、**SparseCore(スパースコア)**という専用ユニットが搭載されており、レコメンドエンジンや科学技術計算に使われる特殊な演算にも対応。

- 複雑で膨大な「エンベディング処理」(ユーザーやアイテムの特徴ベクトル化)も高速にこなせます。

これはYouTubeやNetflixの「あなたへのおすすめ」や、気候・金融などのシミュレーションにも使われます。

6. Pathwaysで数万チップの分散推論も簡単に

- Googleの機械学習ランタイム「Pathways」により、Ironwoodは数万個のチップを束ねて効率的に処理できます。

- これにより、1つのAIモデルを複数のチップで同時に動かし、処理時間を短縮しつつ精度を高めることが可能です。

AIモデルが大規模化しても、全体をまとめて管理できるため、大手企業や研究機関でも扱いやすい構成になっています。

このようにIronwoodは、単なる「高速なチップ」ではなく、現代のAIが直面する膨大な計算・通信・電力の課題を総合的に解決するための専用設計になっています。

Ironwoodはどこで使える?搭載製品と提供方法

Ironwoodは単体製品として販売されるわけではなく、Google CloudのAIインフラに組み込まれて提供されます。企業ユーザーは、Google Cloud経由でIronwoodの計算リソースを利用できるようになります。

2025年後半より一般提供開始予定で、Gemini 2.5やAlphaFoldなどのモデルもすでにIronwood上で稼働中です。

今後、以下のようなサービスで活用される予定です。

- Vertex AI(Google CloudのAIサービス)

- Gemini など、GoogleのLLM実行基盤

- パートナー企業向けAIソリューション

活用事例・ユースケース

Ironwoodは、特に以下のような高負荷・高速処理が求められるユースケースで力を発揮します:

-

大規模言語モデル(LLM)のリアルタイム応答

たとえば、AIチャットボットや検索エンジンなどで即時応答を実現。 -

Mixture of Experts(MoE)モデルの推論処理

モデルの一部のみを動的に選んで処理するMoE構成の効率的運用をサポート。 -

リアルタイム分析・レコメンド

ECサイトや動画サービスにおけるパーソナライズされたレコメンドにも対応。

NVIDIA一強の時代と、Google TPUの立ち位置は?

GeminiとTPU

現在のAI開発・運用において、NVIDIAのGPUは“ほぼ一強” とも言える圧倒的な存在感を持っています。生成AIブームを受けて、B200やH200といったハイエンドGPUは世界中のデータセンターに導入され、OpenAI、Meta、Microsoftをはじめとする大手企業の基盤を支えています。

その理由は、NVIDIAが長年にわたりハードウェア(GPU)とソフトウェア(CUDA、TensorRTなど)を一体で最適化してきたからです。開発者にとって、NVIDIAは「動かすのが簡単」で「情報が豊富」なプラットフォームでもあります。

しかし、この状況に風穴を開けようとしているのが、Googleの TPU(Tensor Processing Unit) でしょう。

GoogleがNVIDIAに頼らないことが意味する“本当の強さ”

OpenAIやMetaなどの大手企業は、NVIDIAのGPUを使ってAIモデルを訓練・推論していますが、Googleは自社開発のTPUを使うことで、以下のような独自の強みを持っています。

1. サプライチェーンの独立性

NVIDIAのGPUは非常に人気が高いため、供給不足や価格高騰がたびたび起こっています。

GoogleはTPUを自社設計 × 自社クラウドで提供しているため、他社の供給状況に依存せず、AIリソースを安定的・大規模に確保できるのです。

☑️ AIを動かす計算資源=「戦略資産」。それを自社で持てることが、長期的な差別化になります。

2. クラウドとAI基盤の“縦の統合”

Googleは、TPUの設計から、AIモデル(Geminiなど)、そして提供するクラウド(Google Cloud)までを一気通貫で最適化できます。これはNVIDIAベースのクラウド(AWSやAzure)では難しい芸当です。

この「縦方向の統合」は、AppleのiPhoneと同じように、性能・効率・セキュリティ・コスト面ですべてを制御できるという意味で、Googleにとって圧倒的な武器となっています。

3. AIの“自社運用”に最適化されている

たとえばChatGPTのようなLLMを運用するには、GPU数万枚規模の演算資源が必要になります。

Googleは、TPUポッド(最大9,216チップで42.5 ExaFLOPS)という世界最大級のAIインフラを自前で構築しており、NVIDIAに依存せずとも自社のAI製品をスケールできます。

つまりGoogleは「GPU買えなくても困らない」という、世界でも数少ないテック企業なのです。

このような独自の強みを持つGoogleは、TPUを通じて独自のAIエコシステムを構築していくでしょう。

まとめ

Googleの新型TPU「Ironwood」は、生成AI時代の推論処理を支える中核技術として登場しました。大規模な処理能力、高いエネルギー効率、そしてクラウド提供によるスケーラビリティの高さは、今後のAI活用における強力な武器となるでしょう。

今後のGoogle Cloudでの展開に注目が集まります。

AI総合研究所は、企業のAI活用を支援するため、最新の技術情報や活用事例を提供しています。お気軽にお問い合わせください。