この記事のポイント

ローカルLLMは、クラウドではなくPCや自社サーバーで動作する大規模言語モデル

データの完全なコントロールが可能で、機密情報も安全に扱える

通信遅延なしの高速応答、API利用料不要で長期的なコスト削減も実現

導入には、GPU/CPU、大容量メモリ、実行環境(Ollama等)の構築が鍵

モデル圧縮・量子化技術の進展で、ローカルLLMのエッジデバイスへの展開も加速

Microsoft MVP・AIパートナー。LinkX Japan株式会社 代表取締役。東京工業大学大学院にて自然言語処理・金融工学を研究。NHK放送技術研究所でAI・ブロックチェーンの研究開発に従事し、国際学会・ジャーナルでの発表多数。経営情報学会 優秀賞受賞。シンガポールでWeb3企業を創業後、現在は企業向けAI導入・DX推進を支援。

クラウド上のAIサービスが主流となる中で、「データは手元に置きたい」「外部ネットワークに依存せずAIを使いたい」というニーズが高まっています。

しかし、大規模言語モデル(LLM)を自前で動かすには、高度な知識や多大なコストがかかる、と諦めていませんか?その解決策となるのが「ローカルLLM」です。

本記事では、この「ローカルLLM」について、基礎から応用までをわかりやすく解説します。

ローカルLLMの仕組み、メリット・デメリット、必要なハードウェア、主要なフレームワーク、そして今後の展望まで、幅広く網羅的に説明します。

目次

ローカルLLM とは

ローカル LLMとクラウドLLMの比較

ローカル LLM(Large Language Model)とは、クラウド環境ではなく、PCやオンプレミスサーバーなどのローカル環境で稼働する大規模言語モデルを指します。

インターネット接続を必要とせず、データをすべて手元で完結できるのが特徴です。これにより、プライバシーの確保や特定用途への最適化といった利点を得ることができます。

実行方法としては、

- GPUを活用した高速推論(CUDA対応のNVIDIA GPUなどを使用)

- CPUのみでの軽量推論(GGUF形式を利用した量子化モデルを実行)

などがあり、リソースに応じて柔軟に選択できます。

また、実行用のツールとしては、Ollama、LM Studio、Text Generation Web UIなどが代表的です。

ローカルLLMのメリット

ここでは、ローカル LLMを導入する際の主なメリットを詳しく解説します。

1. プライバシーの確保

ローカルでのLLM運用は、データがインターネットを経由しないため、外部への情報漏洩リスクを大幅に低減できます。

機密情報を扱う企業や研究機関にとっては、社外流出を防ぐうえで非常に重要なポイントです。

2. 応答速度の向上

クラウド経由だとネットワーク遅延が発生しがちですが、ローカル環境なら通信時間がほぼゼロのため、リアルタイム性が求められるアプリケーションでも高速応答が期待できます。

3. コスト削減

クラウドのLLMサービスは、API使用料やリクエストごとの課金が積み重なる傾向にあります。

一方、ローカルLLMであれば、初期コスト(GPUやサーバーなどのハードウェア導入費用)はかかるものの、長期的にはランニングコストを大幅に抑えられます。

4. カスタマイズの自由度

クラウドベンダーのサービスでは提供されない細かな設定やチューニングが、ローカルなら自由に行えます。

自社の業務データやドメイン特化型のデータセットを用いたファインチューニングによって、独自色の強いモデルを作り上げることが可能です。

ローカルLLMの課題

一方で導入にはどのような課題があるでしょうか。

- ハードウェアの初期投資

GPUや大容量メモリなどを揃える必要があり、初期コストが高くなる場合がある

- モデルの更新・管理

バージョンアップやセキュリティパッチを自社で追随・適用する手間

- 環境構築の難易度

OSやライブラリのバージョン整合など、導入時の設定に手間がかかる

このように運用や実装をする技術者がいるかどうかは大きな課題となります。

ローカルLLMの実装に必要なハードウェア

ローカル LLM の実装に必要なハードウェア

ローカルでLLMを実行するには、ある程度の計算リソースが求められます。代表的なものを挙げると、以下のとおりです。

-

GPU(グラフィックボード)

- LLMのトレーニング・推論を効率的に行うために不可欠

- NVIDIAのA100/V100、RTX 3090/4090などが代表例

-

CPU(中央処理装置)

- GPUが利用できない場合でも、量子化モデル(GGUF形式など)ならCPUのみで推論を実行可能

- 大規模な推論では高性能CPUを推奨

-

RAM(メモリ)

- モデルサイズに応じて16GB~128GB以上が必要

- GPUメモリだけでなく、システムRAMの容量も重要

【関連記事】

➡️生成AI向けPC22選!用途別のおすすめパソコン・選び方を徹底解説

おすすめのローカルLLM

ローカルLLMの運用においては、オープンソースのモデルを活用するケースが一般的です。以下のようなモデルが近年注目を集めています。

| モデル名 | 開発元 | パラメータ規模 | 特徴 |

|---|---|---|---|

| Llama 3 | Meta社 | 80億 / 700億 | 商用利用可能、高性能で多用途 |

| Gemma 2 | Google社 | 9億 / 27億 | 軽量かつ高性能、推論時の最適化がしやすい |

| DeepSeek-R1 | DeepSeek | 不明 | 日本語向け、特定タスクに最適化 |

| Mistral 7B | Mistral社 | 70億 | 小型ながら高性能を実現 |

| Mixtral | Mistral社 | 120億 | Mixture of Experts(MoE)構造を用いて複数専門モデルを組み合わせ |

| Phi-3 | Microsoft | 小規模(不明) | リソースの限られた環境向け、サイズは小さいが高精度 |

ローカルLLMの実行方法

ローカルLLMの実行は大きく分けて以下の2つのアプローチがあります。

- GPUを活用した高速推論

- CUDA対応のNVIDIA GPUを利用し、PyTorchやTensorFlowなどで高速な推論を実現

- ミドル〜ハイエンドGPUが必要になる場合が多い

- CPUでの軽量推論

- 量子化モデル(GGUFなど)を使ってメモリ占有を削減

- 高速性はGPUほどではないが、環境構築やコスト負担を抑えられる

ローカルでLLMを扱うための主要フレームワーク・ライブラリ

ローカルでLLMを扱うためのフレームワークやライブラリは複数存在します。

代表的なものを以下にまとめます。

-

LLama.cpp

- Meta社のLLaMAモデルを軽量かつ効率的に動かすC++ライブラリ

- CPU/GPUどちらでも動作可能

-

Ollama

- シンプルなCLIコマンドだけでローカルLLMのインストール・実行が可能

- 初心者でも導入が比較的容易

-

Hugging Face Transformers

- PyTorchやTensorFlowをベースに、多彩なLLMを簡単に実装できるライブラリ

- コミュニティが活発で、モデルの更新も頻繁

-

**Google Colab

-

Google Colab上でも、小~中規模のモデルなら「ローカル LLM的な動作」を実演可能です。

Google ColabでローカルLLMを使ってみた

では、実際にGoogle ColabでローカルLLMを使ってみましょう。

1. Notebookの準備

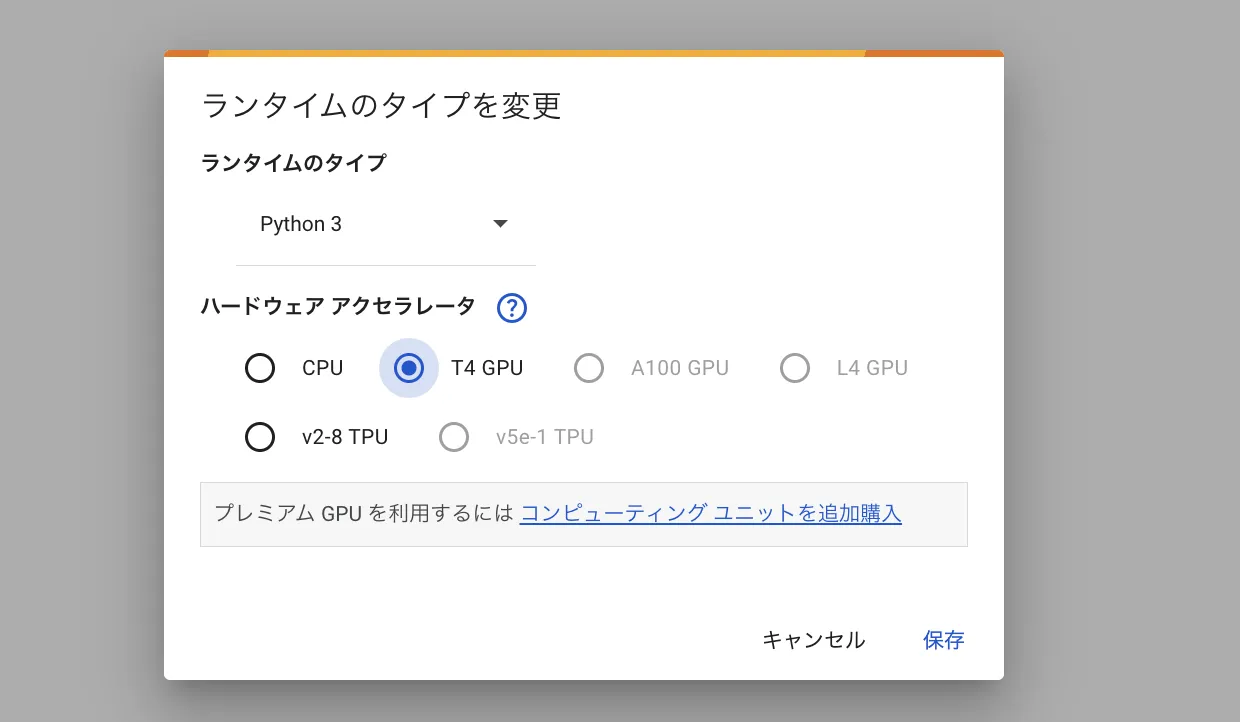

- Google Colabを開き、新しいノートブックを作成します。

- メニュー上部の「ランタイム」→「ランタイムのタイプを変更」をクリックし、ハードウェアアクセラレータを「GPU」 に設定します。

ランタイムのタイプを変更

2. ライブラリのインストール

Colabのセルに以下のコマンドを入力し、ライブラリをインストールします。

!pip install transformers accelerate einops

- transformers: Hugging Faceの高機能なモデル実装ライブラリ

- accelerate: 複数GPUや分散環境を簡単に扱えるライブラリ

- einops: 行列演算のユーティリティ(モデルによっては必要)

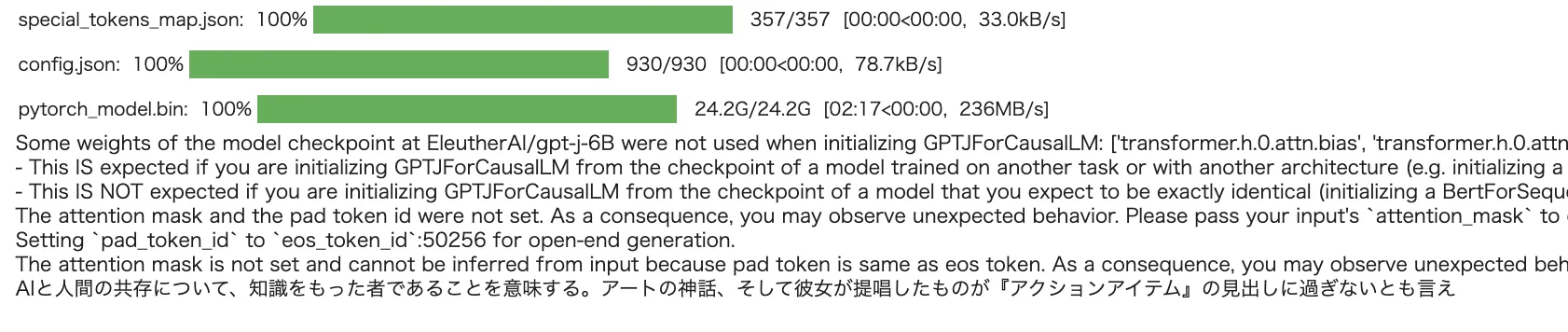

3. 小規模モデルのロード・推論

ここでは例として、比較的軽量なオープンソースモデル「GPT-J 6B」を使います。メモリが限られた環境でも動きやすいモデルです。

import torch

from transformers import AutoTokenizer, AutoModelForCausalLM

model_name = "EleutherAI/gpt-j-6B"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(model_name,

device_map="auto",

torch_dtype=torch.float16)

# 推論用のテキストプロンプト

prompt = "AIと人間の共存について、"

input_ids = tokenizer.encode(prompt, return_tensors="pt").to(model.device)

# 推論

with torch.no_grad():

output = model.generate(

input_ids,

max_length=100,

num_return_sequences=1,

no_repeat_ngram_size=2,

do_sample=True,

top_k=50,

top_p=0.95,

temperature=0.8,

eos_token_id=tokenizer.eos_token_id

)

# 出力結果の表示

print(tokenizer.decode(output[0], skip_special_tokens=True))

4. 実行と注意点

- セッション切断対策: Colabの無料プランでは一定時間操作しないとセッションがリセットされます。再現できるよう、モデルや生成データはGoogleドライブなどに定期的に保存しておきましょう。

- GPUの割り当て: 無料ユーザーは割り当てられるGPUや利用時間に制限があるため、大きすぎるモデル(例:70Bパラメータ級)を動かすのは難しい可能性があります。

- 速度・メモリ限界: ColabのTesla T4やP100では、推論速度や一度に処理できるトークン数に限りがあります。エラーになった場合はバッチサイズやトークン上限を下げて調整してください。

実演結果のイメージ

上記のスクリプトを実行すると、プロンプト(「AIと人間の共存について、」など)に対して、GPT-J 6Bによる続きのテキストが生成されます。

たとえば以下のような応答が得られるかもしれません(あくまでも一例です)。

出力イメージ

AIと人間の共存について、最も重要なのは相互理解と協力です。

人間は創造性や感情面で強みがある一方、AIは...

生成文の品質はモデルやハイパーパラメータ、プロンプトの工夫によって変わります。Colabで軽く試してみるだけでも、ローカルLLM的な挙動を体感できたのではないでしょうか。

ローカル LLM の今後の展望

今後、モデル圧縮や量子化技術のさらなる進歩により、より軽量なLLMが登場すると考えられます。これにより、エッジデバイスやモバイル端末への組み込みも一層進むでしょう。また、分散学習やメタラーニング技術の発展によって、少ないデータや限られたリソースでも高度にカスタマイズしたLLMを構築できるようになる可能性があります。

IoTやエッジデバイスなどに搭載され、ハードウェアでのAI活用が進むことが非常に楽しみです。

【関連記事】

➡️AIの蒸留(蒸留モデル)とは?その仕組みや実装例をわかりやすく解説!

まとめ

- ローカル LLMは、データをオンプレミスで管理しつつ大規模言語モデルの恩恵を受けられるアプローチ。

- メリットはプライバシーの確保、応答速度向上、コスト削減、カスタマイズ性など。

- 課題としては、初期投資の高さや管理運用の複雑さが挙げられる。

- 今後はモデル圧縮や量子化技術の進化により、より多様な環境への展開が期待される。

企業や研究機関で機密性の高いデータを扱う場合や、大規模な推論リクエストが想定されるプロジェクトでは、ローカル LLM の導入を検討する価値は十分にあるでしょう。クラウドとローカルのメリットを比較検討し、最適な運用スタイルを選びましょう。