この記事のポイント

この記事は、時系列データの処理に特化したAI技術であるRNNについて詳しく解説しています。

RNNは、過去の情報を記憶するループ構造を活用して、テキストや音声などのデータを高い性能で解析することができます。

RNNは、時系列データを扱う場面で効果的であり、テキスト生成や機械翻訳、音声処理などに利用されます。

構造的には、入力層、隠れ層、出力層から成り、時系列データのパターンを学習することが可能です。

これからAI開発に挑戦する方にとっては、必見の内容となっており、AIや深層学習技術のさらなる発展を象徴するトピックです。

Microsoft MVP・AIパートナー。LinkX Japan株式会社 代表取締役。東京工業大学大学院にて自然言語処理・金融工学を研究。NHK放送技術研究所でAI・ブロックチェーンの研究開発に従事し、国際学会・ジャーナルでの発表多数。経営情報学会 優秀賞受賞。シンガポールでWeb3企業を創業後、現在は企業向けAI導入・DX推進を支援。

「RNNって一体何?」と疑問を感じている方も少なくないかもしれません。特に、AIや機械学習の分野に初めて触れる方にとっては、RNNは聞き慣れない言葉かと思います。

本記事では、時系列データを扱う際に非常に有効なAI技術の一つであるRNN(再帰型ニューラルネットワーク)について、初心者の方にもわかりやすく解説します。

ニューラルネットワークやCNNとの違い、RNNが得意とするタスク、そしてその構造や種類、学習方法などを一つ一つ丁寧に説明します。

さらに、Pythonを用いたRNNの実装例や具体的な活用事例、そして将来の展望についても触れていきますので、AIテクノロジーの可能性を広げたい方はぜひ最後までご覧ください。

RNNとは

RNN(Recurrent Neural Network:再帰型ニューラルネットワーク)は、時間的な順序を持つデータを処理するために設計された特殊なニューラルネットワークです。

RNNは、過去の情報を「記憶」して利用します。通常のニューラルネットワークとは異なり、ループ構造を持っています。

このループにより、RNNは過去の情報を保持可能です。

そのため、RNNは以下のような時系列データを扱うタスクで特に威力を発揮します。

| タスク | 具体例 | RNNの強み |

|---|---|---|

| テキスト生成 | ・文章作成 ・プログラムコード生成 ・チャットボット |

・文脈の理解 ・一貫性の維持 ・自然な文章生成 |

| 機械翻訳 | ・文章翻訳 ・同時通訳 ・多言語変換 |

・語順の違いに対応 ・文脈を考慮した訳出 |

| 音声処理 | ・音声認識 ・話者識別 ・音声合成 |

・連続的な信号処理 ・音の特徴抽出 |

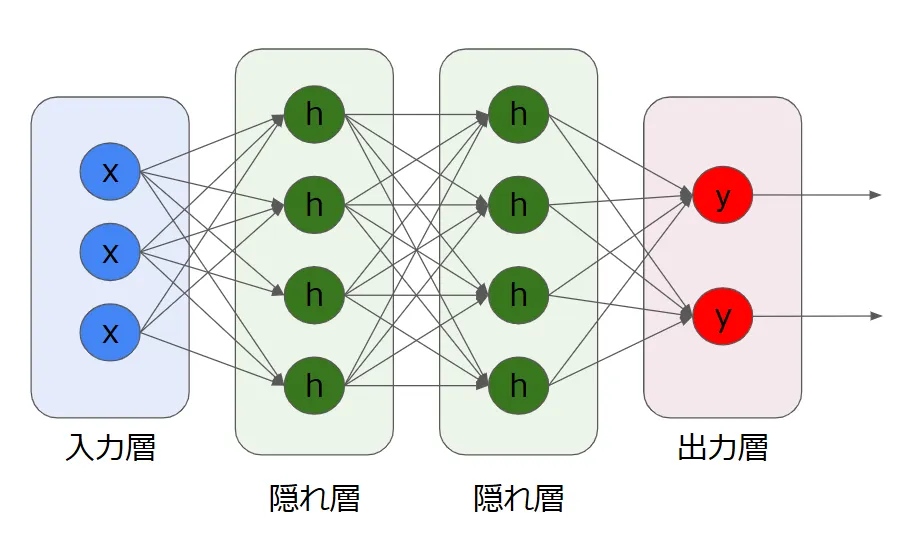

ニューラルネットワークとは

人間の脳の神経回路をまねた仕組みで、データを学習して「正しい答え」を出すモデルです。データを入力して計算を行い、何らかの結果を出力する「学習するアルゴリズム」といえます。

【仕組み】

- 入力(データ)を受け取り、層を通じて処理して結果を出します

- 一方向に処理を進めます(例: 入力 → 隠れ層 → 出力)

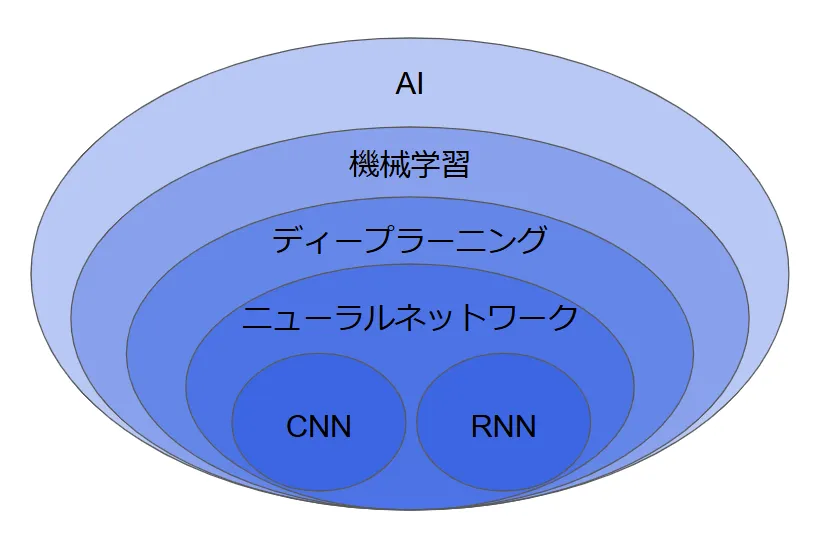

CNNとは

画像や空間情報を理解するために作られた、特別なニューラルネットワークです。画像認識や物体検出に強い理由は、画像の中の**「重要な部分」**を自動で学習する仕組みがあるからです。

【仕組み】

画像を小さな「部分(特徴)」に分けて、それを認識して処理します。

| 特徴 | ニューラルネットワーク | CNN(畳み込みニューラルネットワーク) | RNN(再帰型ニューラルネットワーク) |

|---|---|---|---|

| 目的 | 一般的なデータの処理 | 画像や空間情報の処理 | 時系列データや順序が重要なデータの処理 |

| 主な構造 | 全結合層(データを一方向に処理) | 畳み込み層・プーリング層+全結合層 | 再帰的に隠れ状態を持ちながら処理 |

| 入力データの例 | 数値や特徴量 | 画像データ | テキスト、音声、時系列データ |

| 情報の流れ | 一方向のみ | 層ごとに特徴を抽出 | 前のステップの情報を次に引き継ぐ |

| 得意な分野 | シンプルな分類や予測 | 画像認識、物体検出 | 翻訳、音声認識、予測変換 |

RNN・ニューラルネットワーク・CNNの比較

以上の情報を基に関係性をまとめると以下のようになります。

【関連記事】

AIや機械学習については以下の記事もチェック!

→生成AIとは?その種類や従来のAIとの違い、メリット・問題点を解説!

→機械学習とディープラーニングの違いをわかりやすく解説!

RNNの構造

RNNは特殊な構造を持つニューラルネットワークで、過去の情報を記憶し活用できる設計になっています。

入力層

入力層は、RNNにデータを渡す部分です。例えば、あなたがRNNに「昨日の天気データ」や「過去の株価データ」を渡したいとき、この層でデータがRNNに入ります。

【主な特徴】

シーケンシャルデータ(例えば時間ごとのデータや、文章の単語、音声の波形など)を渡します。データが1つずつRNNに渡され、RNNがそれを1つずつ「覚えていきます」。

隠れ層

隠れ層は、RNNの中核を成す部分で、ネットワークの状態を保持し、時間的な依存関係を学習します。RNNは隠れ層で、以前の入力と現在の入力を組み合わせて新しい情報を生成します。

【主な特徴】

- 過去の情報を保持:RNNは、以前の入力データが「次に来るもの」にどう影響を与えるかを学びます。

- 状態を更新:隠れ層は、前の時刻の状態と現在の入力を元に、現在の状態を計算します。この計算がRNNの学習の要です。

- 時間的依存性を学習:隠れ層は、時系列データにおける「順番」や「関連性」を理解します。これがRNNの大きな特徴です。

出力層

出力層は、RNNが最終的に「予測」した結果を出力する部分です。

【主な特徴】

- 予測結果を生成:隠れ層で学習した内容を基に、次に来るデータや予測を出力します。

- 分類や回帰に対応:出力層は、分類タスク(例えば、どのカテゴリに分類するか)や、回帰タスク(連続した値を予測する)に対応します。

- 分類の場合:Softmax関数を使って、クラスの確率を出力。

- 回帰の場合:連続した値を出力。

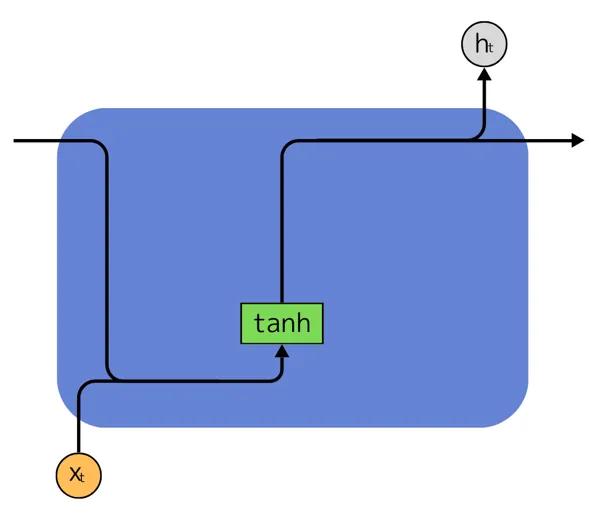

RNNの仕組み

内部状態の更新(過去の情報を覚える仕組み)

RNNは、過去の情報を記憶しながら、新しい情報を次々に処理していきます。これを実現するために、内部状態(h_t)が更新されます。

h_t h_{t-1} x_t W_h, W_x b

情報の伝播方法

RNNは過去の情報をどのように保持し、次に伝えるかという方法を決める仕組みがあります。

フィードバック接続による情報保持

- RNNでは、前の時刻の情報を「フィードバック」で受け取り、それを次の時刻に伝えます。このフィードバックが「過去の情報を覚えている」というメカニズムを作っています。

- つまり、RNNは「前の状態」が次にどう影響するかを考えながら、次の時刻に進んでいくのです。

状態ベクトルによる文脈表現

- RNNの「状態」は状態ベクトルとして表されます。状態ベクトルは「文脈」を表現し、例えば文章の意味や時系列データのパターンなどを覚えます。

- これにより、RNNは入力データが持つ意味のつながりや時間的な順番を理解できるようになります。

時間方向への展開

- RNNは、時間を順番に処理していきます。つまり、時系列データ(例えば、言葉や株価など)の一つ一つを順番に入力して、そのつながりを学習していきます。

- これにより、RNNは「過去の出来事」が次にどう影響するかを予測できるようになります。

ーー

RNNの種類

RNNには様々な派生アーキテクチャが存在し、それぞれが特定の課題を解決するために設計されています。

Simple RNN

Simple RNNは、最も基本的なRNNの構造です。時間の流れに沿って情報を「記憶」し、次に進むときにその記憶を使うシンプルな仕組みです。

【主な特徴】

- シンプルな構造:入力と出力を順番に処理し、過去の情報(状態)を次に伝えるだけ。

- 短期記憶:過去の情報をどんどん忘れていく傾向があり、長期的な依存関係をうまく捉えられない。

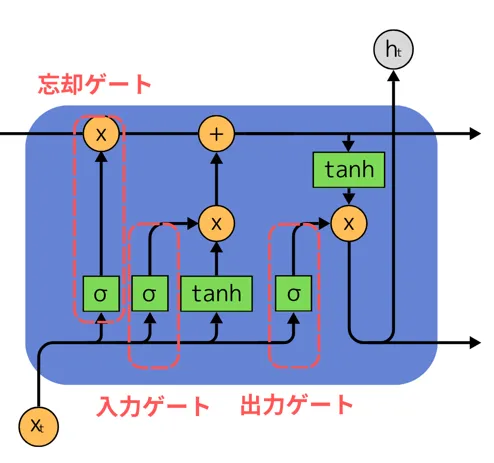

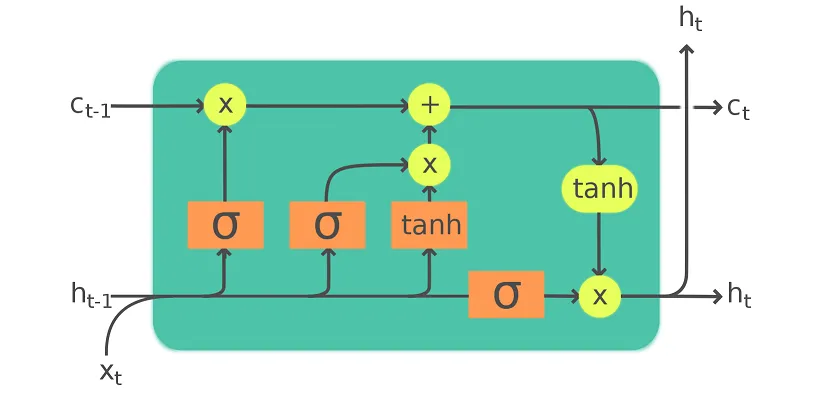

LSTM (Long Short-Term Memory)

LSTMは、Simple RNNの短期的な記憶の問題を解決するために作られた改良型のRNNです。

長期的な依存関係を学習する能力に優れており、情報を長期間保持することができます。

【主な特徴】

- 3つのゲート:LSTMは、情報をどれだけ「覚える」か、どれだけ「忘れる」か、そして「どの情報を新たに加えるか」を制御する3つのゲート(入力ゲート、忘却ゲート、出力ゲート)を使います。

- 長期記憶:これにより、LSTMは過去の重要な情報を長期間にわたって保持しやすくなります。

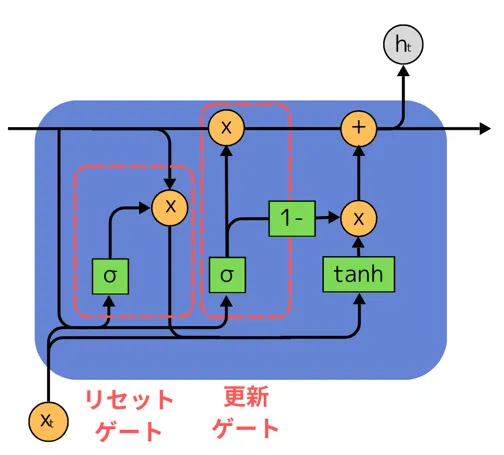

GRU (Gated Recurrent Unit)

GRUは、LSTMと似たような機能を持つRNNですが、構造が少し簡略化されており、計算の効率性が高いです。

LSTMのゲートを一部統合し、モデルを簡単にしています。

【主な特徴】

- 2つのゲート:GRUは、LSTMの「入力ゲート」と「忘却ゲート」を統合して、「更新ゲート」と「リセットゲート」という2つのゲートを使用します。

- 簡素化された計算:LSTMと同じように長期的な依存関係を捉える能力がありながらも、計算が効率的です。

双方向RNN (Bidirectional RNN)

双方向RNNは、入力データを「前から後ろ」と「後ろから前」の2方向から同時に処理するRNNです。これにより、過去の情報だけでなく未来の情報も取り入れて学習することができます。

【主な特徴】

- 2つのRNN:1つのRNNが順方向(過去から未来へ)に情報を処理し、もう1つのRNNが逆方向(未来から過去へ)に情報を処理します。両方の情報を結びつけて最終的な出力を決定します。

- 未来の文脈を考慮:文章や時系列データのようなタスクでは、未来の情報を考慮に入れることで、精度が向上することがあります。

RNNの学習

RNNの学習には特有の手法と課題があり、効果的な学習のために様々な工夫が必要です。

時系列データとは?

時系列データとは、時間の経過とともに変化するデータのことを指します。

【主な特徴】

- 順序依存性:データの順番が重要です。過去のデータが未来の予測に影響を与えるため、RNNは過去の情報を「記憶」しながら処理します。

- 動的な変化:時系列データは時間とともに動的に変化し、モデルはその変化をうまく捉える必要があります。

RNNは時系列データに対して、時間的な依存関係を学習し、次の予測を行うのに適しています。

Backpropagation Through Time (BPTT)

RNNの学習は、通常のニューラルネットワークで使う**逆伝播(バックプロパゲーション)**と似ていますが、**BPTT(Backpropagation Through Time)**という方法を使って学習します。

BPTTとは

RNNの学習は、時間をまたいで行うため、時系列データの各タイムステップにおける誤差を遡って計算します。

これが「時間を遡って誤差を伝播」させるという意味で、「Backpropagation Through Time」と呼ばれます。

各時刻の出力が次の時刻に影響を与えるので、誤差を逆順に遡って計算し、各タイムステップでの重みを更新します。

BPTTの流れ

BPTTは、RNNが時間を超えて学習するための方法ですが、計算が複雑でリソースを消費します。

- フォワードパス:時系列データを入力としてRNNが順番に処理を行い、最終的な予測を出します。

- バックワードパス:誤差を最終出力から逆方向に伝播させ、各タイムステップでの誤差を計算します。この誤差をもとに重みを更新します。

勾配消失問題

BPTTを使用してバックプロパゲーションを行う際に、誤差の勾配が時間とともに非常に小さくなり、更新がほとんど行われなくなる現象を勾配消失問題といいます。

勾配消失問題の原因

時系列が長くなると、逆伝播中に誤差の勾配がどんどん小さくなり、最初の時刻の重みがほとんど更新されないため、長期依存関係を学習できなくなります。

特に、tanhやsigmoidなどの活性化関数を使っている場合、勾配が非常に小さくなるため、この問題が起こりやすくなります。

勾配消失問題の影響

長い時系列データに対して、過去の情報を保持し続けることができず、RNNが「過去の重要な情報」を無視してしまうことになります。

結果的に、RNNは長期的な依存関係を捉えることができず、学習がうまく進まなくなります。

RNNの実装

それでは実際自分自身で実装する場合はどのようになるのでしょうか?

Google colabの環境で以下の模擬コードを実行してみましょう!

RNNの模擬コード

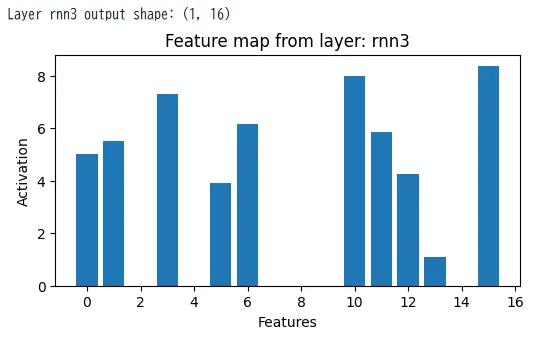

for layer_name, layer_activation in zip(layer_names, activations):

# 出力の形状を確認

if len(layer_activation.shape) == 3: # return_sequences=True の場合

num_steps = layer_activation.shape[1] # 時系列のステップ数

num_features = layer_activation.shape[2] # 特徴数

# プロットの設定

plt.figure(figsize=(12, 6))

plt.imshow(layer_activation[0].T, aspect='auto', cmap='viridis')

plt.colorbar()

plt.title(f'Feature maps from layer: {layer_name}')

plt.xlabel('Time Steps')

plt.ylabel('Features')

plt.show()

elif len(layer_activation.shape) == 2: # return_sequences=False の場合

num_features = layer_activation.shape[1] # 特徴数のみ

print(f"Layer {layer_name} output shape: {layer_activation.shape}")

plt.figure(figsize=(6, 3))

plt.bar(range(num_features), layer_activation[0])

plt.title(f'Feature map from layer: {layer_name}')

plt.xlabel('Features')

plt.ylabel('Activation')

plt.show()

else:

print(f"Unexpected shape for layer {layer_name}: {layer_activation.shape}")

実行結果

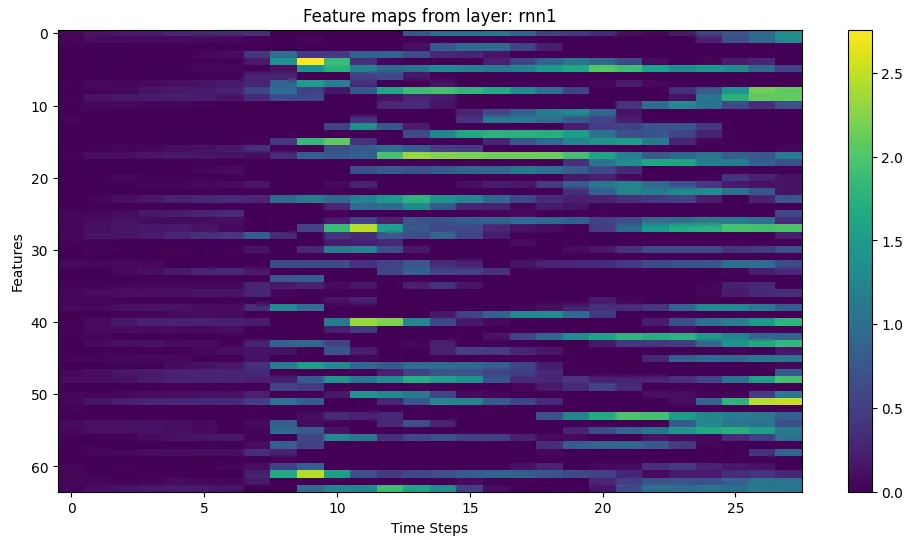

実行するとRNNの時系列が以下のようにわかります!

これは最初のRNN層 (rnn1) の出力を可視化しています。

出力された特徴マップは、縦軸が「特徴量」、横軸が「タイムステップ」、色が「各特徴量の活性化強度」を示します。

これにより、特定の特徴がどのタイムステップで強く活性化しているのかが分かります。

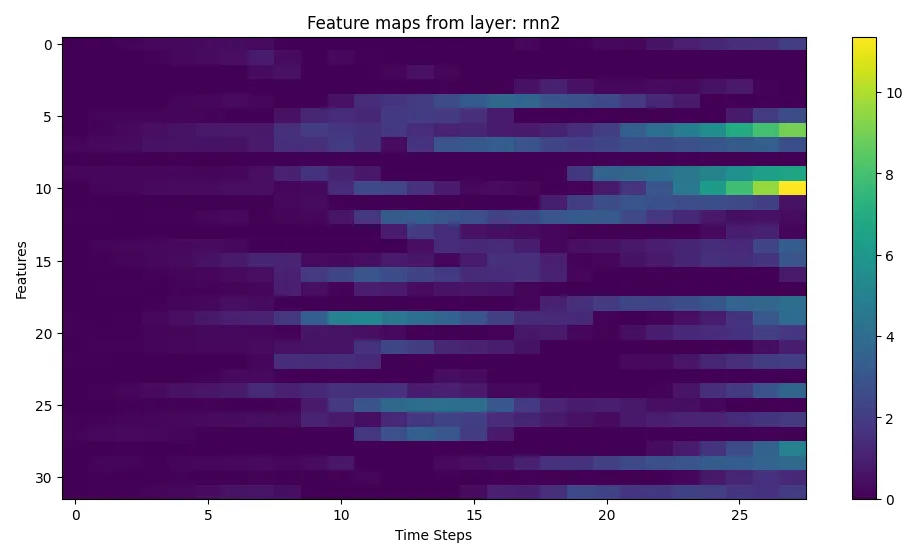

以下の画像は、第2層目のRNN(rnn2)の出力を可視化しています。

第2層は第1層の出力を受け取ります。rnn1 が時系列データの「基本的な特徴」を抽出し、その出力が rnn2 の入力として与えられます。

第2層のRNNは、通常、長期的な文脈情報や、rnn1 が捉えきれなかった時間的な依存性を捕捉する役割を果たします。

以下は第3層のRNN (rnn3) の出力を可視化しています。

rnn3 は、rnn2 の出力を受け取り、さらに高度な特徴を学習します。

特に rnn3 は、モデルの最も深い層として、時系列全体の情報を統合して出力する役割を果たします。

RNNの活用事例

現在、RNNは身近なものにたくさん活用されています!その具体例を見ていきましょう。

自然言語処理

機械翻訳

| 応用例 | 特徴 | 具体的なサービス |

|---|---|---|

| テキスト翻訳 | ・文脈を考慮した翻訳 ・自然な文章生成 |

・Google翻訳 ・DeepL |

| 同時通訳 | ・リアルタイム処理 ・話者の意図理解 |

・会議システム ・ビジネス通訳 |

Microsoft Translateの例

Microsoft Translatorも、ニューラルネットワークを基盤にした翻訳技術を使用しており、RNN(リカレントニューラルネットワーク)を利用したアーキテクチャを導入しています。特にAzureの機械翻訳APIを通じて提供される翻訳サービスでは、RNNやLSTMが使われています。

【関連記事】

Recurrent Neural Networks for Language Understanding

テキスト生成

- チャットボット対話

- 文章要約

- コンテンツ自動生成

TensorFlowの例

Googleが提供する機械学習ライブラリTensorFlowの公式サイトでは、RNNを用いたテキスト生成のチュートリアルが公開されています。TensFlowではシェイクスピアの作品をデータセットとして使用し、文字ベースのRNNモデルでテキスト生成することができます。

【関連記事】

TensorFlow

感情分析

- SNSの投稿分析

- カスタマーレビュー評価

- マーケティング調査

Empathの例

「Empath」は、音声から感情をリアルタイムで解析する技術です。この技術は、RNNを含む深層学習モデルを活用しており、コールセンターでの顧客対応や、アスリートのメンタルサポートなど、さまざまな分野での感情分析に利用されています。

【関連サイト】

Empath

音声認識

| 用途 | 特徴 | 例 |

|---|---|---|

| 音声文字起こし | ・高精度な認識 ・ノイズ耐性 |

・会議録作成 ・字幕生成 |

| 音声アシスタント | ・自然な対話 ・コマンド認識 |

・Siri ・Google Assistant |

Deepgramの例

Deepgramは、音声認識サービスを提供する企業で、RNNを活用して高精度の音声認識を実現しています。

Deepgramの音声認識システムは、音声データを解析してテキストに変換する際に、RNNやLSTM技術を使用しています。企業はこれを利用して、カスタマーサービスや会話の解析を行っています。

【関連サイト】

Deepgram

時系列予測

株価予測

- 価格変動の予測

- トレンド分析

- リスク評価

QuantConnectの例

QuantConnectは、アルゴリズムトレーディングと株価予測のためのオープンソースプラットフォームを提供しています。株式市場を予測するためにRNN技術(特にLSTM)を利用することができ、ユーザーはこれを使って自分の取引アルゴリズムを開発できます。

以下はxは入力データ、cは長期記憶、hは現在の状態であり短期記憶として機能します。

https://www.quantconnect.com/docs/v2/research-environment/applying-research/long-short-term-memory

https://www.quantconnect.com/docs/v2/research-environment/applying-research/long-short-term-memory

RNNの展望

RNNは今後さらなる改良などを期待されています。今後の展望について技術面と具体的な応用の2つにわけて説明していきます!

技術面

モデルの改良と効率化

- 長期依存関係の改善

- RNNは長期的な依存関係を学習するのが難しいとされていますが、これを解消する新しいアーキテクチャや手法が開発される可能性があります。

- LSTMやGRUの改良版や、TransformerのAttention機構とRNNを組み合わせたハイブリッドモデルが期待されます。

- 勾配消失問題の解決

- 勾配消失問題を軽減するための新しい最適化手法や正則化技術が進化し、RNNがより深い時間的依存関係を学習できるようになるでしょう。

計算効率の向上

- 軽量化

- モデルのパラメータ数を減らしつつ、性能を維持または向上させる軽量化手法(例: プルーニングや量子化)が進む。

- エッジデバイス(スマートフォン、IoTデバイスなど)でリアルタイム処理が可能になる。

- 専用ハードウェア

- AI向けの専用チップ(TPU、NPUなど)がさらに進化し、RNNの学習と推論が高速化される。

新たな学習手法の導入

- 自己教師あり学習

- ラベルのないデータを使った自己教師あり学習がRNNにも適用され、データの準備が困難な分野でも高性能なモデルが構築可能になる。

- 強化学習の統合

- RNNが強化学習と組み合わさり、長期的な意思決定を伴うタスク(例: ロボット制御、経済シミュレーションなど)での性能向上が期待される。

具体的な応用

上記の技術面での展望を踏まえて、今後どのような分野に活用が期待されるかを以下の表にまとめました!

| 領域 | 技術面の展望 | 応用面の展望 |

|---|---|---|

| モデル改良 | 長期依存関係の学習、勾配消失問題の解決 | 医療(診断支援)、金融(株価予測)、感情分析など |

| 効率化 | モデルの軽量化、エッジデバイスでの利用 | 天気予報、物流の最適化、交通管理 |

| 新学習手法 | 自己教師あり学習、強化学習の統合 | 音声認識、テキスト生成、創造的なエンターテインメント |

まとめ

本記事ではRNNについて解説しました。

この記事を通じて、RNNの基礎から応用まで理解が深まったのではないでしょうか?

RNNは、時系列データやシーケンスデータを処理する上で重要な技術であり、今後さらに多くの分野で活用されることが期待されています。

技術的には、長期依存関係の改善や計算効率の向上、新しい学習手法の導入が進み、より高度で効率的なモデルが登場するでしょう。一方で、医療、金融、物流、エンターテインメントなどの応用分野では、RNNが私たちの生活や社会に大きな影響を与えると予想されます。

ぜひこの記事を参考に、RNNの可能性を探求してみてください。そして、RNNがどのように活用されているか、ご自身のプロジェクトやアイデアにどう活かせるかを考えてみてください!

疑問や意見があれば、AI総合研究所にご相談を!導入の構想段階から、AI開発はもちろんのことRNNなどのシステム開発まで一気通貫で支援いたします。

お気軽に弊社にご相談ください。一緒にAIの可能性を広げていきましょう! 😊