この記事のポイント

SLMは、パラメータ数やモデルサイズが比較的小さい言語モデル

低コスト、高速推論、低環境負荷、特定タスクへの適合性がメリット

SLMは、LLMと比較して、汎用性、複雑なタスクへの対応、知識量に限界

モバイル、IoT、エッジ、組み込みシステム、特定業務AIで活用

今後、SLMはLLMと共存し、AIの民主化と持続可能な開発を推進

Microsoft MVP・AIパートナー。LinkX Japan株式会社 代表取締役。東京工業大学大学院にて自然言語処理・金融工学を研究。NHK放送技術研究所でAI・ブロックチェーンの研究開発に従事し、国際学会・ジャーナルでの発表多数。経営情報学会 優秀賞受賞。シンガポールでWeb3企業を創業後、現在は企業向けAI導入・DX推進を支援。

AIの進化は目覚ましいですが、大規模言語モデル(LLM)の運用には、高いコストや環境負荷、プライバシーの問題など、様々な課題が伴います。より手軽に、環境にも優しくAIを活用したい…そんなニーズに応えるのが「SLM(小規模言語モデル)」です。

しかし、SLMはLLMに比べて何が違うのか、どのようなメリット・デメリットがあるのか、具体的にどのような場面で活用できるのか、といった疑問を持つ方も多いのではないでしょうか。

本記事では、この「SLM」について、基礎から応用までをわかりやすく解説します。

SLMの仕組み、LLMとの違い、メリット・デメリット、主要モデル、活用が期待される分野、そして今後の展望まで、幅広く網羅的に説明します。

SLM (Small Language Models) とは?

SLM (Small Language Models) とは、その名の通り、パラメータ数やモデルサイズが比較的小さい言語モデルのことを指します。

明確な基準があるわけではないものの、一般的にはLLMよりも軽量で、少ない計算リソースで動作するモデルを指すことが多いです。

例えば、数億から数十億のパラメータを持つモデルがSLMと見なされることがあります。

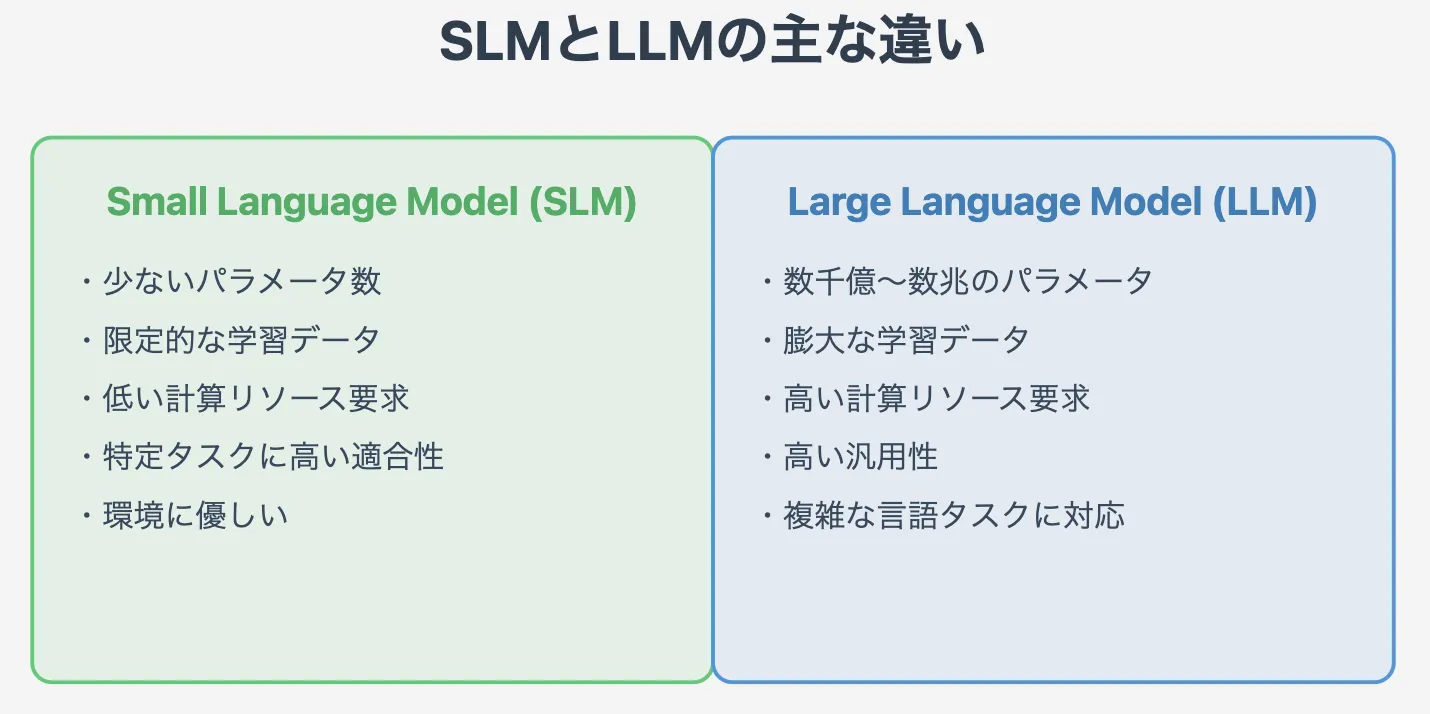

SLMとLLMの違い

SLMとLLMの違い

SLMとLLMの主な違いは、パラメータ数、モデルサイズ、学習データ量、そして必要な計算リソースです。

LLMが膨大なパラメータと大規模な学習データを用いて高い汎用性を実現しているのに対し、SLMはパラメータと学習データを抑えることで、効率性と特定タスクへの適合性を高めています。

例えば、LLMは数千億から数兆のパラメータを持つことがありますが、SLMはそれよりもはるかに少ないパラメータで構成されます。この違いにより、SLMはトレーニングや推論に必要な計算リソースが少なく、より環境に優しいと言えます。

| 項目 | SLM | LLM |

|---|---|---|

| パラメータ数 | 数億~数十億 | 数千億~数兆 |

| モデルサイズ | 小さい | 大きい |

| 学習データ量 | 比較的少ない | 膨大 |

| 計算リソース | 少ない | 多い |

| 汎用性 | LLMに比べて低い | 高い |

| 特定タスク適性 | 高い | 汎用的なタスクに対応 |

| 運用コスト | 低い | 高い |

| 環境負荷 | 低い | 高い |

Google Colab でSLMを実行する方法

ここからは、Google Colab で Small Language Model(SLM)「distilGPT2」 を使って

テキスト生成・GPU活用・ファインチューニング・軽量化(量子化) を行う方法をご紹介します。

具体的な出力例も合わせてご紹介するので、ぜひお手元で挑戦してみてください!

完成させた完全版のコードは以下のトグルに示しています。

完成したコード

# 必要なライブラリをインストール

!pip install transformers datasets torch accelerate bitsandbytes

# ライブラリのインポート

import torch

from transformers import pipeline, AutoModelForCausalLM, AutoTokenizer, TrainingArguments, Trainer, BitsAndBytesConfig

from datasets import load_dataset

import bitsandbytes as bnb

from google.colab import drive

# GPU の確認

device = "cuda" if torch.cuda.is_available() else "cpu"

print(f"Using device: {device}")

# distilGPT2(軽量GPT-2)のロード

generator = pipeline("text-generation", model="distilgpt2", device=0 if device == "cuda" else -1)

model = AutoModelForCausalLM.from_pretrained("distilgpt2").to(device)

tokenizer = AutoTokenizer.from_pretrained("distilgpt2")

# 📝 テキスト生成

prompt = "Once upon a time"

output = generator(prompt, max_length=50, num_return_sequences=1)

print("\n🔹 テキスト生成結果:\n", output[0]['generated_text'])

# 🏋️♂️ ファインチューニング

print("\n🔹 ファインチューニング開始...")

# データの準備

dataset = load_dataset("wikitext", "wikitext-2-raw-v1", split="train")

# トークナイズ

def tokenize_function(examples):

return tokenizer(examples["text"], truncation=True, padding="max_length", max_length=512)

tokenized_datasets = dataset.map(tokenize_function, batched=True)

# トレーニング設定

training_args = TrainingArguments(

output_dir="./results",

evaluation_strategy="epoch",

save_strategy="epoch",

per_device_train_batch_size=4,

per_device_eval_batch_size=4,

num_train_epochs=1,

logging_dir="./logs",

)

# Trainer の設定とトレーニング実行

trainer = Trainer(model=model, args=training_args, train_dataset=tokenized_datasets)

trainer.train()

# 🎯 モデルの量子化(軽量化)

print("\n🔹 モデルの量子化...")

quantization_config = BitsAndBytesConfig(load_in_8bit=True)

quantized_model = AutoModelForCausalLM.from_pretrained("distilgpt2", quantization_config=quantization_config)

# Google Drive にモデル保存

print("\n🔹 Google Drive にモデルを保存...")

drive.mount('/content/drive')

model.save_pretrained("/content/drive/MyDrive/distilgpt2_finetuned")

tokenizer.save_pretrained("/content/drive/MyDrive/distilgpt2_finetuned")

# 🔥 保存したモデルで再度テキスト生成

print("\n🔹 保存したモデルでテキスト生成...")

model = AutoModelForCausalLM.from_pretrained("/content/drive/MyDrive/distilgpt2_finetuned")

tokenizer = AutoTokenizer.from_pretrained("/content/drive/MyDrive/distilgpt2_finetuned")

# 推論実行

prompt = "In a distant galaxy"

inputs = tokenizer(prompt, return_tensors="pt").to(device)

outputs = model.generate(**inputs, max_length=50)

print("\n🔹 保存したモデルの生成結果:\n", tokenizer.decode(outputs[0], skip_special_tokens=True))

print("\n✅ 完了!Google Colab で distilGPT2 を活用する準備が整いました!🚀")

ステップバイステップで手順をご紹介していきます!

全体手順

全体の手順は以下の通りです。

- Google Colab のセットアップ

- distilGPT2 でテキスト生成

- GPU を活用して高速化

- ファインチューニング

- モデルの軽量化(量子化)

- モデルの保存とエクスポート

1️⃣ Google Colab のセットアップ

Google Colab で必要なライブラリをインストールします。

!pip install transformers datasets torch accelerate bitsandbytes

次に、transformers ライブラリを使って、distilGPT2 をロードします。

from transformers import pipeline

# distilGPT2(小型GPT-2モデル)をロード

generator = pipeline("text-generation", model="distilgpt2")

# モデルの設定を確認

print(generator.model.config)

📌 出力例

DistilBertConfig {

"activation_function": "gelu",

"attention_dropout": 0.1,

"hidden_size": 768,

"num_attention_heads": 12,

"num_hidden_layers": 6,

...

}

2️⃣ distilGPT2 でテキスト生成

テキストを入力し、distilGPT2 に文章を生成させます。

prompt = "Once upon a time"

output = generator(prompt, max_length=50, num_return_sequences=1)

print(output[0]['generated_text'])

📌 出力例

Once upon a time there was a young girl who lived in a small village. She loved to read books and explore the world around her...

3️⃣ GPU を活用して高速化

Google Colab で GPU を有効にし、高速に推論を行います。

import torch

# GPU が利用可能か確認

device = "cuda" if torch.cuda.is_available() else "cpu"

print(f"Using device: {device}")

# GPU にモデルをロード

generator.model.to(device)

📌 出力例

Using device: cuda

4️⃣ ファインチューニング

独自データを使って distilGPT2 をトレーニングする方法を紹介します。

🔹 データの準備

Hugging Face の datasets を使い、サンプルデータをロードします。

from datasets import load_dataset

# Wikipedia のサンプルデータセットをロード

dataset = load_dataset("wikitext", "wikitext-2-raw-v1", split="train")

# データの一部を表示

print(dataset[0]['text'])

📌 出力例

= Robert Boulter =

Robert Boulter is a British actor...

🔹 トークナイズ

from transformers import AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("distilgpt2")

# データをトークナイズ

def tokenize_function(examples):

return tokenizer(examples["text"], truncation=True, padding="max_length", max_length=512)

tokenized_datasets = dataset.map(tokenize_function, batched=True)

🔹 トレーニングの設定

from transformers import TrainingArguments, Trainer, AutoModelForCausalLM

model = AutoModelForCausalLM.from_pretrained("distilgpt2")

training_args = TrainingArguments(

output_dir="./results",

evaluation_strategy="epoch",

save_strategy="epoch",

per_device_train_batch_size=4,

per_device_eval_batch_size=4,

num_train_epochs=3,

logging_dir="./logs",

)

trainer = Trainer(

model=model,

args=training_args,

train_dataset=tokenized_datasets,

)

trainer.train()

5️⃣ モデルの軽量化(量子化)

モデルを軽量化するために bitsandbytes を使い、8bit に量子化します。

import bitsandbytes as bnb

from transformers import BitsAndBytesConfig

quantization_config = BitsAndBytesConfig(load_in_8bit=True)

# 量子化モデルをロード

quantized_model = AutoModelForCausalLM.from_pretrained("distilgpt2", quantization_config=quantization_config)

# メモリ使用量を確認

print(quantized_model.hf_device_map)

📌 出力例

{'transformer': 'cuda:0'}

6️⃣ モデルの保存とエクスポート

トレーニングしたモデルを Google Drive に保存します。

from google.colab import drive

# Google Drive をマウント

drive.mount('/content/drive')

# モデルを保存

model.save_pretrained("/content/drive/MyDrive/distilgpt2_finetuned")

tokenizer.save_pretrained("/content/drive/MyDrive/distilgpt2_finetuned")

🔹 モデルの再利用

from transformers import AutoModelForCausalLM, AutoTokenizer

# モデルをロード

model = AutoModelForCausalLM.from_pretrained("/content/drive/MyDrive/distilgpt2_finetuned")

tokenizer = AutoTokenizer.from_pretrained("/content/drive/MyDrive/distilgpt2_finetuned")

# 推論実行

prompt = "In a distant galaxy"

inputs = tokenizer(prompt, return_tensors="pt")

outputs = model.generate(**inputs, max_length=50)

print(tokenizer.decode(outputs[0], skip_special_tokens=True))

📌 出力例

In a distant galaxy, far beyond the reach of human civilization, an ancient race of beings known as the Eldari watched over the universe...

このようにGoogle colabでもSLMの活用を試すことができます。

ぜひお手元でも実行してみてください! 😊

SLMのメリット - 小規模だからこその利点

リソースが限られた環境でも高性能なAIを活用できることは、ビジネスの現場から研究開発、さらには個人の利用に至るまで、幅広い分野にメリットをもたらします。

ここでは、SLMが持つ具体的なメリットについて詳しく解説します。

1. 低コスト:運用・推論コストの削減

SLMはLLMに比べてモデルサイズが小さいため、運用コストや推論コストを大幅に削減できます。

これは、サーバー費用や電力消費量の削減に繋がり、経済的なメリットが大きいです。特に、大量の推論リクエストを処理する必要がある場合、SLMの低コスト性は大きな強みとなります。

2. 高速な推論速度: エッジデバイスでのリアルタイム処理

モデルサイズが小さいことは、推論速度の向上にも寄与します。

SLMは、スマートフォンやIoTデバイスなどのエッジデバイスでも高速に動作させることが可能となり、リアルタイムでの自然言語処理が求められるアプリケーションへの適用が期待できます。

例えば、音声アシスタントやリアルタイム翻訳などのアプリケーションにおいて、ユーザー体験を大きく向上させることができます。

3. 環境負荷の低減: 消費電力・CO2排出量の削減

SLMは、LLMに比べて消費電力が少なく、CO2排出量も削減できます。

これは、環境問題への意識が高まる現代において、非常に重要なメリットです。AIモデルの運用に伴う環境負荷を低減することは、持続可能な社会の実現に向けて大きな意味を持ちます。

4. 特定タスクへの高い適合性: ファインチューニングで性能向上

SLMは、特定のタスクに特化してファインチューニングすることで、限られたリソースの中で高い性能を発揮できます。

これにより、特定の業務や用途に最適化されたAIモデルを効率的に開発できます。例えば、医療診断や法律文書の分析など、専門知識を必要とするタスクにおいて、SLMは大きな力を発揮します。

5. プライバシー保護: オンデバイス処理でデータセキュリティ向上

SLMは、オンデバイスでの処理が可能となるため、ユーザーのデータをクラウドに送信することなく、デバイス上で完結させることができます。

これにより、プライバシー保護の観点からも大きなメリットがあります。特に、個人情報や機密情報を扱うアプリケーションにおいて、SLMの活用はデータセキュリティの向上に繋がります。

6. アクセシビリティの向上: 低いハードウェア要件

SLMは、LLMに比べて動作に必要なハードウェア要件が低いため、より多くの人々がAI技術の恩恵を受けられるようになります。

これは、AIの民主化にも繋がります。高性能なハードウェアを持たないユーザーでも、SLMを活用することで、様々なAIアプリケーションを利用できるようになります。

SLMのデメリット(LLMと比較した場合)

SLMは多くのメリットを持つ一方で、LLMと比較した場合にはいくつかのデメリットも存在します。

ここでは、SLMが抱える限界を理解することで、その特性を活かした適切な活用方法を検討するための材料とします。

1. 汎用性の限界

LLMに比べて学習データやパラメータ数が少ないSLMは、対応できるタスクの範囲が狭くなる可能性があります。

幅広いタスクに対応できる汎用性を求める場合には、LLMの方が適している場合があります。

例えば、様々な質問に答えたり、多様な文章を生成したりするような、汎用的なAIアシスタントを開発する場合には、LLMの方が優れていると言えるでしょう。

2. 複雑なタスクへの対応

高度な推論や文脈理解を必要とする複雑なタスクにおいては、SLMはLLMに比べて性能が劣る場合があります。

例えば、長い文章の要約や、複雑な論理的推論を必要とする質問応答などにおいては、LLMの方が高い精度を発揮する可能性があります。

3. 知識量の限界

学習データ量が少ないため、SLMはLLMに比べて知識ベースが小さくなる傾向があります。

そのため、幅広い知識を必要とするタスクでは、LLMの方が有利な場合があります。

例えば、専門的な知識を問う質問に対しては、LLMの方が適切な回答を生成できる可能性が高いです。

SLMの主要モデルと開発動向

LMの分野は急速に発展しており、日々新しいモデルや技術が登場しています。

ここでは、主要なSLMモデルの特徴や性能を紹介するとともに、最新の研究開発動向を把握することで、SLMの現状と将来の可能性を理解します。

グローバル主要モデル

| モデル名 | 開発元 | パラメータ数 | 特徴 | 主な用途 |

|---|---|---|---|---|

| Phi‑4 | Microsoft | 約14B | 複雑な推論(特に数学的推論)に特化。高度なトレーニング手法で精度向上。 | リアルタイム推論、エッジデバイス |

| Mistral 7B | Mistral AI | 7B | オープンソースで、性能とオープン性のバランスに優れる。 | 研究開発、特定タスクへの適応 |

| Gemma | 2B / 7B | 最新技術を活用し、軽量性と高性能を両立。モバイル・エッジ向けに最適化。 | モバイルデバイス、エッジコンピューティング | |

| Apple Intelligence | Apple | 非公開 | オンデバイス動作に最適化。最新端末(例:iPhone16)に搭載。 | モバイルアプリ、組み込みシステム |

日本語モデル

| モデル名 | 開発元 | パラメータ数 | 特徴 | 主な用途 |

|---|---|---|---|---|

| NTT tsuzumi | NTT | 70億 / 600M | 日本語最適化の軽量モデル。低コスト・低エネルギーで高精度な処理。 :contentReference[oaicite:2]{index=2} | コンタクトセンター、業界向けシステム |

| NEC cotomi | NEC | 未公表 | 特定用途に特化した軽量モデル。運用コスト削減と省エネルギーが強み。 :contentReference[oaicite:3]{index=3} | 業務自動化、組み込みシステム |

| Rakuten AI 2.0 mini | Rakuten | 約15億 | コンパクトながら高精度。日本語データに最適化し、オンプレミス運用可能。 :contentReference[oaicite:4]{index=4} | モバイルアプリ、プライバシー重視の現場 |

| TinySwallow-1.5B | Sakana AI | 約15億 | 革新的なTAID手法採用。軽量でありながら日本語理解性能が高い。 :contentReference[oaicite:5]{index=5} | オフライン動作、スマホ・PC向け利用 |

SLMの活用が期待される分野・ユースケースのご紹介

SLMの適用可能性を知る: SLMはその特性から、様々な分野での活用が期待されています。

ここでは、具体的な活用が期待される分野やユースケースを紹介することで、SLMが私たちの生活やビジネスにどのように役立つかを明らかにします。

モバイルデバイス、IoTデバイス

SLMは、スマートフォンやタブレットなどのモバイルデバイスや、各種センサーなどのIoTデバイスに搭載することで、その真価を発揮します。

例えば、音声アシスタントやリアルタイム翻訳などのアプリケーションを、より高速かつ効率的に動作させることが可能になります。

ユーザーは、よりスムーズで快適なユーザー体験を享受できるようになります。

また、オフライン環境でも、ある程度の自然言語処理タスクを実行できるため、ネットワーク接続が不安定な場所でも利用できるというメリットもあります。

エッジコンピューティング

ネットワークの末端(エッジ)でデータ処理を行うエッジコンピューティングにおいても、SLMは重要な役割を果たします。

サーバーへの通信負荷を軽減し、リアルタイム性の高いアプリケーションを実現できます。

例えば、工場の製造ラインに設置されたセンサーから収集されたデータを、エッジデバイス上でSLMを用いて解析することで、異常検知を迅速に行い、生産効率の向上に繋げることができます。

組み込みシステム

自動車や産業機器などの組み込みシステムにも、SLMは活用できます。

限られたリソースの中で高度な自然言語処理を実現し、システムのインテリジェント化に貢献します。

例えば、自動車に搭載されたSLMが、ドライバーの音声を認識し、ナビゲーションシステムやエンターテインメントシステムを制御する、といった活用が考えられます。

特定業務に特化したAIアシスタント

カスタマーサポートやデータ入力など、特定の業務に特化したAIアシスタントの開発にも、SLMは適しています。

ファインチューニングによって業務に最適化されたモデルを構築することで、業務効率化やコスト削減に繋がります。

例えば、顧客からの問い合わせ内容をSLMが解析し、適切な回答を自動生成する、といったシステムを構築することで、カスタマーサポートの負担を軽減できます。

リソースが限られた環境での自然言語処理

発展途上国や教育現場など、計算リソースが限られた環境においても、SLMは有効です。低コストで導入できるため、幅広い地域や分野で自然言語処理技術の恩恵を受けられるようになります。

例えば、教育用タブレットにSLMを搭載することで、生徒一人ひとりに合わせた学習支援を提供することが可能になります。

SLMの未来は?

SLM(Small Language Model)は、今後さらに軽量化が進みつつ、性能面でも飛躍的な進化を遂げると予想されます。

新たなモデルアーキテクチャや、より効率的な学習手法の開発により、計算負荷を抑えながらも高い精度を維持できるようになります。

特に、改良されたTransformerモデルや最適化されたAttention機構の登場は、SLMの推論速度やエネルギー効率の向上に大きく貢献するでしょう。さらに、ハードウェアの進化に伴い、エッジデバイスでも高性能なSLMの運用が可能になり、活用の幅が広がると考えられます。

LLMとの共存と最適な使い分け

SLMはLLM(Large Language Model)を完全に置き換えるものではなく、それぞれの特性を活かした共存が鍵となります。

例えば、

- 汎用的な対話や大規模なデータ処理 → LLMの得意分野

- 特定タスクやエッジデバイスでの高速処理 → SLMが適している領域

このように、用途に応じて最適なモデルを選択することが、効率的なAI活用につながります。

将来的には、LLMとSLMが連携し、高度なタスクをより柔軟に処理するシステムの登場も期待されます。

SLMの進化は、LLMと補完し合いながら、AI技術のさらなる発展を支える重要な要素となるでしょう。

まとめ

本記事では、今注目の「SLM (Small Language Models)」について、その概要、メリット・デメリット、LLMとの違い、主要モデル、活用分野、そして今後の展望と課題まで、幅広く解説してきました。

SLMは、LLMが抱える課題を克服する可能性を秘めた、非常に有望な技術です。今後、研究開発がさらに進み、様々な分野で活用されることで、私たちの生活をより豊かにしてくれることが期待されます。

SLMは、AIの民主化を推進し、持続可能なAI開発に貢献する重要な技術として、今後ますます注目を集めることでしょう。

AI総合研究所合研究所では、多彩な実績と知見を活かしから企業のAI導入をサポートしています。

企業規模や業種に合わせたカスタムプランもご用意しておりますので、ぜひお気軽にご相談ください。