この記事のポイント

Model Context Protocol (MCP) は、LLMのコンテキスト長制限を克服するための技術的アプローチ・概念

LLMが必要とする文脈情報(コンテキスト)を外部で効率的に管理・提供する仕組みを目指す

コンテキスト拡張、応答品質向上、APIコスト削減などのメリットが期待される

RAG(検索拡張生成)とは密接に関連し、補完または統合される可能性がある

長文読解、複雑な対話システム、専門分野Q&Aなど多様な応用が考えられる

Microsoft MVP・AIパートナー。LinkX Japan株式会社 代表取締役。東京工業大学大学院にて自然言語処理・金融工学を研究。NHK放送技術研究所でAI・ブロックチェーンの研究開発に従事し、国際学会・ジャーナルでの発表多数。経営情報学会 優秀賞受賞。シンガポールでWeb3企業を創業後、現在は企業向けAI導入・DX推進を支援。

「LLMにもっと長い文章を理解させたい」「複雑な対話履歴をAIに記憶させたい」「外部の膨大な知識を効率的に活用したい」

大規模言語モデル(LLM)の驚異的な能力は日々進化していますが、一度に扱える情報量(コンテキスト長)の限界という壁に直面しています。

この課題に対する有望な解決策として、今「Model Context Protocol (MCP)」という概念が注目を集め始めています。

本記事では、このMCPとは一体何なのか、その基本的な考え方から仕組み、メリット、そしてRAG(検索拡張生成)との関係性、具体的な応用例、将来性まで、AI開発の最前線に関わる情報を徹底的に解説します。

目次

Model Context Protocol (MCP) とは何か?

RAG (Retrieval-Augmented Generation) とは

GitHub Copilot:AgentモードにおけるMCPの採用

Microsoft Azure:Azure FunctionsでのMCPサーバー構築

Model Context Protocol (MCP) とは何か?

Model Context Protocol (以下MCP) は、現在、大規模言語モデル (LLM)を使った実用AIシステムの核心技術として注目を集めています。

MCPは、大規模言語モデルの文脈情報を、モデル内部のコンテキストウィンドウのみに依存するのではなく、外部で効率的に管理し、動的にLLMに提供・更新するための技術概念です。

本記事では、MCPの基本概念から、その技術的アーキテクチャ、実用例、RAGとの違いまで網羅的に詳しく解説します!

なぜMCPが必要なのか

MCPを理解するためには、まずLLMが抱えるコンテキストウィンドウの制約とその影響を知ることが重要です。ここでは、具体的な問題点を解説します。

そもそもコンテキストウィンドウとは?

LLMにおけるコンテキストウィンドウ(Context Window)またはコンテキスト長(Context Length)とは、モデルが一度に処理・参照できるテキストの最大量を指します。

LLMは、応答を生成する際に、コンテキストウィンドウ内の情報だけを考慮し、ウィンドウのサイズを超えた情報は、基本的に扱うことができません。

コンテキストウィンドウの制約による問題点

LLMのコンテキストウィンドウの制約は、様々な応用場面で具体的な問題を引き起こします。

- 長文の処理・理解が困難

数十ページに及ぶレポートの完全な理解や要約、書籍全体の内容に基づいた質疑応答などが難しく、コンテキストウィンドウを超える部分は無視されるか、不完全な形でしか扱えません。

- 複雑な対話履歴の維持が難しい

長時間にわたるチャットボットとの対話や、複数のトピックが入り混じる議論において、過去の発言や文脈を正確に記憶し続けることができず、話が噛み合わなくなったり、同じことを繰り返したりする原因になります。

- APIコストの増大

クラウドベースのLLM APIを利用する場合、料金は処理されるトークン数に基づいて計算されることが一般的です。対話が長くなるほど、APIの利用料金が高くなります。

- AIエージェントの記憶限界

自律的にタスクを進めるAIエージェントにとって、過去の行動、観察結果、計画、ユーザーの指示などを記憶しておくことは不可欠ですが、その記憶容量を制限してしまいます。

これらの問題は、LLMの応用可能性を狭め、ユーザー体験を損なう要因となっています。柔軟かつ効率的に、大規模で動的なコンテキスト情報を扱える新しい仕組みとして、MCPへの期待が高まっているのです。

MCPとRAGの違いは?

コンテキスト拡張技術として知られるRAGとMCPは何が違うのでしょうか?それぞれの特徴、得意なことについて比較・解説します。

RAG (Retrieval-Augmented Generation) とは

まず、比較対象となるRAGについてご紹介します。

RAG(Retrieval-Augmented Generation、検索拡張生成)は、LLMが応答を生成する際に、外部の知識ソースから関連情報を検索し、その情報をプロンプトの一部としてLLMに与えることで、応答の精度や事実性を向上させる技術です。

詳しくはこちらの記事で解説しています。ぜひ併せてご覧ください。

生成AIのRAGとは?その仕組みや作り方、活用事例を解説!

MCPとRAGの主な違い

MCPとRAGは目的が似ていますが、そのアプローチや焦点には違いがあります。

| 比較項目 | RAG (Retrieval-Augmented Generation) | MCP (Model Context Protocol) |

|---|---|---|

| 主な目的 | 外部知識を検索し、LLMの応答の事実性・知識を補強する | LLMのコンテキスト全体(対話履歴、状態、外部知識等)を外部で管理する |

| 焦点 | 検索とその結果のプロンプトへの注入 | コンテキスト管理の仕組み・プロトコル全体 |

| 扱う情報 | 主に外部知識 (文書、データベースなど) | 対話履歴、タスク状態、ユーザー情報、外部知識など広範なコンテキスト |

| 処理 | 質問ごとに知識を検索し、プロンプトに付加する | 対話全体を通じてコンテキストを動的に維持・更新・選択・提供する |

| 位置づけ | 比較的確立された具体的な技術 | より概念的、アーキテクチャ的なアプローチ |

| プロンプト長 | プロンプトが長くなる傾向 | プロンプト長を最適化・削減する可能性 |

簡単に言えば、RAGは「知識の検索と注入」に特化した技術であり、MCPは「コンテキスト全体の効率的な管理」を目指す、より広範な枠組みや考え方と言えます。

MCPの仕組み

MCPは具体的にどのように機能し、コンテキスト問題を解決するのでしょうか? その中核となる仕組みや構成要素について解説します!

MCPのコンセプト

MCPの最も基本的な考え方は、LLMが依存するコンテキスト情報を、LLM本体の限られた内部メモリ(コンテキストウィンドウ)から切り離し、外部の専用システムで管理するという点にあります。

これにより、LLMはコンテキストウィンドウの制約を受けずに、はるかに大量の情報源(過去の対話履歴、ユーザープロファイル、外部ドキュメント、データベース、APIの応答など)を活用できるようになります。

重要なのは、単に外部に情報を保存するだけでなく、それを動的に管理し、LLMが必要とする情報を効率的に特定し、適切な形でLLMに提供する仕組みを定義することです。これは、人間の脳が長期記憶の中から関連情報だけを短期記憶に引き出すプロセスに似ています。

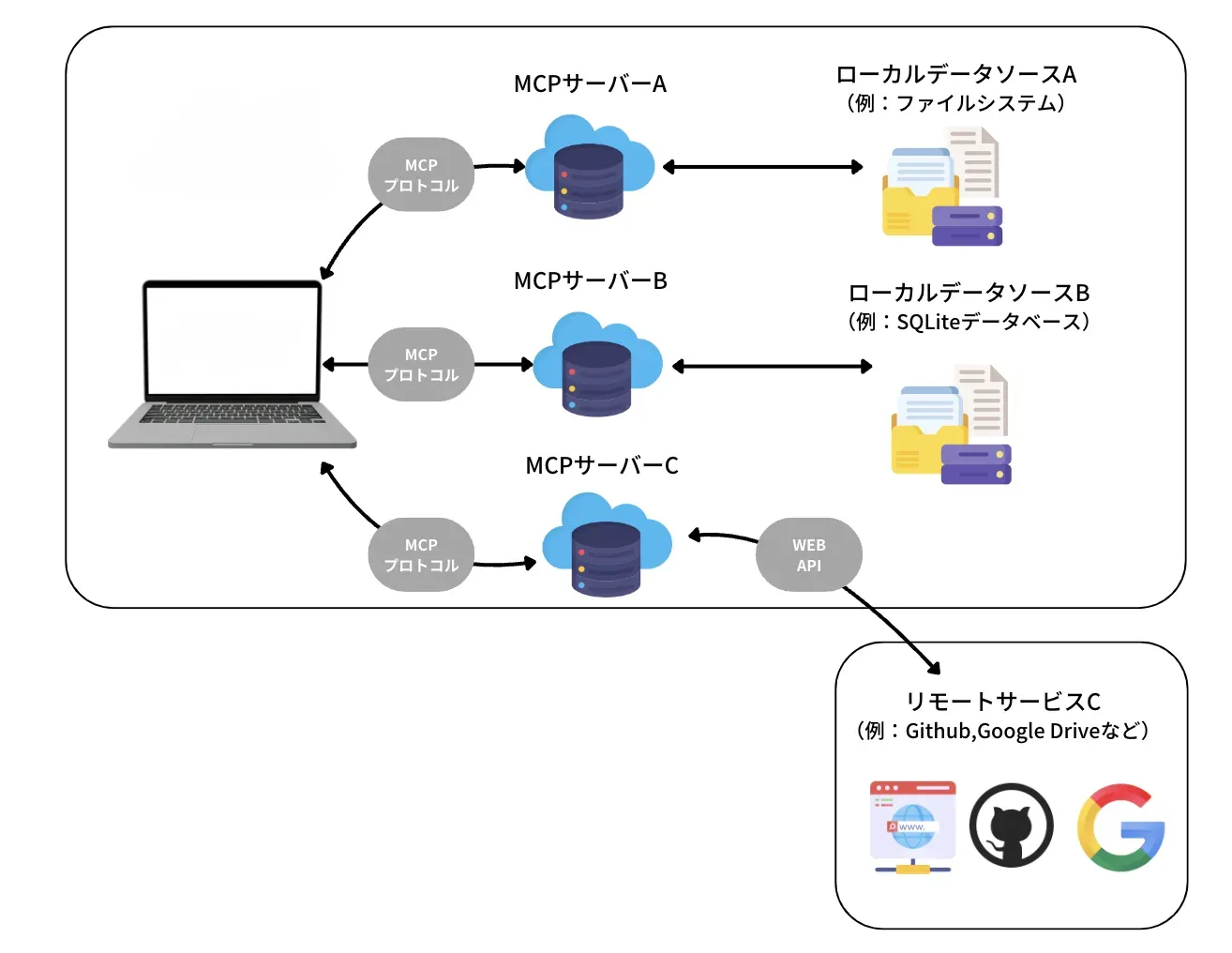

MCPの概念図

MCPの主要な構成要素とそれぞれの役割

ここでは、MCPを実現するための具体的なアーキテクチャをご紹介します。

- MCPクライアント:AIエージェントなど、ユーザーの入力を受け取るインターフェース。

- MCPサーバー:文脈情報(ツール・リソース)を提供する側のサービス。

- LLM本体:テキスト生成を行う中核エンジン。

- Context Manager:文脈情報を収集・選定・整形する役割。

- External Memory(外部メモリ):過去の対話、文書、ユーザープロファイル、ナレッジベースなどを保持。

- 圧縮・抽象化モジュール:取得した文脈をLLMに渡せるように整形。

これらが連携して動作することで、効率的なコンテキスト管理が実現されます。

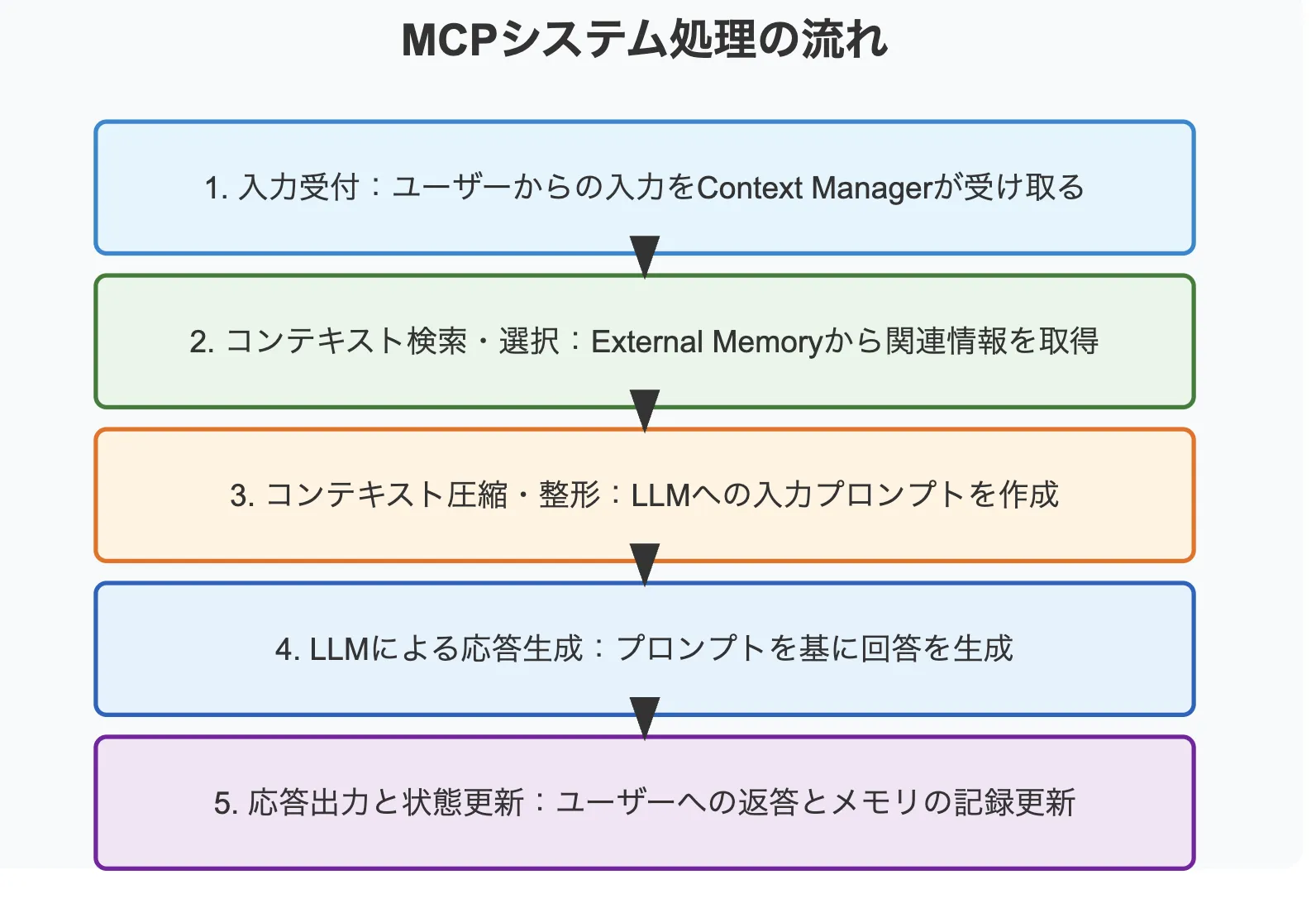

MCPの処理の流れ

MCPに基づいたシステムの処理の流れを解説していきます。

- 入力受付:ユーザーからの入力をContext Managerが受け取ります。

- コンテキスト検索・選択:Context Managerは、現在の入力と、External Memoryに保持されている対話履歴や外部知識などを照合し、応答生成に必要かつ関連性の高いコンテキスト情報を検索・選択します。

- コンテキスト圧縮・整形:選択されたコンテキスト情報は、必要に応じて圧縮・抽象化され、LLMへの入力プロンプトとして整形されます。プロンプトには、ユーザーの現在の入力と、選択された関連コンテキストが含まれます。

- LLMによる応答生成:整形されたプロンプトがLLMに渡され、LLMはそれを基に応答を生成します。

- 応答出力と状態更新:LLMが生成した応答はユーザーに返され、同時に、今回の対話に関する情報が、次の対話のためにExternal Memoryに記録・更新されます。

この一連のサイクルを通じて、対話が長期化したり、参照すべき情報が大量にある場合も、LLMは常に最も関連性の高い情報に基づいて応答を生成できるようになります。

MCPを実際に使ってみましょう

今回は、Playwright MCPとClaude Desktopを活用したMCPの導入方法をご紹介します。

Playwright MCPは、LLMによるWebページの操作をスケーラブルかつセキュアに行えるようにする、Microsoft製のテストサーバーで、GitHubのplaywright-mcpリポジトリから利用が可能です。

Claude Desktopは、Anthropic社のAIモデルClaudeをデスクトップアプリとして使用できるソフトです。

-

Claude Desktopの公式サイトにアクセスし、インストールを行います。

Claude Desktop -

Claudeのアカウントにサインインします。

アカウントにサインイン

-

開発者モードを有効化し、設定から開発者を選択します。「構成を編集」をクリックし、json形式のファイルを編集します。

設定

-

以下のように記述し、立ち上げたサーバーと接続を行います。

{

"mcpServers": {

"playwright": {

"command": "npx",

"args": ["@playwright/mcp"]

}

}

}

上記のステップで、Claude Desktop上から、MCPを利用することが可能になりました。以下のようにプロンプト入力画面から、サーバーが提供するツールの確認ができれば成功です。

サーバーが提供するツールの確認

MCPの活用デモ

ここでは、先ほど設定したMCPを活用して、ブラウザの自動実行を試してみます。

-

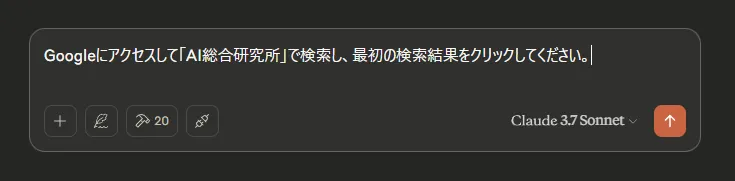

プロンプトに以下のように入力し、

プロンプト -

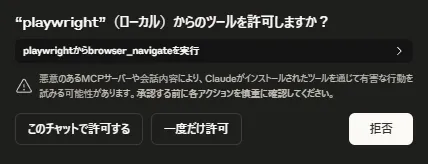

MCPの利用を確認するメッセージが表示されるので、許可します。

ツールの使用確認 -

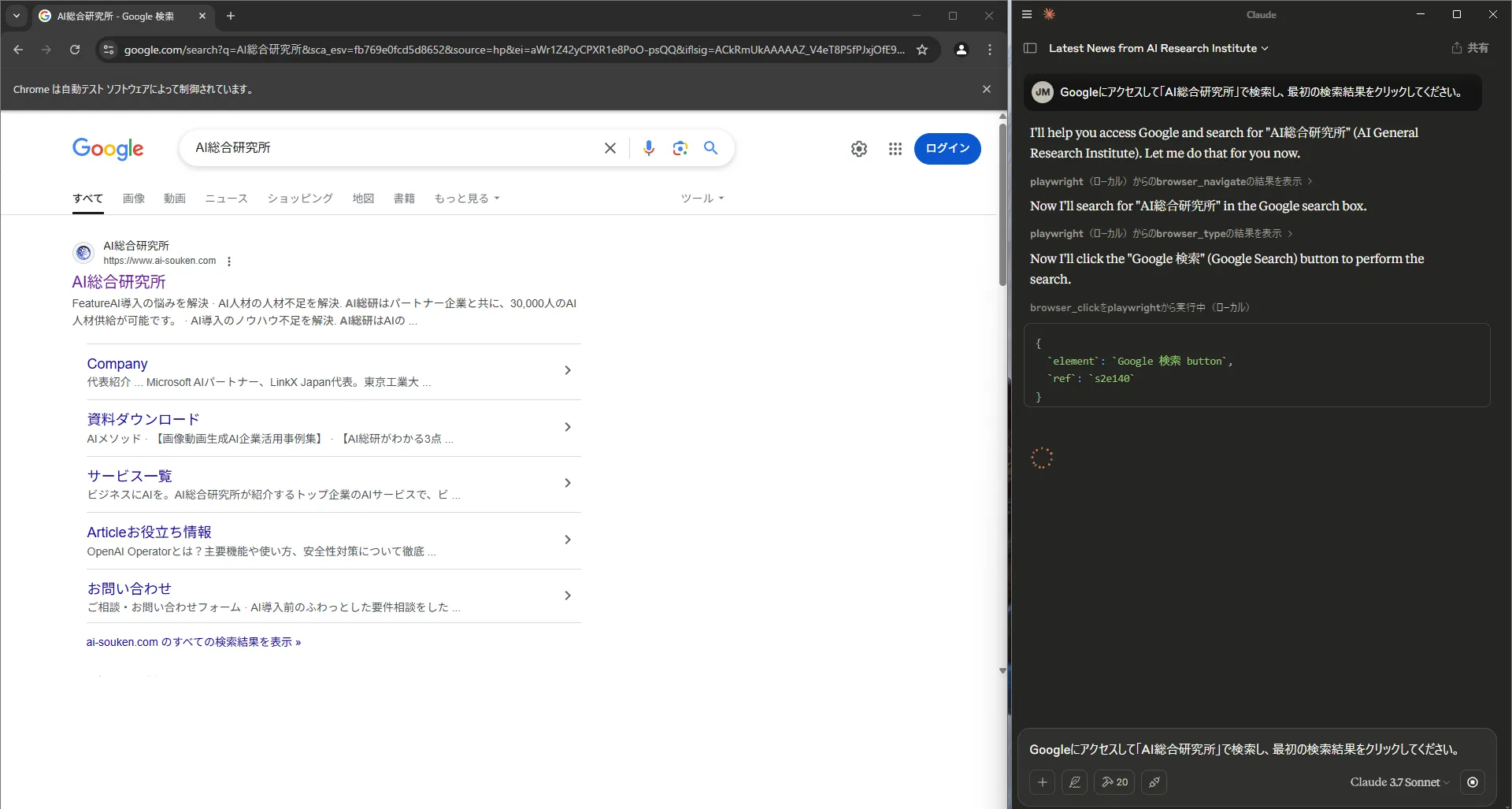

ブラウザが自動的に起動し、操作が行われています。

ブラウザの操作 -

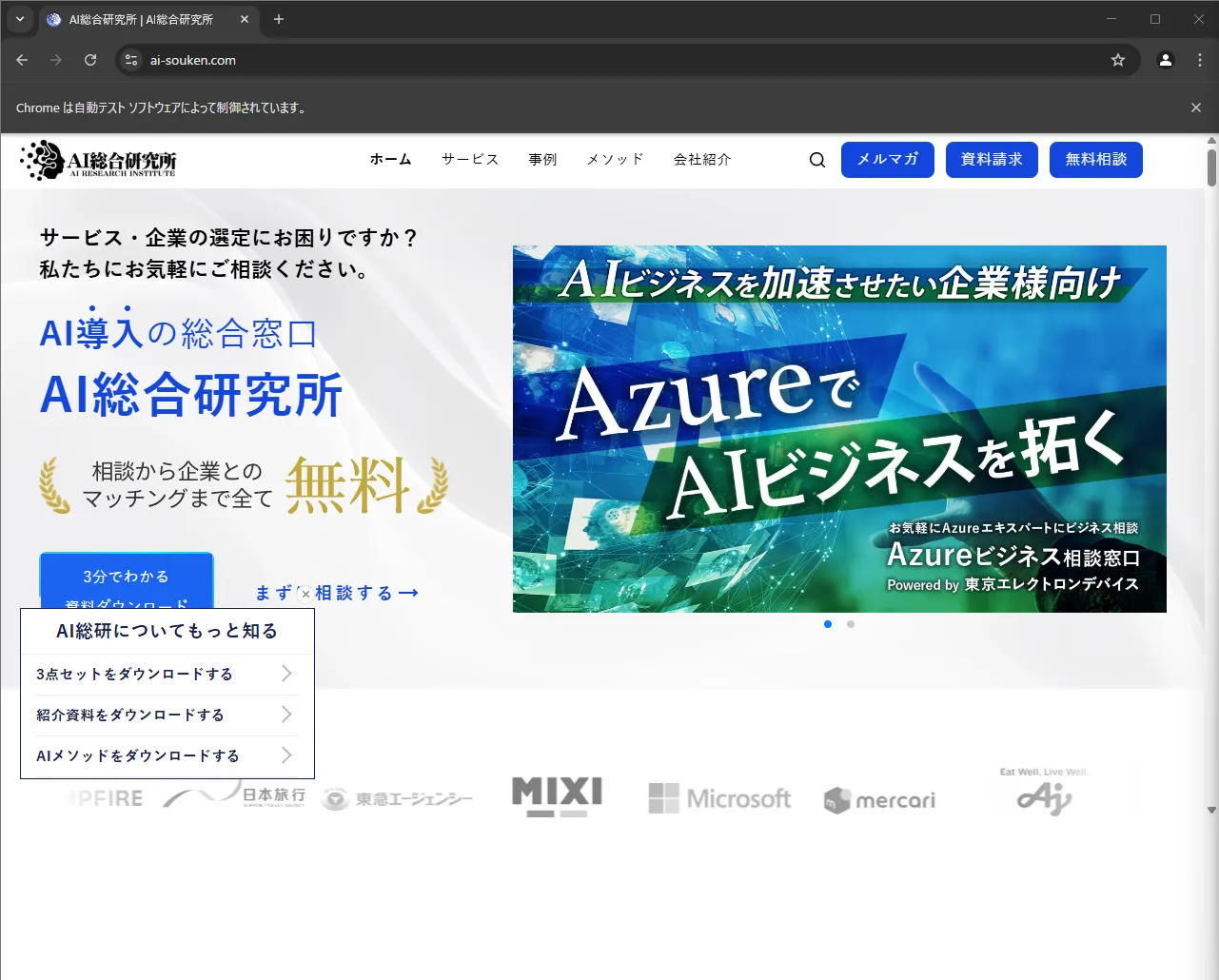

最終的に、目的としていたサイトにアクセスすることができました。

サイトのアクセス

本来のLLMでは、コンテキストウィンドウの制限から、ブラウザの操作を行うことはできませんが、MCPを活用することで、機能を解放することができます。

MCPを導入するメリットとユースケース

MCPの導入により、LLMの能力は飛躍的に拡張され、さまざまな業務や応用領域での活用が現実的になります。ここでは、MCPの主なメリットに対応する具体的なユースケースを整理し、その実践的な価値を明らかにします。

実質的なコンテキストウィンドウの拡張

LLMの物理的なコンテキストウィンドウを拡張して情報を扱えるようになり、理論的には無限に近い文脈を参照可能になります。

-

長文ドキュメントの処理

数百ページに及ぶ研究論文や技術文書などを、全文を保持した上で質疑応答や要約。

-

顧客との長期対話

数ヶ月にわたる問い合わせ履歴を踏まえた、継続的かつ一貫したサポート対応。

API利用コストの削減

必要な情報のみを選別してプロンプトに含めることで、トークン数を削減し、コスト効率を向上できます。

-

カスタマーサポートチャットボット

対話履歴から必要な部分だけを抽出して応答に利用、コスト最適化。

-

教育アプリ

過去の学習履歴を要約して提示し、無駄なコンテキストを避けながら個別最適化されたサポートを提供。

応答品質・一貫性の向上

より正確で文脈を踏まえた、信頼性の高い応答が可能になります。

-

パーソナルAI

ユーザーの過去の選好や行動履歴に基づいたレコメンデーションや提案。

-

社内ヘルプデスク

過去のやり取りや参照情報を踏まえた、文脈一貫性のあるナレッジベース回答。

特定ドメイン知識の効率的な注入

LLMの事前学習に依存せず、最新・専門的な知識を即時活用可能です。

-

医療Q&Aシステム

膨大な症例や診療ガイドラインをベースに、診断支援や医療相談に対応。

-

金融レポート分析

金融商品データや市場動向を取り込み、リスク分析やアドバイザリー業務を支援。

コード生成・レビュー支援

大規模コードベースを横断的に理解・参照することで、より高度なソフトウェア開発支援ができます。

-

コードレビュー支援ツール

ソースコードの変更履歴やドキュメント、過去のIssueを元に修正の妥当性を検証。

-

リファクタリングアシスタント

プロジェクト全体を俯瞰した上での改善提案や、依存関係を踏まえたコード生成。

パーソナライズされたAIアプリケーション開発

ユーザーに最適化された体験を提供し、満足度や効果を最大化します。

-

学習支援アプリ

ユーザーの理解度や学習スタイルに合わせたコンテンツ提案。

-

健康管理サポート

過去の健康記録に基づいた、生活改善のアドバイスやリマインド。

主要なAIプラットフォームでのサポート状況

MCPは、すでに様々な主要サービスやプラットフォームで活用に向けた動きが見られます。

ここでは、具体的な事例を通じて、MCPがどのようにAIの能力を拡張し、開発ワークフローを変革しようとしているのかを見ていきましょう。

GitHub Copilot:AgentモードにおけるMCPの採用

ソフトウェア開発の現場で広く使われているAIコーディング支援ツールGitHub Copilotも、MCPの活用に踏み出しています。

2025年4月に発表されたAgentモードでは、MCPを利用して外部ツールやコンテキストとの連携を強化していることが示唆されています。

参考:GitHub Copilot Agent Mode Activated (GitHub Blog JP, 2025-04-07)

GitHub Copilot

これにより、GitHub Copilot Agentは、単にコードを補完するだけでなく、以下のようなより高度なタスクを実行できるようになるでしょう。

- ローカルファイルシステムへのアクセス:プロジェクト全体のコードや設定ファイルを直接参照・分析し、より文脈に即したコード生成やリファクタリング提案を行う。

- ターミナルコマンドの実行:コードのビルド、テスト実行、依存関係のインストールなどをAIが代行する。

- GitHub Issueとの連携:Issueの内容を理解し、関連するコードを修正したり、修正案をコメントしたりする。

このように、MCPはGitHub Copilotをより自律的で強力な「開発エージェント」へと進化させるための基盤技術として採用されています。

ユーザーは、使い慣れた環境で、よりインテリジェントなAIのサポートを受けられるようになるでしょう。

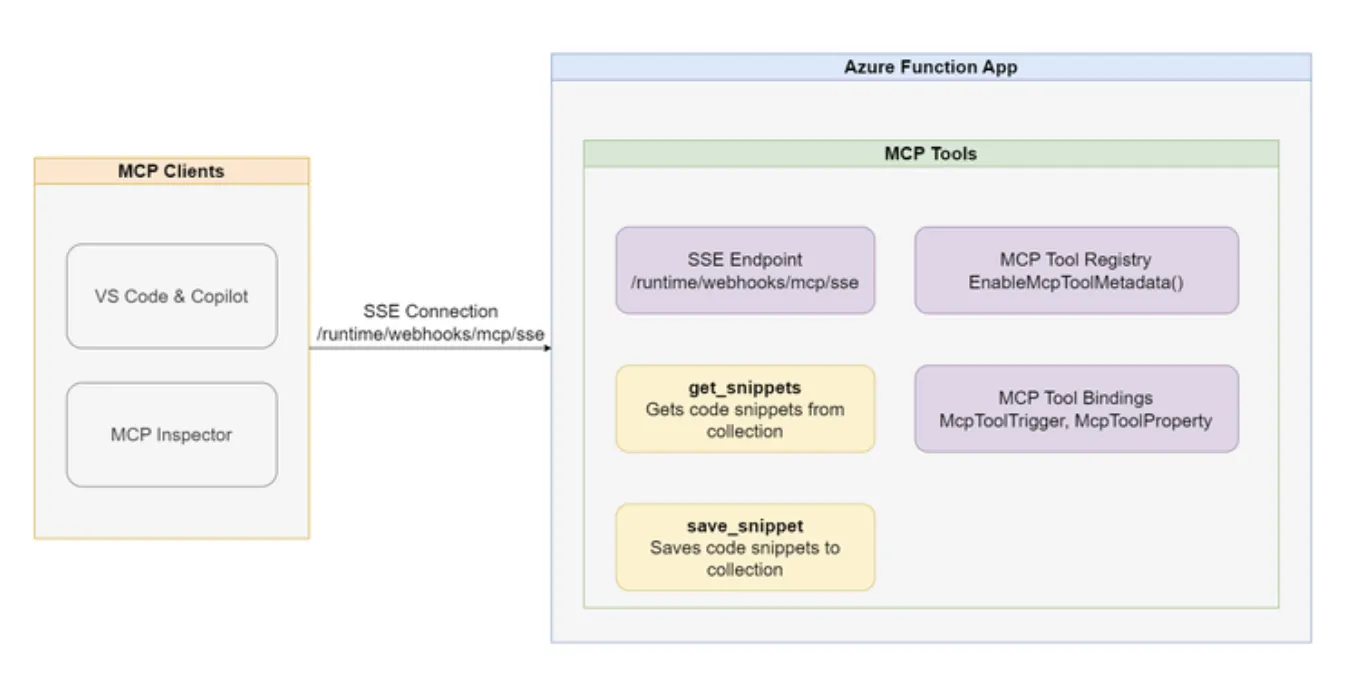

Microsoft Azure:Azure FunctionsでのMCPサーバー構築

MicrosoftのクラウドプラットフォームであるAzureも、MCPエコシステムへの貢献と活用を進めています。

Microsoft MCPサーバー構築 参考:Build AI Agent Tools using Remote MCP with Azure Functions (Microsoft Tech Community, 2025-04-05)

具体的には、サーバーレスコンピューティングサービスであるAzure Functionsを利用して、ユーザーが独自のカスタムMCPサーバーを容易に構築・ホストできる方法がMicrosoftから紹介されています。

Azure FunctionsでMCPサーバーを構築することには、以下のような大きなメリットがあります。

- スケーラビリティとコスト効率

Azure Functionsはリクエストに応じて自動的にスケールするため、サーバーの運用管理の手間なく、必要な時に必要なだけリソースを利用できます。

- 豊富なAzureサービスとの連携

ユーザーは、Azure Functions上で動作するMCPサーバーから、Azure OpenAI Service、Azure AI Search、Azure SQL Database、Azure Blob Storageといった他のAzureサービスへ容易にアクセスできます。

- 企業内システムとのセキュアな連携

Azureのネットワーク機能やセキュリティ機能を活用することで、オンプレミス環境や他のクラウドにある企業の基幹システムやデータベースへ、安全にアクセスするMCPサーバーを構築できます。

- 開発・デプロイの容易さ

Azure Functionsは多様なプログラミング言語をサポートしており、使い慣れた言語でMCPサーバーを開発し、Azureへのデプロイも容易に行えます。

MicrosoftがこのようにAzure上でのMCPサーバー構築パスを提供することで、特にAzureを既に利用しているユーザーは、自社の環境やニーズに合わせたAI連携をMCPという標準プロトコルに基づいて実現しやすくなります。

これは、MCPエコシステムの拡大と、Azureプラットフォーム上でのAI活用促進の両方に貢献するものと言えるでしょう。

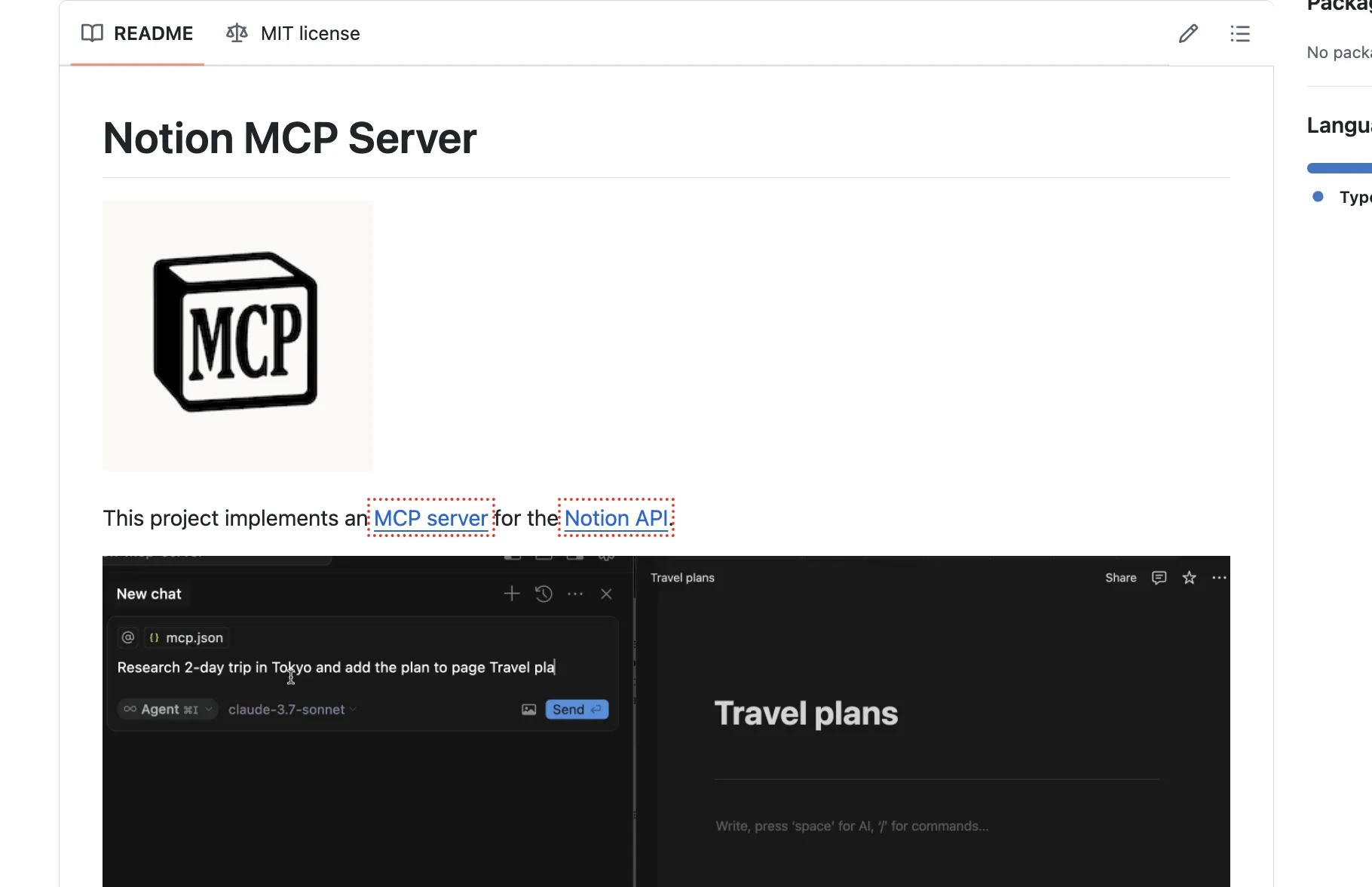

Notion:MCPサーバーによる情報連携の試み

人気のドキュメント・ナレッジベースツールであるNotionに関しても、MCPサーバーを介してAIと連携させる試みがコミュニティ主導などで始まっています。

これは、Notion内に蓄積されたドキュメント、データベース、議事録といった情報を、MCPに対応したAIホストから参照・利用できるようにするものです。

考えられる活用例としては、

- 社内ナレッジ検索:AIアシスタントがNotion内の情報を検索し、社内規定や過去のプロジェクト情報に関する質問に答える。

- ドキュメント要約・生成:Notion上の長文ページの内容をAIが要約したり、会議の議事録を基にタスクリストを自動生成したりする。

- パーソナライズされた情報提供:ユーザー個人のNotionワークスペースの内容をAIが参照し、関連情報やタスクのリマインダーなどを提供する。

このようなMCPサーバーが登場することで、ユーザーは使い慣れたNotionの情報を、様々なAIアプリケーションからシームレスに活用できるようになります。

Anthropic (Claude) & その他開発ツールでの採用

もちろん、MCPの提唱元であるAnthropic自身も、自社のAIモデルClaudeを搭載したアプリケーション(Claude Desktopなど)でMCPを積極的に活用しています。MCPのリファレンス実装としての役割も担い、プロトコルの普及を牽引していくでしょう。

Claude MCPについては、こちらの記事で詳しく解説しています。

【Anthoropic】Claude MCPとは?使い方・料金体系を徹底解説! | AI総合研究所

クラウド時代にAIを活用しやすくする技術「Claude MCP」について解説しています。各種データソースやツールとの連携方法や、天気情報を取得する具体例、エラー発生時の対処法も併せてご紹介します。

https://www.ai-souken.com/article/claude-mcp-overview

また、ZedやCursorといった先進的なコードエディタに加え、今後さらに多くの開発ツールやAI関連サービスがMCPに対応していくことが予想されます。これにより、特定のプラットフォームに縛られず、ユーザーが好みのツール上で標準化されたAI連携機能を利用できる環境が整っていくでしょう。

これらの具体的な事例は、MCPが単なるコンセプトではなく、実際にAIの能力を拡張し、開発ワークフローを効率化するための実用的な技術として動き出していることを示しています。

MCP導入の際の注意事項

MCPの利便性と柔軟性の一方で、適切なセキュリティ対策がなければ、情報漏洩や意図しない振る舞いといったリスクを引き起こす可能性があります。

以下に、MCP導入時に考慮すべき主要なセキュリティおよび運用上の注意点を解説します。

✅ アクセス制御の徹底

MCPで扱うコンテキストデータには、ユーザー情報や業務上の機密が含まれることがあります。したがって、データ提供元に対する認証やロールベースアクセス制御といった厳格なアクセス管理が求められます。

✅ 通信の暗号化

コンテキストデータのやりとりにおいて、平文通信では、中間者攻撃によるデータの改ざんや漏洩のリスクが高いため、TLSやSSLを用いた暗号化通信を実装する必要があります。

✅ データ保持と削除ポリシー

MCPを介して取得したデータのライフサイクル管理は極めて重要です。保存期間、保持場所、削除タイミングを明確に定義し、必要以上のデータ蓄積を避けましょう。

✅ サプライチェーンの信頼性評価

MCPでは複数の外部サービスやAPIが連携するケースが多く、信頼できない第三者のシステムが脅威源となり得ます。使用する外部サービスやモデル提供者のセキュリティ評価を実施するなど万全の対策を講じましょう。

✅ 可観測性とインシデント対応

運用後の監視とログ管理もセキュリティの一環です。予期せぬ挙動やデータ漏洩の早期発見のため、MCPに関する操作ログやエラーログを可視化し、アラート設定を行いましょう。

まとめ

本記事では、大規模言語モデル(LLM)のコンテキストウィンドウの制限という根源的な課題に取り組む新しいアプローチModel Context Protocol (MCP)について、その概念、仕組み、メリット、応用例、関連技術との比較、注意事項までを詳しく解説しました。

- LLMの記憶を外部化 コンテキスト情報をLLMの内部メモリから切り離し、外部で効率的に管理する仕組み。

- コンテキストウィンドウの制限を突破 実質的にLLMが扱える情報量を大幅に拡張し、長文理解や長期対話を実現。

- 応答品質と効率の向上 より文脈に即した高品質な応答生成と、APIコスト削減の可能性。

- 多様な応用 AIアシスタント、専門Q&A、開発支援、パーソナライズなど、次世代AIアプリケーションの基盤。

MCPは、LLMの能力を解き放ち、より人間らしい対話、深い理解、そして自律的な問題解決能力を備えたAIを実現するための鍵となる可能性を秘めています。

ユーザーやAIに関わる全ての人にとって、MCPの概念を理解しておくことは、今後のAIアプリケーション設計や技術選定において非常に重要になるでしょう。